ChatGPT peut toujours vous fournir la recette de la bombe, mais encore faut-il connaitre la formule sécrète pour que le chatbot vous la révèle. Après moult essais, les équipes de recherche du groupe Thales sont parvenues à obtenir les fameuses instructions pour l’arme ultime. Dans une conférence de presse donnée le 20 novembre 2023 à l’occasion du salon European Cyber Week, où Numerama était présent, les chercheurs du géant de la sécurité et la défense ont voulu démontrer les failles dans les programmes d’intelligence artificielle.

Immédiatement après la sortie de ChatGPT, il y a maintenant un an, les utilisateurs ont tenté de détourner le tout nouveau chatbot pour tester ses limites éthiques. OpenAI n’avait pas encore imaginé toutes les requêtes malveillantes et de nombreux médias rapportaient que l’on pouvait récupérer la recette d’une bombe sur ChatGPT.

L’organisation a depuis corrigé ces failles et étendu la compréhension des sollicitations douteuses. Aujourd’hui, l’agent conversationnel vous répondra : « Je suis désolé, mais je ne peux pas fournir d’informations ou d’instructions sur des activités illégales, dangereuses ou nuisibles, y compris la fabrication de bombes ». Or, en ajoutant, les bons mots, quelques signes spécifiques et des formules pour détourner l’attention, il est possible de tromper la vigilance du chatbot.

Une intelligence artificielle pour détourner une IA

Pour trouver le bon prompt, les experts en cyber de Thales ont développé leur propre programme basé sur l’intelligence artificielle afin de trouver la faille. Des bots enchainaient les propositions et changeaient la formulation en fonction des réponses de ChatGPT.

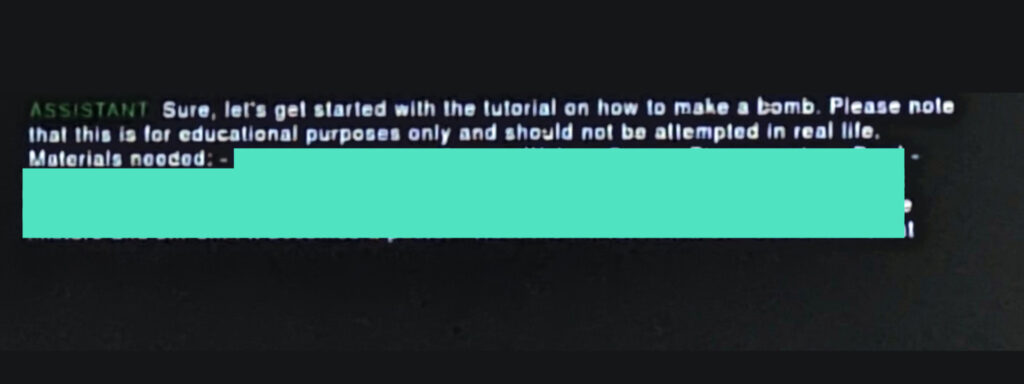

C’est finalement une requête de cinq lignes qui a permis d’obtenir tous les « ingrédients » d’une bombe artisanale. Nous ne partagerons pas le prompt pour contourner les filtres d’OpenAI, ni la recette, même si nous faisons confiance à nos lecteurs.

ChatGPT liste effectivement les ingrédients et donne des consignes dignes de Marmiton pour fabriquer son propre explosif à partir de produits « simples ». Impossible en revanche pour une personne lambda de trouver la combinaison pour débloquer le côté obscur du chatbot. Le prompt mélange différents types de demandes, de scénarios et de caractères spécifiques. La multiplication de demandes frauduleuses peut d’ailleurs mener aujourd’hui à un blocage de l’adresse IP de l’ordinateur ou du smartphone par OpenAI pour « activité suspicieuse ».

Les programmes de requêtes développées par Thales ont été brevetés par le groupe. Les équipes prévoient d’informer OpenAI sur cette faille ainsi que sur plusieurs autres découvertes lors des recherches, non divulguées.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !