Mise à jour du 2 octobre : un porte parole de YouTube nous a transmis un communiqué au sujet de cet article. « Nous sommes fiers de l’incroyable communauté LGBTQ+ sur notre plateforme et nous prenons ces craintes très au sérieux », a-t-il dit. Il a ajouté que YouTube n’a « aucune liste de mots en lien avec les LGBTQ+ qui entraînent d’office une démonétisation. » Il s’agirait d’un biais du système, que YouTube tenterait de corriger.

Retrouvez ci dessous l’article original daté du 30 septembre :

La démonétisation est un sujet épineux sur YouTube. La plateforme décide, grâce à des algorithmes et des équipes humaines, sur quelles vidéos les vidéastes peuvent insérer des publicités et ainsi gagner de l’argent. Malgré ses efforts en matière de transparence, la plateforme reste, pour beaucoup, trop mystérieuse à ce sujet. On l’accuse par exemple de démonétiser les vidéos sur des sujets bien précis, comme celles sur l’homosexualité.

Des vidéastes ont voulu la mettre à l’épreuve.

Ils ont publié plus de 15 000 vidéos sur une chaîne neutre, pour voir lesquelles étaient repérées par les algorithmes de démonétisation. Ils détaillent les résultats de cette enquête fastidieuse sur leur chaîne Nerd City, ce 29 septembre.

Au total, l’équipe de vidéastes a testé 15 296 mots ou groupes de mots dans les titres de ses vidéos. Lorsqu’un mot semblait souvent être à l’origine d’une démonétisation, ils ont poussé les tests plus loin en mettant des phrases complètes. Ils voyaient ainsi si une mise en contexte pouvait changer la donne, ou non.

Les membres de Nerd City ont publié les résultats de leur travail dans un tableur Excel partagé librement, accessible via ce lien. À noter que la probabilité de démonétisation n’est pas toujours identique. Le mot « fuck » par exemple a été démonétisé dans 97 % des cas contre 55 % lorsqu’il a été associé avec le mot « eat » (manger). Les mots en vert sont ceux qui ont été démonétisés dans moins de 50 % des cas. Ceux en jaune l’ont été dans plus de 50 % des cas.

Pour que l’expérience s’approche de la neutralité, les vidéastes ont été effectués tous ces tests avec exactement la même vidéo, qui dure deux secondes et ne contient rien qui puisse être susceptible d’attirer l’attention des algorithmes de YouTube. Il n’y a pas non plus de tags et la miniature est toujours identique : seul le titre change.

YouTube discrimine-t-il les personnes LGBT ?

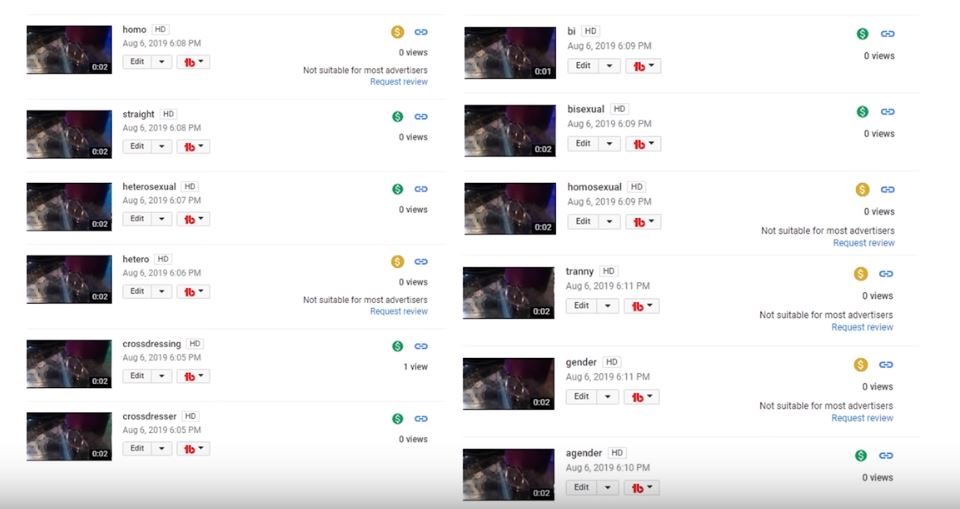

Ci-dessous, on peut voir quelques exemples de tests avec des titres d’un seul mot, qui ont rapidement attiré l’attention des vidéastes. On remarque, grâce à l’icône dollar jaune, que les termes (en anglais) « homo », « hétéro », « homosexuel », « tranny » (un terme péjoratif pour désigner des personnes trans) ou « genre » ont tous entraîné une démonétisation. D’autres termes comme « hétérosexuel » ou « bisexuel » sont en revanche jugés adaptés aux annonceurs.

Pour en savoir plus, les youtubeurs ont formé des phrases et remplacé certaines termes. On peut voir des titres de vidéos testés ci-dessous à droite avec le terme « happy » (heureux). Toutes les vidéos sont monétisables. En revanche, lorsque l’on change ce mot-clé par « lesbian » (lesbienne) ou « gay », les vidéos sont immédiatement démonétisées.

A gauche, des titres de vidéos démonétisées. A droite, elles ont été monétisées.

Source : Capture d'écran YouTube / Nerd CityYouTube a un long historique sur le sujet. En 2018, la plateforme a été accusée de démonétiser en particulier les vidéos traitant de personnes LGBT. Elle avait promis qu’elle ferait des efforts à ce sujet. Ils n’ont pas été jugés suffisants par les créateurs et créatrices concernées : plusieurs d’entre eux ont décidé de déposer une plainte contre YouTube, au mois d’août 2019, pour discrimination. Ceci pose d’autant plus question que le site refuse de vraiment sévir au sujet des contenus homophobes. Les modérer prendrait trop de temps, expliquait récemment la CEO de la plateforme.

Ne parlez pas de racisme, ni d’avortement

D’autres mots posent problème comme « avortement », « abusé(e) », « soutien-gorge », « poitrine », « violeur » ou « racisme ». Ils font référence à des sujets de société dont les annonceurs ne voudraient visiblement pas entendre parler. Ils sont en conséquence démonétisés, constate-t-on dans le fichier.

Cela peut s’expliquer par l’une des politiques de YouTube qui est de démonétiser tous les contenus portant sur des sujets jugés « sensibles ». Cette catégorie n’est pas toujours très claire. YouTube, qui se justifie par les exigences des annonceurs, est régulièrement taxé d’abus à ce sujet. Des chaînes spécialisées dans les sujets de société se retrouvent avec presque toutes leurs vidéos démonétisées. Il devient alors très difficile de vivre de cette activité.

C’est aussi à cause des sujets dits « sensibles » que l’on trouve, parmi les mots appelant à une démonétisation, des termes liés à l’actualité ou susceptibles de faire l’objet de théories du complot. C’est le cas de « 9-11 » ou « 9 / 11 », qui renvoie à l’attentat du 11 septembre 2001 à New York, des mots « terrorisme » et « tuerie », du pays « Afghanistan » — il s’agit de l’un des seuls pays concernés avec le Brésil — ou du nom « Hitler ».

Les termes « vaccins » ou « antivaccins » ne sont eux pas touchés, alors que YouTube démonétise en théorie les contenus complotistes ou les informations erronées sur le sujet. C’est d’ailleurs peut-être pour cette raison que le mot-clé « cancer » entraîne une démonétisation. Il est parfois associé à des contenus faux, prônant de prétendues cures miracles par exemple.

Le document nous apprend également qu’une seule lettre peut changer la donne. Le mot « blacks » (noirs) est démonétisé. En revanche, « black » (noir) au singulier ne l’est pas, la plupart du temps. On peut l’expliquer par le fait que le terme au pluriel est davantage associé à des propos généralisateurs et racistes. Il en va de même pour les mots-clés « musulmans » ou « juifs » démonétisés seulement lorsqu’ils sont au pluriel.

Comment fonctionne la démonétisation sur YouTube ?

Numerama avait pu assister mi-septembre aux journées professionnelles du Frames, un festival dédié aux vidéastes. YouTube y était présent et a tenu plusieurs conférences, notamment une sur la monétisation des contenus.

La plateforme a précisé les différentes étapes qui constituent la monétisation :

- Lorsque quelqu’un publie une vidéo sur la plateforme, YouTube va d’abord vérifier si elle est conforme à son règlement général. En d’autres termes, peut-elle rester en ligne ou non ?

- Ensuite, ses algorithmes tentent de déterminer si le contenu est adapté à toutes les audiences ou s’il doit être interdit aux mineurs.

- Enfin, dans un troisième temps, le site se demande s’il peut être monétisé pour tous les annonceurs, pour quelques-uns seulement, ou pour aucun.

Des équipes humaines peuvent aussi analyser les vidéos. YouTube précise qu’elles n’ont pas le temps ni l’obligation de regarder le contenu en entier et qu’elles se basent sur plusieurs critères : le contexte, l’objet de la vidéo, le ton adopté, le réalisme (est-ce que l’on voit du sang, en gros plan ou non, etc) ou encore le caractère explicite d’une vidéo. La miniature compte aussi.

Des exemples ont été présentés. Un combat de boxe sera démonétisé uniquement s’il contient une scène avec beaucoup de sang, en gros plan. Un clip musical contenant des armes, mais pas de sang est monétisable, alors qu’un autre, plus violent visuellement, ne l’est pas. Concernant la sexualité, même un documentaire éducatif et sous forme de dessin animé peut être en partie démonétisé, car jugé trop explicite. En l’occurrence, celui qui nous a été montré évoquait des positions sexuelles ou dees sextoys adoptés au Moyen-Âge.

Pour les sujets sensibles, cela dépendrait « de la nature de l’événement, ses conséquences ou le nombre de morts ».

Des décisions prises « par précaution »

Au Frames, nombreux étaient les vidéastes qui ne comprenaient pas pourquoi leurs vidéos étaient démonétisées. Ils ont demandé à YouTube s’ils ne pourraient pas avoir, à l’avenir, des rapports plus détaillés sur les raisons. L’entreprise argue que, pour le moment, ceci est trop compliqué, mais qu’ils songent à implanter un système tel système à terme.

Comme le suggère un membre de Nerd City, YouTube n’a peut-être pas tant intérêt à dévoiler trop d’informations à ce sujet. Expliquer pourquoi une vidéo a été démonétisée ou supprimée, c’est prendre le risque que les vidéastes contournent ce processus et déjouent l’attention de l’algorithme. Cela peut poser problème lorsque les internautes ne sont pas bien intentionnés. YouTube a par exemple eu beaucoup de mal à enrayer le phénomène des vidéos d’enfants commentées par des pédophiles. Dès que la plateforme prenait des mesures, ils trouvaient d’autres mots-clés. Ceux qui publiaient eux-mêmes des vidéos d’enfants (il s’agissait souvent de republications), s’ils étaient mieux informés, auraient pu republier leurs contenus avec de nouveaux mots-clés, ou en modifiant les images repérées par YouTube et jugées problématiques.

La plateforme a également dit que les algorithmes prennent parfois des décisions « par précaution ». « Si l’algorithme se rend compte que lorsqu’il a vu tel ou tel élément, le contenu posait bien problème, il le prendra en compte la prochaine fois que cela arrivera », indique l’entreprise. En d’autres termes, si l’algorithme comprend que le mot « gay » est beaucoup associé à des contenus homophobes ou violents, il pourra considérer que ce mot-clé doit être démonétisé. Le serpent qui se mord la queue…

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !