Mouvement et forme des doigts, orientation de la main, suite et répétition de gestes, mais aussi déplacement de la tête et expression du visage. Pour le profane, la langue des signes est impénétrable sans une solide formation préalable : la gestuelle est codifiée, les formes nombreuses et l’exécution rapide. Alors pour un ordinateur, la tâche apparaît herculéenne.

Les progrès de la technologie ouvrent pourtant des perspectives enthousiasmantes : on a vu par exemple des ordinateurs apprendre la langue des signes en regardant la TV ou bien des gants bardés de capteurs capables d’interpréter des gestes pour ensuite les retranscrire via une synthèse vocale. Dans le même ordre d’idée, les récents travaux conduits par Google prolongent cette tendance.

Détection en temps réel sur smartphone

Dans une publication technique datée du 19 août, Valentin Bazarevsky et Fan Zhang font la présentation d’une méthode leur permettant de suivre en temps réel les mouvements de la main. Plus remarquable encore, le système imaginé est capable de percevoir la main en profondeur, ce qui lui permet de savoir quelles sont les parties proches ou éloignées par rapport à la caméra.

« La perception de la main en temps réel est un travail de vision par ordinateur très difficile, car les mains s’occultent souvent elles-mêmes ou les unes les autres et manquent de motifs très contrastés », font remarquer les deux ingénieurs. En outre, le mouvement de la main est rapide et parfois fugace : non seulement il faut tout capter, mais également tout bien interpréter.

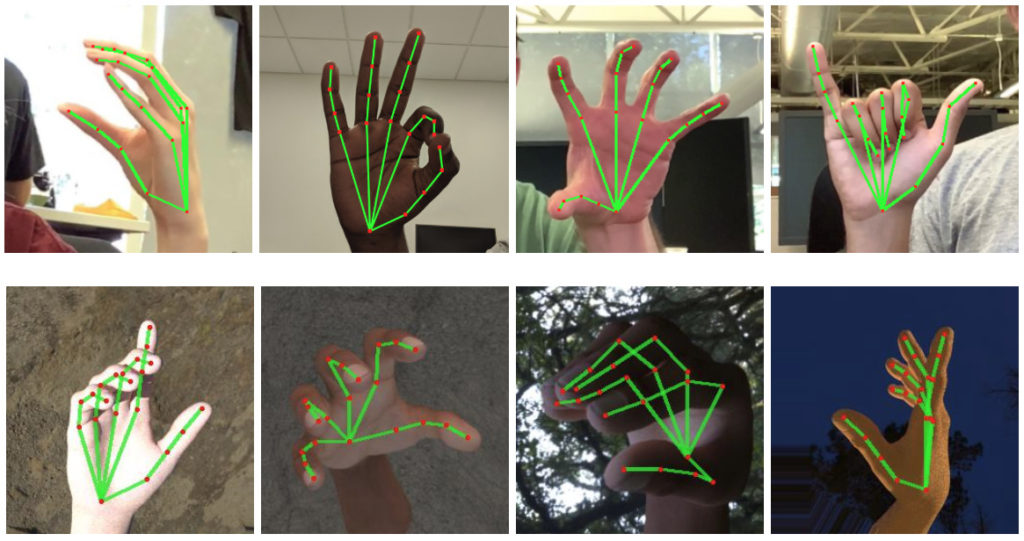

Pour cette recherche, la détection de la main à l’image mobilise des algorithmes ainsi que de l’apprentissage automatique. La main est pour ainsi dire cartographiée à travers une carte de 21 points. Le résultat aboutit à quelques intersections (base de la main, phalanges, extrémités…) qui sont reliées entre elles par des lignes pouvant varier du blanc au gris, afin de représenter la proximité par rapport à la caméra, et donc la profondeur.

Mais ce n’est pas la seule réussite accomplie. Les deux hommes vantent aussi la légèreté de leur dispositif : « Alors que les approches actuelles les plus abouties reposent principalement sur de puissants environnements de bureau, notre méthode permet d’obtenir des performances en temps réel sur un téléphone mobile ». Indispensable pour espérer un jour percer auprès du grand public.

Dans les images de démonstration, ils ont montré qu’ils ont pu associer certains sens à des gestes courants que l’on fait avec la main, comme « ok », le pouce en l’air d’approbation, le lance-toile de Spiderman, le poing fermé, le signe des cornes qu’affectionnent les amateurs de métal, le V de la victoire, etc. Ils peuvent même détecter plusieurs mains dans une même séquence.

Encore beaucoup de chemin à parcourir

Dans le cadre d’un développement pour la langue des signes, un long chemin reste en tout cas à parcourir : capter le geste ne fait pas tout. Il faut aussi le décomposer (son début, son exécution, sa fin), l’identifier et lui donner du sens, en le codant. Cela nécessite de prendre en compte des spécificités linguistiques d’un pays à l’autre, dans la mesure où il n’y a pas de langue des signes universelle : la France a ainsi la sienne.

Autre difficulté qui attend les équipes d’ingénierie : capter et interpréter des signes à la suite et donner du sens à cet enchaînement logique. Pour cette dernière étape, la seule lecture des mains et des doigts n’apparaît pas suffisante : les expressions faciales et les mouvements de la tête devront aussi être détectées et interprétées, et surtout associées logiquement avec le reste.

Naturellement, l’avancée obtenue par Valentin Bazarevsky et Fan Zhang n’est qu’un pas modeste vers un système qui serait capable de comprendre parfaitement la langue des signes. D’ailleurs, les deux hommes n’évoquent que très peu les débouchés dans cette direction. Il faut dire qu’il y a encore beaucoup de travail. Pour l’heure, ils ont surtout décidé de donner accès à leur technologie.

« Nous croyons que la publication de cette technologie peut donner une impulsion à de nouvelles idées créatives et applications par les membres de la communauté de la recherche et du développement », expliquent-ils. De leur côté, ils entendent améliorer la robustesse et la fiabilité de leur approche, en particulier en augmentant le nombre de gestes détectables de façon efficiente.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !