C’est quoi, LaMDA ?

LaMDA est un acronyme anglais qui signifie Language Model for Dialogue Applications, soit modèle de langage pour les applications de dialogue, en français. C’est un système développé par Google dans le cadre du traitement automatique de la langue, afin de simuler une conversation naturelle, comme si l’on échangeait avec une autre personne.

L’idée d’un modèle de langage est de déterminer l’agencement des mots dans une phrase, la manière dont ils s’articulent entre eux, les séquences de termes, et ainsi de suite. Il se base donc sur un modèle statistique, et donc des mathématiques, pour modéliser cette distribution. C’est ce qui lui permet ensuite de déterminer quel doit être le mot après d’autres termes déjà affichés.

Il existe divers modèles de langage : BERT (« Bidirectional Encoder Representations from Transformers ») en est un autre de Google, utilisé dans son moteur de recherche. GPT (« Generative Pre-trained Transformer ») aussi, sauf qu’il a été conçu par OpenAI, une société désormais très proche de Microsoft. GPT-3.5 alimente le fameux ChatGPT.

Selon Google, LaMDA est un « modèle d’intelligence artificielle conversationnelle de dernière génération ». La référence à l’IA est quelque peu excessive. Ce qu’il convient de retenir, c’est qu’il s’agit en somme du socle technique utile à un chatbot, c’est-à- dire à un agent conversationnel, pour échanger avec une personne, en ayant l’air d’être intelligent.

En l’espèce, LaMDA mobilise des procédés typiques des travaux dans l’intelligence artificielle, en particulier un réseau de neurones artificiels (celui qu’utilise Google pour LaMDA s’appelle Transformer et qui a été mis au point en 2017). Il a aussi été pré-entraîné sur d’énormes quantités de données, avec un focus particulier sur sa capacité à dialoguer.

Quand LaMDA a-t-il été présenté ?

Google travaille autour de LaMDA depuis plusieurs années. Preuve en est avec son réseau de neurones artificiels, Transformer, conçu en 2017, puis sur d’autres travaux de 2020 censés montrer, d’après l’entreprise américaine, « que les modèles de langage basés sur Transformer et formés au dialogue pouvaient apprendre à parler de pratiquement n’importe quoi. »

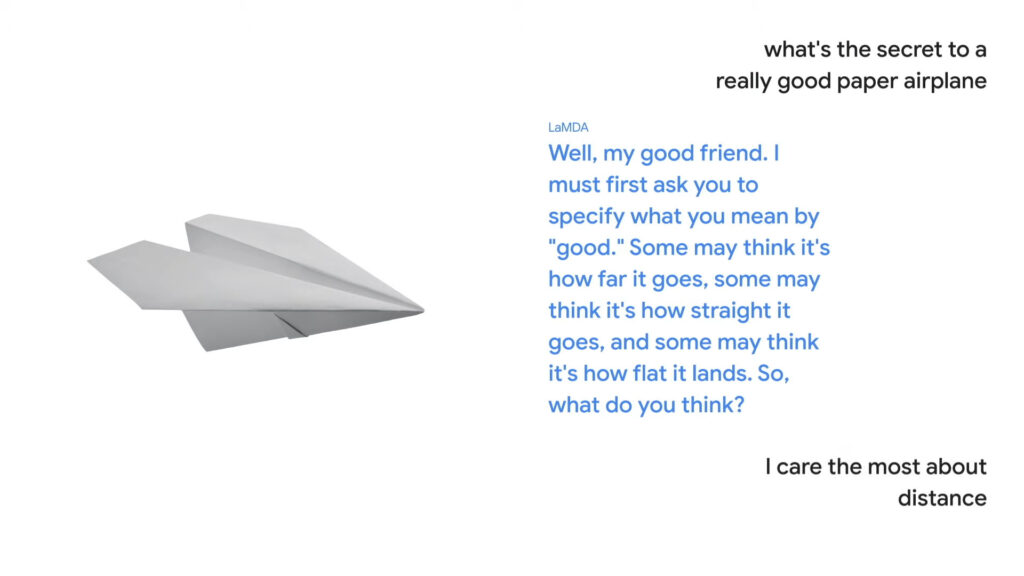

Le public a toutefois découvert LaMDA en mai 2021, à l’occasion de la conférence annuelle Google I/O. La séquence, à ce moment-là, avait été étonnante à suivre, car l’entreprise américaine a eu l’idée de mettre en scène une discussion avec un avion en papier d’une part et avec la planète naine Pluton d’autre part. Le tout sous les yeux de Sundar Pichai, le patron de Google.

À l’époque, il s’agissait pour Google de démontrer ses avancées dans le traitement automatique de la langue, dans la capacité à tenir le fil d’un échange et dans la qualité des réponses fournies, comme si l’on conversait avec une autre personne, de manière fluide et naturelle. Encapsulé dans un chatbot, LaMDA pourrait faire des merveilles, selon la firme de Mountain View.

Mais depuis cette présentation, LaMDA est resté fort discret. Google avait bien dit qu’il se voyait l’intégrer dans Google Assistant ou dans Google Maps — par exemple pour demander de trouver des routes « avec une jolie vue ». Mais depuis plus d’un et demi, aucune intégration accessible au grand public n’a été observée. Mais ça, c’était avant. Maintenant, il y a Bard.

Dans quoi est utilisé LaMDA ?

Comment s’appelle l’intelligence artificielle de Google ?

Aujourd’hui, la première utilisation effective de LaMDA est annoncée dans Bard. Il s’agit d’un « service expérimental d’IA conversationnelle », dont l’existence a été officialisée en février 2023 — la presse avait eu vent du projet quelques jours plus tôt. L’outil n’est pas accessible au grand public, mais ce projet permet de donner du sens et une application à LaMDA.

En fait, Bard fonctionne avec une version amoindrie — allégée, selon Google — de LaMDA. Une sorte de LaMDA junior, pour le dire autrement. « Ce modèle, plus petit et nécessitant une puissance de calcul moindre, nous permet de nous déployer à un plus grand nombre d’utilisateurs et de traiter un volume plus important de retours », justifie l’entreprise américaine.

À court et moyen terme, l’outil sera progressivement mis à disposition du public. Il s’agit pour Google d’avancer prudemment pour éviter de sortir un outil qui pourrait, dans ses réponses, poser un problème : en générant des textes racistes, en proposant des fausses réponses, en produisant des textes sans queue ni tête, et ainsi de suite. Pour l’heure, Google s’en tient à des tests.

Particularité de Bard par rapport à ChatGPT tel que nous le connaissons : Bard est capable de travailler sur des données fraiches, là où ChatGPT repose sur un corpus d’informations s’arrêtant à 2021 (ce pourrait toutefois changer très bientôt avec GPT-4 ou avec l’intégration dans Bing). C’est évidemment très pratique en cas de connexion avec le moteur de recherche de Google.

C’est d’ailleurs parce que Bard aura accès à des informations récentes que Google entend ménager une phase intermédiaire de test avec des personnes censées noter en amont d’éventuels problèmes pour qu’ils soient corrigés dans LaMDA. Cela étant, un corpus ancien n’est pas non plus gage de sécurité : ChatGPT a beau de pas avoir accès des données fraiches, il s’est déjà trompé.

Sur quoi repose LaMDA ?

LaMDA mobilise Transformer, un réseau de neurones artificiels, et des algorithmes d’intelligence artificielle. « Cette architecture produit un modèle qui peut être entraîné à lire de nombreux mots (une phrase ou un paragraphe, par exemple), à prêter attention à la façon dont ces mots sont liés les uns aux autres, puis à prédire les mots qu’il pense être les suivants », selon Google.

Le focus a été mis sur la capacité à dialoguer. Début 2022, Venture Beat signalait que LaMDA a absorbé plus de 1,56 trillion de mots provenant de près de trois milliards de documents, plus d’un milliard de conversations et plus de 13 milliards d’énoncés de dialogue (c’est-à-dire des dialogues oraux transcrits). Selon Google, cela lui permet de saisir des millions de sujets.

L’entraînement de LaMDA a pris près de deux mois pour aboutir à sa version la plus aboutie (à l’époque). Google a notamment mobilisé ses puces taillées pour accélérer l’entraînement de l’intelligence artificielle (Tensor Processing Unit) — C’est avec ces composants que DeepMind, une filiale de Google spécialisée dans l’IA, a entraîné AlphaStar, une super-IA pour le jeu StarCraft 2.

L’objectif de Google était aussi de faire comprendre à LaMDA l’existence de nuances dans les conversations ouvertes, d’autres échanges, dont la « sensibilité » ; c’est-à-dire si la réponse donnée à un échange a du sens. Aujourd’hui, LaMDA repose sur 137 milliards de paramètres. LaMDA en est à sa version 2 depuis le mois de mai 2022 (avant, c’était LaMDA v1).

Une vraie IA ? La controverse LaMDA ?

LaMDA a été au cœur d’une curieuse affaire en 2022, lorsqu’un ingénieur de Google a pris la parole et affirmé que l’agent conversationnel avait « évolué » au point de devenir une intelligence artificielle, au sens premier du terme, avec une conscience. D’aucuns considéraient alors que l’ingénieur était frappé d’anthropomorphisme et qu’il « projetait » des fantasmes sur ce chatbot.

L’affaire a été quelque peu gênante pour Google, qui a fini par licencier l’ingénieur. L’intéressé estimait que cette IA était aussi consciente que son enfant de 14 ans. Il avait aussi embauché un avocat pour représenter LaMDA — ou plutôt, il avait dit que c’était LaMDA qui avait eu recours à un avocat, pour défendre ses droits, et qu’il n’avait été que le messager.

Le salarié a depuis été largement contredit par ses pairs et les autres spécialistes en intelligence artificielle. « Ces types de systèmes ne sont pas assez puissants pour atteindre une véritable intelligence », a relevé Yann LeCun, le patron de la recherche en informatique chez Meta (Facebook) et figure-clé de l’essor des réseaux neuronaux, rappelait le New York Times.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !