C’est une décision qui passerait presque inaperçue, tant l’annonce de l’arrivée prochaine du chiffrement de bout en bout sur iCloud prend toute la lumière. Elle tient en une phrase. Au détour de son entretien avec le Wall Street Journal, le 7 décembre 2022, Craig Federighi, le vice-président d’Apple et patron de l’ingénierie logicielle, a confirmé l’arrêt d’un projet qui a fait couler beaucoup d’encre en 2021.

Un outil de lutte contre la pédopornographie

L’outil en question devait entrer dans la lutte contre la diffusion et le stockage de contenus pédopornographiques (que l’on appelle en anglais CSAM, pour child sexual abuse material). Il a été présenté à l’été 2021. L’ambition de l’entreprise américaine ? Mobiliser un logiciel capable de scanner les contenus sur l’iPhone pour détecter ce genre de fichier.

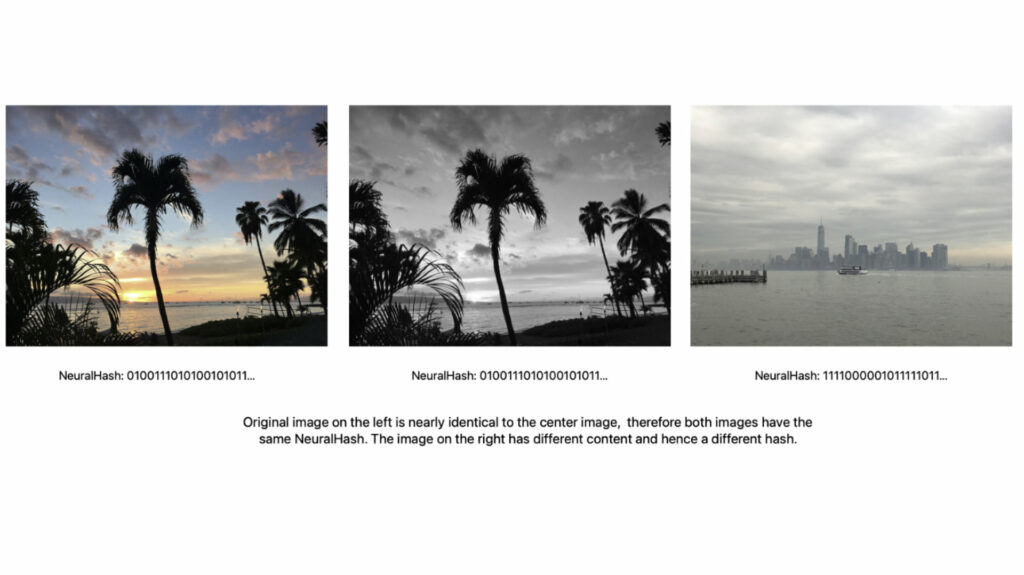

Cet outil, baptisé NeuralMatch, fonctionnait en récupérant la signature d’une image envoyée sur iCloud (dans le cadre de la sauvegarde de l’iPhone) pour la comparer avec les signatures de clichés pédopornographiques figurant dans une base de données. Si plusieurs correspondances étaient relevées, une alerte devait être émise pour des investigations supplémentaires.

Lors de la présentation de cet outil, Apple avait pris soin de décrire les mesures de protection pour éviter les faux positifs et les dérives. Cela n’avait pas permis d’éteindre les critiques contre NeuralMatch, apparues immédiatement après sa présentation ; celles-ci considéraient que la firme de Cupertino mettait le doigt dans un engrenage dont elle ne pourrait pas se défaire.

NeuralMatch a été critiqué d’emblée

Devant la levée de boucliers et les craintes de voir cet outil aux finalités légitimes être détourné un jour — pour d’autres types de contenus illicites à la demande des autorités, en élargissant de plus en plus le spectre des demandes — ou affaiblir la confidentialité des contenus sur l’iPhone, la société avait fini par tout mettre en pause.

À l’époque, la société justifiait ce report pour avoir davantage de temps afin de corriger certains aspects de NeuralMatch, dans le but de tenir compte des retours du public, mais également des spécialistes et des organisations de défense de la vie privée. Mais plus d’un an après, c’est un revirement dans les plans du groupe, puisqu’il n’est plus question de développer NeuralMatch.

L’arrêt de NeuralMatch ne signe pas le renoncement d’Apple pour combattre les contenus pédopornographiques, ni les efforts du groupe pour préserver la tranquillité des individus, notamment mineurs. La preuve : avec iOS 16, iPadOS 16 ou macOS Ventura, il y a maintenant une option qui opère localement sur l’appareil pour filtrer la nudité non sollicitée.

Apple n’aurait pas été la première entreprise tech à explorer cette analyse contre les contenus CSAM. En 2014, Google avait signalé aux autorités un internaute qui avait envoyé des photos pédopornographiques via Gmail. La firme de Mountain View a depuis mobilisé d’autres outils pour les combattre. En Europe, il existe aussi des réflexions sur ce sujet. Un plan de bataille a d’ailleurs été présenté en 2022, mais il a, lui aussi, déclenché une vive controverse, pour les mêmes raisons.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !