J’aime beaucoup le mème du milkshake duck. Né en 2016 grâce à un tweet rigolo, il est une métaphore très efficace pour une situation qui se répète souvent en ligne. Quand une personne devient soudainement populaire grâce à ses contenus charmants et/ou amusants, il y a de fortes chances pour qu’on apprenne un peu plus tard un terrible secret sur elle (souvent sous la forme de vieux tweets racistes).

Internet est plein de canards et de milkshakes. Dernier exemple en date : notre fascination collective pour ChatGPT, une interface qui nous permet de « dialoguer » avec une version de GPT-3.5, un modèle de langage (une application possible du traitement automatique des langues, l’un des domaines de recherche en intelligence artificielle) développé par la société OpenAI. Les géants du numérique semblent s’accorder sur le fait que l’intelligence artificielle (ou IA) va bouleverser notre futur. Plus surprenant, ce futur paraît pour le moment plutôt intéresser les internautes lambdas, qui se sont vite emparées de ChatGPT pour créer leurs propres textes. Et puis le canard a renversé son milkshake.

La semaine dernière, le magazine TIME a publié une longue enquête (un résumé en français est disponible chez Numerama) sur les conditions de travail au sein d’un sous-traitant d’OpenAI. Cette entreprise se spécialise dans « l’IA éthique », en aidant ses clients à rendre leurs logiciels moins toxiques. Dans le cadre de son partenariat avec OpenAI, des travailleurs et travailleuses kenyans étaient payés jusqu’à 2 dollars de l’heure pour consulter à la chaîne des textes violents, haineux, ou décrivant des situations d’abus sexuels, et leur attribuer un tag approprié. Le but : que les modèles développés par OpenAI ne puissent pas reproduire des contenus problématiques.

Dans l’enquête du TIME, de nombreuses personnes témoignent de leur traumatisme face à ce déluge d’immondices. L’une raconte, par exemple, ses cauchemars d’une scène qu’elle a été forcée de lire, décrivant un homme violant un chien devant les yeux d’un enfant. Ce genre de travail éprouvant est pourtant « une étape nécessaire » pour créer des IA plus sûres, a répondu un porte-parole d’OpenAI.

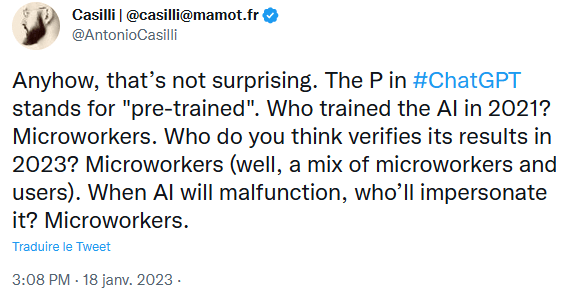

Hélas, il n’a pas tout à fait tort. Car une intelligence artificielle n’a rien de magique, ni finalement de très intelligent. C’est un dispositif créé, puis maintenu par le travail humain. Non seulement des développeurs et des développeuses, mais aussi ce qu’on appelle des travailleurs et des travailleuses du clic, qui sont chargées d’entraîner ces programmes (par exemple, en triant et en annotant des bases de données) puis de vérifier constamment leur production. Le but est d’obtenir des résultats d’une meilleure qualité, et aussi d’éviter les polémiques de type Tay, l’agent conversationnel de Microsoft qui est devenue nazie moins de 24 heures après sa mise en ligne. Depuis des années, journalistes et militants dénoncent les biais des IA, qui ont la fâcheuse tendance à discriminer les personnes déjà victimes de discriminations. C’est un débat important, qui a poussé beaucoup d’entreprises à mettre en place des systèmes de vérification plus robustes. Or, ces derniers reposent sur du travail du clic invisible, mal-payé, parfois violent.

La semaine dernière, une autre actu a attiré mon attention : chez Vice, j’ai appris que des personnalités de l’alt-right et du mouvement conservateur américain s’inquiétaient des biais des IA. Mais pas pour lutter contre le racisme ou le sexisme automatique des machines. Elles craignent que ChatGPT soit trop « woke » (mot qui ne veut rien dire, mais qu’on pourra traduire dans ce contexte par « trop inclusif »). Cela démontre bien que le débat sur les biais des IA a atteint un certain niveau de maturité, au point d’être récupéré par des personnes qui le vident de son sens. Cela démontre, aussi, que ces enjeux sont loin d’être résolus.

Beaucoup de questions restent en suspens. De quels biais parle-t-on exactement ? Y a-t-il des biais acceptables (une IA volontairement féministe, par exemple), d’autres qui ne le sont pas ? Et peut-on vraiment entraîner une IA de manière « éthique », si ces améliorations profitent à une catégorie de la population, tout en exploitant et traumatisant une autre ? À ce propos, on pourra relire cette super série d’articles du MIT Technology Review sur la notion « d’AI Colonialism », où comment l’IA répète notre histoire coloniale, en laissant des pays privilégiés profiter des ressources d’autres nations plus pauvres. Et si le seul choix éthique possible, c’était de ne pas utiliser d’IA du tout ?

La revue de presse de cette semaine

Choisir sa famille

Jennifer Daniel est à la tête du sous-comité Emoji du Consortium Unicode, et aussi l’autrice d’une super newsletter où elle raconte les enjeux de son travail (qui consiste, donc, à proposer des nouveaux emojis). Dans la dernière édition de son infolettre, elle raconte la difficulté à représenter le concept de famille dans toute sa diversité, et inclure le plus d’expériences possibles.

No more eros

Dans la droite lignée du sujet de la newsletter de la semaine dernière, le youtubeur Intercut a dénoncé la suppression brutale de sa chaîne. En cause, une vidéo traitant d’un court-métrage où il est notamment question de sexualité. Le vidéaste critique l’absence de communication de la part de YouTube, et l’injustice de ses règles qui ne sont pas appliquées de la même manière pour tous les créateurs et créatrices de contenus. Après quelques plaintes et mises en relation avec YouTube, il a vu sa chaîne réinstaurée, mais doit remonter la vidéo.

Derrière les barreaux

Vous avez probablement entendu parler d’Andrew Tate, pour ses vidéos violemment misogynes qui se sont répandues sur TikTok et YouTube l’année dernière. L’influenceur anglo-américain a récemment été arrêté et incarcéré provisoirement en Roumanie pour suspicion de trafic d’êtres humains, viols et criminalité en bande organisée. Il est accusé d’avoir forcé des jeunes femmes à créer des contenus pornographiques pour des sites spécialisés. Andrew Tate réfute ces accusations. Pourtant, il s’est longtemps vanté publiquement de ses activités sur les réseaux sociaux, d’après cette enquête de NBC News. C’est à lire (en anglais) par ici.

Suivi·es

On a beaucoup parlé du rôle supposé des applications de suivi des règles dans la surveillance des femmes là où l’avortement est interdit ou fortement restreint. Ce danger est loin de se limiter aux services spécialisés. Comme le démontre cet article du site ProPublica, qui a enquêté sur les pratiques douteuses de plusieurs sites de pharmacies en ligne vendant des pilules abortives. Les données de leurs client·es sont souvent vendues à des tiers, généralement à des fins publicitaires. Problème : ces informations peuvent être potentiellement utilisées dans le cadre d’une procédure judiciaire. C’est à lire (en anglais) par là.

Quelque chose à lire/regarder/écouter/jouer

Si l’on en croit la chanson, Internet sert à chercher du porno. La journaliste américaine Samantha Cole propose une version plus élégante de cet adage : « dès qu’il y a eu des choses en ligne, il y a eu du sexe en ligne ». C’est ce que nous promettent les premières lignes de son essai How sex changed the Internet and the Internet changed sex. Il examine, grâce à une approche historique, cinquante ans de liaisons plus ou moins dangereuses entre le web, les nouvelles technologies et nos désirs. Car parler d’Internet et de cul, ce n’est pas que parler de pornographie. C’est revenir sur la naissance et la mort des premières communautés connectées, l’éclosion du business de la publicité en ligne, les premiers pas des algorithmes de recommandation, la restriction progressive de nos libertés sur le web, l’impossible modération de la haine misogyne. C’est parler de morale, de violence, mais aussi d’amour.

Un vaste programme, donc, auquel Samantha Cole s’attaque avec pédagogie et humanité, en faisant intervenir de nombreuses personnes qui ont participé de près ou de loin à cette révolution sexuelle en ligne. Puisque le sexe est partout sur Internet, l’essai souffre d’un léger trop-plein d’informations, et on souhaiterait parfois que l’autrice aille un peu plus en profondeur (ah) plutôt que de survoler ses nombreux sujets. Mais How sex changed the Internet reste une lecture fascinante et importante, à une époque où l’on voudrait nous faire croire qu’Internet serait bien mieux s’il était seulement safe for work.

How sex changed the Internet and the Internet changed sex, de Samantha Cole, Workman Publishing (en anglais)

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !