L’automatisation est-elle l’avenir des intelligences artificielles génératives ? Si aujourd’hui ChatGPT a besoin de consignes humaines pour fonctionner, demain ça ne sera peut-être plus le cas. Preuve en est avec l’émergence, ces dernières semaines, de projets destinés à doter ces outils d’IA d’une certaine autonomie, pour se passer d’une intervention humaine.

À ce titre, des initiatives comme « AutoGPT » du développeur Toran Bruce Richards et « BabyAGI » de son confrère Yohei Nakajima retiennent l’attention, ne serait-ce qu’avec leur nom, déjà.

Le premier est un mot-valise mêlant la notion d’automatisation et l’acronyme GPT (Generative Pre-trained Transformer, pour Transformateur génératif pré-entraîné, en français). Il s’agit du modèle de langage développé par OpenAI, sur lequel repose ChatGPT. Ce modèle en est à sa version 4 (GPT-4) depuis la mi-mars. Et déjà, son successeur (GPT-5) est sur toutes les lèvres.

Quant au second, il fait référence à l’IA générale (Artificial General Intelligence), qui est le Graal de l’IA. Un débat existe sur l’émergence de cette AGI. Certains jugent qu’elle pourrait ne jamais exister. Une AGI rivaliserait avec un humain sur n’importe quelle tâche. BabyAGI en serait donc une sorte d’embryon, mais c’est surtout une dénomination marketing.

Automatisation de l’intelligence artificielle

Selon la description de BabyAGI, ce système sert à créer des tâches fondées sur les résultats des instructions précédentes, selon un objectif prédéfini. Le script se sert ensuite des capacités d’OpenAI en matière de traitement automatique des langues pour fixer ses nouveaux objectifs. Les résultats sont mémorisés pour garder le contexte du travail en cours.

Même chose pour AutoGPT. Fondé sur GPT-4, le programme enchaîne les « pensées » (qui n’en sont pas des vraies) à travers le modèle de langage pour atteindre de manière autonome l’objectif fixé. « Auto-GPT repousse les limites de ce qui est possible avec l’IA », selon Toran Bruce Richards, avec un exemple de GPT-4 qui « fonctionne de manière totalement autonome. »

Grossièrement, l’automatisation fonctionne comme suit :

- Extraction de la première tâche de la liste des instructions à satisfaire ;

- Envoi de la tâche à l’agent d’exécution, qui utilise l’API d’OpenAI pour réaliser la tâche selon le contexte ;

- Intégration et stockage du résultat ;

- Création de nouvelles tâches et redéfinition des priorités de la liste des tâches en fonction de l’objectif et du résultat de la tâche précédente.

Un exemple d’usage ? L’exécution de code. AutoGPT est en mesure d’écrire son propre code informatique en exploitant GPT-4 et d’exécuter des scripts Python, l’un des langages les plus populaires du marché. Selon Toran Bruce Richards, « cela lui permet de déboguer, de développer et de s’améliorer de manière récursive ». Les développeurs ont-ils du souci à se faire ?

Dans le cas de GPT-4 et ChatGPT, il faudrait envoyer des requêtes successives pour faire progresser la production du code. Or c’est justement ce que veulent éviter les projets à la Auto-GPT : limiter les interventions humaines ou, du moins, cantonner les humains à un rôle de supervision. Voilà en tout cas pour la théorie. En pratique, on est à un stade encore expérimental.

Des travaux qui en entrainent une ribambelle d’autres

Pour l’heure, cette automatisation n’est pas très futée. Auto-GPT et BabyAGI ont chacun un mode de fonctionnement continu, qui a pour effet de faire tourner le script à l’infini — sans jamais s’arrêter. Les deux développeurs invitent à s’en servir avec précaution et modération, et à privilégier un mode de validation humaine à chaque étape pour éviter les désagréments.

« L’exécution de ce script en continu peut entraîner une utilisation importante des API, veuillez donc l’utiliser de manière responsable », dit Yohei Nakajima. Même son de cloche chez son confrère : « Il est potentiellement dangereux et peut amener votre IA à fonctionner indéfiniment ou à effectuer des actions que vous n’autoriseriez pas habituellement. »

Au-delà de ces mises en garde figurant dans la documentation, la publication sur GitHub, et avec des licences d’utilisation permissives (licence MIT), d’Auto-GPT et de BabyAGI ouvre la voie à des contributions tierces, pour améliorer l’existant. Surtout, cela autorise l’apparition de projets annexes, dérivés de l’une ou l’autre de ces scripts automatiques d’IA génératives.

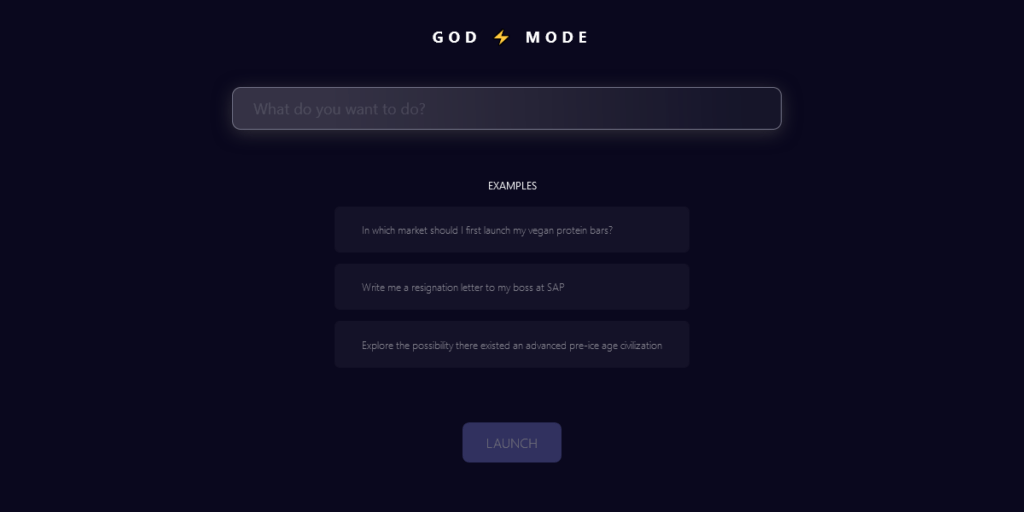

Dans un fil sur Twitter, Yohei Nakajima a listé tous les travaux complémentaires qu’il a vus. Cognosys (un client en ligne de BabyAGI), un projet semblable nommé God Mode, un plug-in pour ChatGPT, une intégration dans Slack, une autre dans le logiciel Discord. Son fil comporte une quinzaine d’autres cas plus ou moins techniques et expérimentaux.

Pour fonctionner, les deux outils recourent à l’API d’OpenAI pour dialoguer avec ChatGPT et les modèles de langage afférents. L’API est option choisie par OpenAI pour GPT-3 et GPT-4 pour ne pas laisser ces solutions dans la nature, entre autres pour des raisons de sécurité. Cet API permet, par exemple, d’utiliser ChatGPT sur l’iPhone avec un seul raccourci iOS.

Le choix de l’open source pour BabyAGI et Auto-GPT offre à celles et ceux qui en sont capables de contrôler le code, de l’améliorer et d’éviter de le privatiser. Cela étant, la démarche reste limitée : cela ne permet pas de voir les entrailles de GPT-3 et GPT-4. Cette opacité dans les modèles d’OpenAI est source de polémique, car elle n’autorise pas des évaluations externes.

Parmi les fonctionnalités qu’Auto-GPT est en mesure de proposer dans ce cadre, on retrouve :

- l’accès au web pour les recherches et la collecte d’informations ;

- la gestion de la mémoire à long terme et à court terme ;

- l’utilisation de GPT-4 pour la génération de texte ;

- l’accès à des sites web et à des plates-formes populaires ;

- le stockage et le résumé de fichiers avec GPT-3.5

Un pas vers l’IA générale ?

Interrogé par The Motherboard, le développeur confiait début avril que « les modèles d’IA existants, bien que puissants, peinent souvent à s’adapter aux tâches qui nécessitent une planification à long terme.» Ils « sont incapables d’affiner de manière autonome leurs approches sur la base d’un retour d’information en temps réels. »

Auto-GPT « peut appliquer le raisonnement de GPT4 à des problèmes plus vastes et plus complexes qui nécessitent une planification à long terme et des étapes multiples ». D’aucuns pourraient croire que c’est une étape intéressante pour que les chatbots comme ChatGPT deviennent un peu plus rusés et ne se contentent pas de recracher ce qu’ils lisent sur Internet.

Ce genre de scripts est en tout cas jugé prometteur. C’est le sentiment donné par Andrej Karpathy, l’ex-boss de l’IA chez Tesla, qui a rejoint OpenAI début février. Dans un fil partagé sur Twitter au début du mois d’avril, il a suggéré que la « prochaine frontière » dans l’ingénierie des prompts (ou consignes) est justement celle des scripts à la Auto-GPT.

« Une requête à GPT équivaut à une instruction sur un PC. Il est possible de les enchaîner pour créer des programmes », note-t-il, avec toutefois une limite : « Une remarque intéressante et non évidente sur la psychologie des GPT est que, contrairement aux personnes, elles ne sont absolument pas conscientes de leurs propres forces et limites. »

Ainsi, elles ont une « fenêtre contextuelle limitée », relève-t-il. Elles peuvent à peine faire du calcul mental. Ou bien leur échantillon peut être bancal et faire dérailler les réponses. Mais, « en les enchaînant en boucle, on crée des agents capables de percevoir, de penser et d’agir », selon les objectifs du prompt. « Une requête GPT, c’est un peu comme une pensée », glisse-t-il.

Un pas vers l’AIG, alors ?

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !