C’est une nouvelle tendance qui a émergé depuis quelques semaines : pour que les projets en intelligence artificielle gagnent en autonomie, des scripts émergent pour enchaîner les tâches, sans avoir à passer systématiquement par une validation d’un humain. C’est le cas d’un projet comme Auto-GPT. Voilà ce qu’il faut retenir de son fonctionnement.

C’est quoi, Auto-GPT ?

Auto-GPT est le nom donné à un projet informatique qui exploite les systèmes en intelligence artificielle développés par l’entreprise américaine OpenAI. Plus précisément, c’est un projet open source (les fichiers et les instructions figurent dans un dépôt GitHub) et expérimental, développé essentiellement par une seule personne : Toran Bruce Richards.

Auto-GPT se base particulièrement sur deux produits d’OpenAI : les modèles de langage GPT-3 et GPT-4, utilisés dans le célèbre chatbot ChatGPT. Il s’agit de modèles statistiques qui déterminent l’agencement et la distribution des mots, en s’appuyant sur de gigantesques données préalablement ingérées lors de leur entraînement.

Ces modèles utilisent les maths pour savoir ce qu’il convient de répondre selon ce qu’il leur est demandé. Grossièrement, ces modèles doivent plutôt répondre « pommes » à la question « que trouve-t-on dans un pommier », au lieu de dire « cotons-tiges » ou « dragons fluorescents », car les données d’entraînement ont en principe écrasé cette probabilité.

Dans Auto-GPT, GPT-3.5 et GPT-4 servent chacun à une tâche précise : GPT-3.5 sert à stocker et à résumer des fichiers, tandis que GPT-4 est employé pour produire du texte et du code informatique. GPT-4 est aujourd’hui la version plus avancée des modèles d’OpenAI. Elle a été dévoilée mi-mars. Auto-GPT est capable de chercher et de collecter des informations sur le net.

Quel est le but d’Auto-GPT ?

Le but d’Auto-GPT est de porter plus loin les capacités des modèles d’OpenAI en leur donnant une dose d’autonomie. Aujourd’hui, ChatGPT ne peut que traiter une tâche après l’autre : vous lui demandez quelque chose, il répond et ça s’arrête là. Vous pouvez poursuivre l’échange, et ChatGPT se souviendra de ce qui a été dit, mais l’outil cessera encore après sa réponse.

C’est pour cela que le projet s’appelle Auto-GPT, car il s’agit d’automatiser les modèles de langage de type GPT (generative pre-trained transformer, en anglais). L’idée est d’arriver à enchaîner les actions avec GPT-3 et GPT-4, sans qu’un usager n’ait à intervenir à chaque étape. Voilà pour la théorie. Dans la pratique, le projet est encore balbutiant et la supervision humaine n’est jamais loin.

La théorie est néanmoins prometteuse. Le développeur a indiqué à Vice, début avril 2023, qu’Auto-GPT génère une liste de tâches fondée sur les objectifs assignés par l’utilisateur. Il peut également ajouter d’autres étapes si cela lui permet d’atteindre les buts fixés, et ensuite Auto-GPT exécute chaque tâche. Éventuellement, en allant sur le net pour chercher des informations additionnelles.

Parmi les espoirs fondés par des outils d’automatisation figure la faculté qu’ils soient capables, par eux-mêmes, d’avoir un regard critique sur ce qu’ils produisent. Il pourrait y avoir l’aptitude de corriger des résultats passés, en créant une tâche qui consiste à les vérifier, ou bien la compétence de réorienter ou changer la priorité des tâches à la volée, selon les résultats fournis.

Comment fonctionne Auto-GPT ?

Auto-GPT est un projet écrit avec le langage de programmation Python, l’un des plus employés au monde. Un accès doit être obtenu auprès d’OpenAI pour accéder à GPT-3 et 4. C’est l’API — acronyme pour interface de programmation d’application. C’est la seule porte d’accès, car OpenAI ne diffuse pas librement ses modèles de langage.

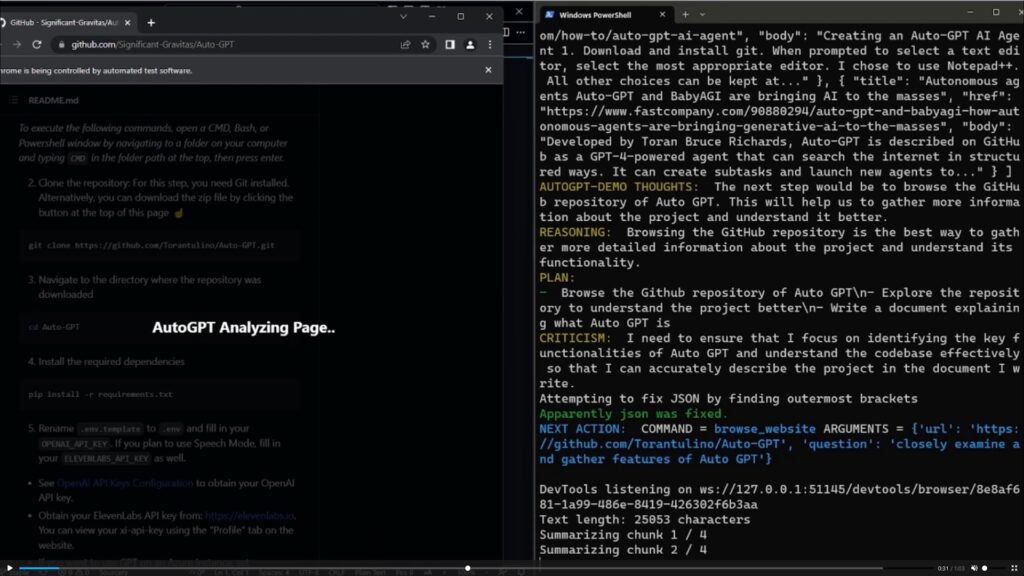

Dans une vidéo de démonstration, on voit que les tâches suivantes ont été données à Auto-GPT : cherche Auto-GPT ; trouve la page GitHub et détermine ce qu’est le projet ; explique ce qu’est Auto-GPT dans un fichier appelé autogpt.txt ; termine. On voit ensuite le script dérouler les étapes de « réflexion », ce qui donne une idée de la manière dont il procède.

Ainsi, le script affiche la « pensée » selon laquelle la première étape devrait être d’utiliser la commande « Google » pour chercher ce qu’est Auto-GPT. La raison donnée par l’IA ? Cela l’aidera à collecter plus d’informations sur Auto-GPT pour identifier ensuite le bon projet GitHub. Auto-GPT dresse alors un plan d’action en trois étapes :

- Utiliser Google pour chercher Auto-GPT ;

- Naviguer sur des sites web adéquats pour trouver le projet GitHub ;

- Écrire un document expliquant ce qu’est Auto-GPT ;

Le script affiche alors une première « pensée » de l’IA. « Je dois m’assurer de rester concentré et efficace dans mon utilisation de la commande Google afin de minimiser le nombre d’étapes nécessaires pour identifier le projet GitHub pertinent et répondre aux questions clés », lit-on. Ensuite, le système mouline et l’on aperçoit les liens et les résultats qu’Auto-GPT obtient sur Google.

Ensuite, Auto-GPT raisonne sur la suite (« l’étape d’après devrait être de naviguer dans le dépôt GitHub dédié à Auto-GPT. Cela aidera à obtenir plus d’informations sur le projet et comprendre ses fonctionnalités »). Là encore, le script affiche un « raisonnement », avant d’afficher un plan et une « pensée » critique sur le travail qui va être effectué (là encore, rester focalisé).

On assiste ensuite à l’analyse de la page, à la synthèse de son contenu et à la création d’un fichier texte dans lequel se trouvera le résumé proposé par Auto-GPT. Le script suit alors le même schéma : qu’est-ce qu’on me demande de faire ; comment vais-je le faire ; quel est mon plan ; à quoi dois-je faire attention. Tout cela, évidemment, traduit en instruction informatique.

Quelles sont les fonctionnalités d’Auto-GPT ?

Auto-GPT est capable de :

- D’accéder à Internet pour les recherches et la collecte d’informations ;

- Lancer des instances GPT-4 pour la génération de textes ;

- Gérer de la mémoire à long terme et à court terme ;

- Accéder aux sites web et plateformes populaires ;

- Stocker et résumer des fichiers avec GPT-3.5 ;

- Accueillir des plugins spécialisés.

Comment utiliser Auto-GPT ?

Auto-GPT doit être utilisée dans sa dernière version (actuellement v0.0.2), en la téléchargeant sur son ordinateur. Notez que l’utilisation d’Auto-GPT nécessite un bagage minimal en informatique. Il n’est pas encore possible de l’utiliser « comme ça ». Vous devrez notamment avoir un environnement logiciel pour pouvoir exécuter Auto-GPT, comme Docker, Python 3.10 ou VSCode.

Des instructions d’installation et de prise en main sont fournies sur la page GitHub et sur une page dédiée. Si la modification de fichiers informatiques (notamment pour y ajouter la clé d’accès d’API pour OpenAI) ne vous effraie pas, c’est pour vous. Idem si vous êtes familier avec des commandes comme « docker-compose run –rm auto-gpt ». Notez que les instructions sont en anglais.

Des détails pour la configuration concernant la recherche en ligne, la gestion de la mémoire, la génération d’image et la possibilité de transformer un texte écrit en un texte parlé (text to speech) sont donnés. Il est également recommandé de ne pas se servir d’auto-GPT en mode « continu » et d’exécuter Auto-GPT dans une machine virtuelle, par mesure de sécurité — et éviter un souci avec son PC.

Quant aux plugins, même avertissement : c’est de votre responsabilité, car ils n’ont pas été développés par l’auteur d’Auto-GPT. « Examinez attentivement le code de tout plugin que vous utilisez, car les plugins peuvent exécuter n’importe quel code Python, ce qui peut conduire à des activités malveillantes, telles que le vol de vos clés API », met en garde le développeur.

Quelles sont les prochaines étapes pour Auto-GPT ?

Sur la feuille de route partagée dans le GitHub d’Auto-GPT, les prochaines étapes incluent des évolutions concernant le développement du projet.

Il y a Auto-GPT V1 Async Agent pour « améliorer l’évolutivité et la maintenabilité de la base de code » avec l’ajout d’un agent asynchrone et une restructuration du code pour permettre un développement plus modulaire. C’est le projet d’après : V2 Async Modular Architecture. À plus long terme, plusieurs autres développements sont au programme, sans calendrier précis :

- Capacités de vision par ordinateur ;

- Intégrer de la « réflexion » (en s’inspirant de travaux de recherche autour d’un agent autonome doté d’une mémoire dynamique et d’une capacité d’auto-réflexion) ;

- Mode semi-actif ;

- Auto-amélioration récursive Auto-GPT

- Prise en charge d’autres grands modèles de langage (ou locaux) ;

- Granularité dans les autorisations de commande ;

- Prise en charge du langage de requêtes LMQL destiné aux modèles de langage.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !