Lancé en mai 2023, le modèle de langage GPT-4 est-il devenu moins pertinent ? Sur les réseaux sociaux, de nombreux utilisateurs de la version payante de ChatGPT disent constater une baisse de la qualité des réponses depuis plusieurs semaines. Le texte serait produit plus rapidement par l’IA, mais avec des incohérences plus récurrentes. Certains reprochent notamment à GPT-4 de réaliser des erreurs régulières lorsqu’il génère du code, ce qu’il ne faisait pas avant.

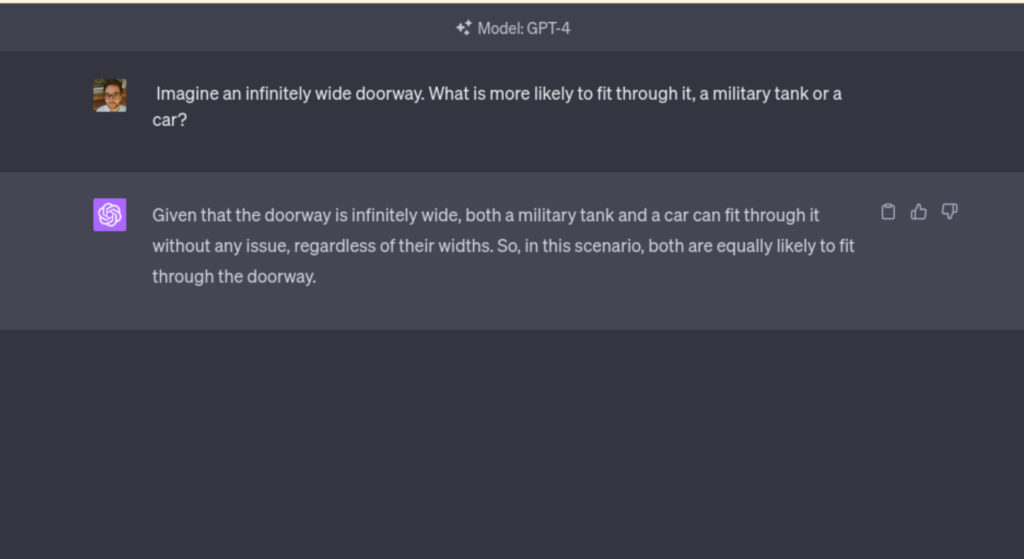

Tout a commencé sur Twitter le 20 mai dernier. « GPT-4 vient-il d’être lobotomisé ? » s’interroge Laura Wendel, qui se présente sur son profil comme ingénieure logicielle. ChatGPT « répond aux requêtes beaucoup plus rapidement, mais ses performances semblent bien moins bonnes qu’il y a quelques semaines (il ne suit pas correctement les instructions, fait des erreurs de codage très évidentes, etc.) », affirme-t-elle. Une expérience personnelle rapidement confirmée par une centaine de témoignages dans le même sens, même s’il faut toujours se méfier de l’effet placebo.

Une version (a priori) stable

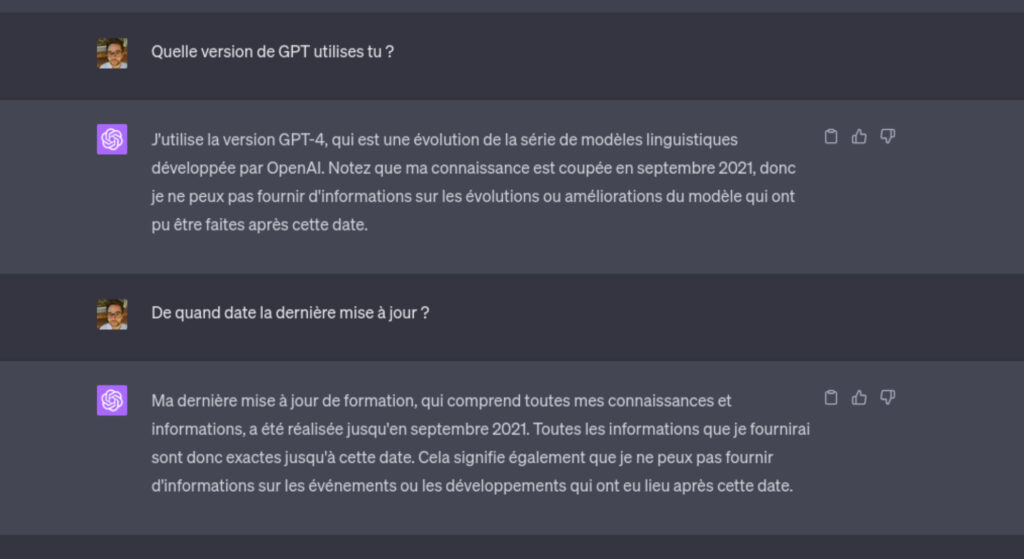

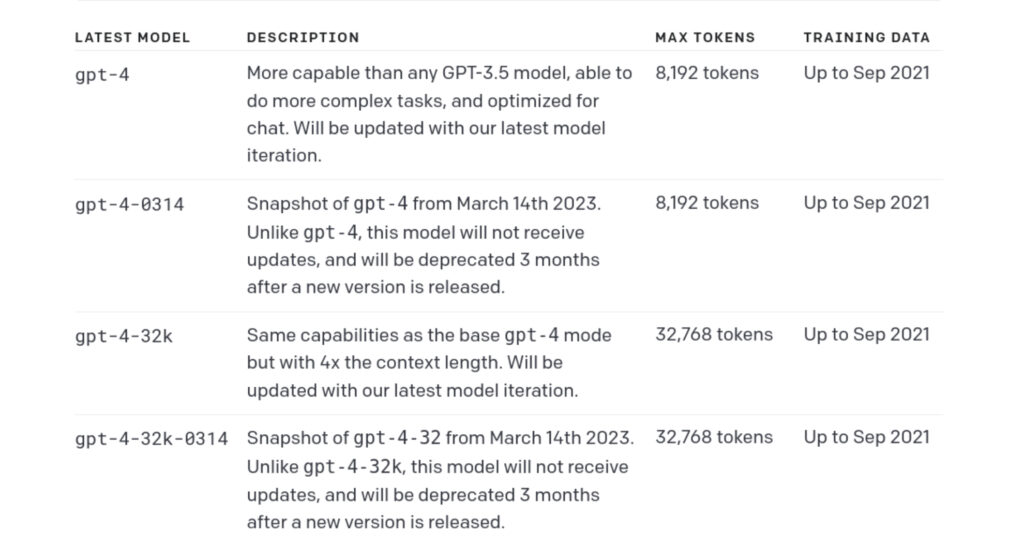

Quand on est abonné à ChatGPT Plus, on a la possibilité de choisir entre plusieurs agents conversationnels. Il y a la version GPT-3.5, qui utilise le modèle « gpt-3.5-turbo » conçu pour répondre rapidement, puis la version GPT-4, qui utilise le dernier modèle de langage d’OpenAI. La mise à jour date du 12 mai a aussi apporté des modes optionnels, pour effectuer des recherches sur le web ou utiliser des plugins.

Pour beaucoup, GPT-4, impressionnant à son lancement, est devenu plus bête ces dernières semaines, à tel point que GPT-3.5 le dépasse sur certaines questions.

Selon nos propres tests basés sur des prompts de logique du New York Times, l’efficacité des réponses produites le 22 mai ne diffère pas de celle obtenue par nos confrères en mars, lors du lancement de GPT-4. Seule différence notable, l’IA semble moins enclin à répondre à certaines requêtes très techniques, comme l’autocompression des conversations. La modération semble, elle aussi, beaucoup plus efficace et complexe à contourner, ce qui veut dire qu’OpenAI est intervenu pour empêcher son IA de répondre à certaines questions problématiques.

Comment expliquer ces (potentiels) changements ?

Pour perfectionner ses modèles et réduire le risque juridique, OpenAI est contraint de brider artificiellement les capacités de son IA. C’est le scénario qui apparaît le plus crédible pour expliquer les changements récents, même si ces derniers doivent encore être prouvés (il n’est pas rare que les réseaux sociaux s’emballent, alors qu’il n’y a pas eu de changement majeur). Les développeurs de l’entreprise pourraient également avoir procédé à diverses opérations d’apprentissage par renforcement à partir du feedback humain (RLHF) pendant la phase de production (avec un modèle actuellement utilisé par le public). Cette procédure permet d’ajuster les réponses du système assez précisément. Elle peut néanmoins contribuer, dans certains cas, à réduire la performance de l’IA sur certains sujets.

Enfin, scénario peu probable, mais évoqué par certains : l’utilisation d’un modèle alternatif pour réduire les coûts. L’exploitation d’un modèle aussi grand que GPT-4 demandant des ressources considérables, l’entreprise aurait pu être tentée d’utiliser une version moins gourmande en performance. Un tel tour d’illusionnisme aurait cependant été décelé bien avant par les experts du secteur, ce qui laisse supposer qu’il vaut mieux ne pas tomber trop vite dans les raccourcis.

Des modèles « non déterministes »

Enfin, OpenAI rappelle dans sa documentation que les modèles de l’entreprise sont « non déterministes, ce qui signifie que des entrées identiques peuvent produire des sorties différentes. » En clair, la probabilité d’obtenir la même réponse à une question posée plusieurs fois est quasiment nulle. Le déterminisme et la créativité des réponses sont gérés dans le système par la « température », une variable intrinsèque à l’API d’OpenAI. Les changements récents pourraient résulter d’une modification de ce paramètre au sein de l’interface web de ChatGPT.

Des scientifiques de l’unité IA de Microsoft ont toutefois observé une régression majeure des progrès de GPT-4 sur un an. La première version (non publique) utilisée par les chercheurs était plus avancée que celle présentée en mars par OpenAI. Un bridage artificiel expliqué dans ce cas par le rodage pour le « grand public » de l’IA avant sa sortie officielle.

Sollicité sur les récentes remarques des utilisateurs sur GPT-4, OpenAI n’a pas encore répondu.

Numerama a le plaisir d’introduire sa toute dernière newsletter gratuite, « Artificielles », qui vous tient au courant des nouveautés récentes dans le domaine de l’intelligence artificielle. Elle est soigneusement rédigée par ChatGPT et scrupuleusement vérifiée par notre équipe dévouée. Pour souscrire, il suffit de compléter le formulaire ci-dessous :

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !