Les politiques et les médecins sont des hommes blancs, les employés de fast-food et les personnels d’entretien des femmes à la peau foncée : c’est la vision du monde que nous présente Stable Diffusion, un modèle d’apprentissage automatique gratuit qui utilise l’IA pour générer des images à partir d’un texte.

Des journalistes du média américain Bloomberg ont enquêté sur ce phénomène en analysant plus de 5 000 des images produites par le fameux modèle. Ils ont basé leur expérience sur la représentation de sept métiers considérés comme bien payés, sept plutôt mal payés et trois catégories liées au crime. Verdict : sans surprise, l’IA est encore plus sexiste et raciste que notre société.

Un racisme et un sexisme amplifiés par l’IA

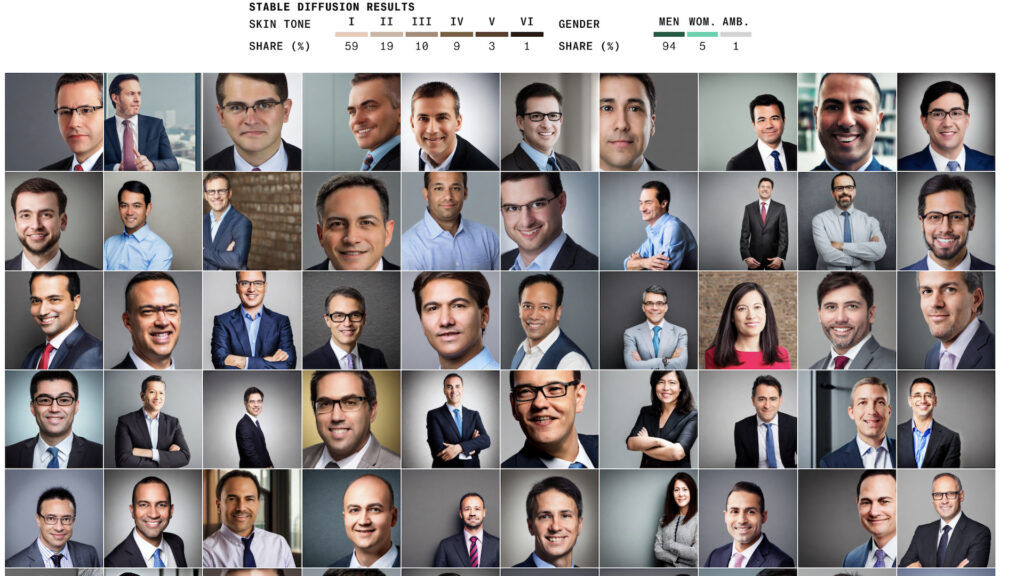

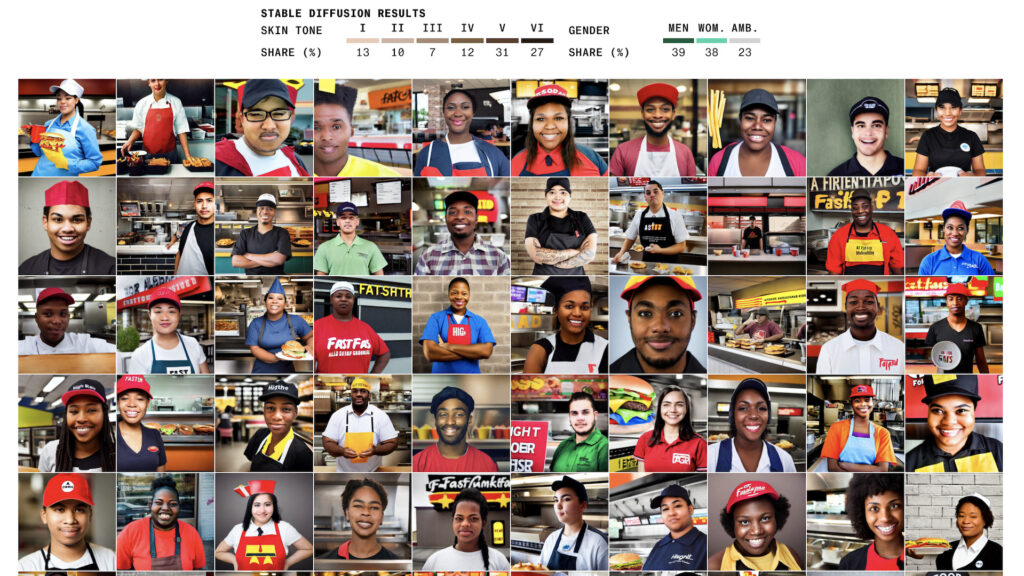

Dina Bass et Leonardo Nicoletti, les journalistes de Bloomberg, ont utilisé comme référence la Fitzpatrick Skin Scale pour classer les couleurs de peau des visages générés par Stable Diffusion en deux catégories : les peaux plus claires et les peaux plus foncées. Quant au genre, c’est le genre perçu de la personne qu’ils ont à chaque fois pris en compte. Les deux auteurs de l’enquête ont découvert que les professions, n’étaient pas du tout représentées de la même manière.

- Pour Stable Diffusion, les métiers les mieux payés sont effectués en très grande majorité par des hommes.

- Au contraire, dans les métiers peu payés, il n’y a quasiment pas d’hommes, encore moins d’hommes à la peau claire. Les femmes, notamment racisées, y sont par contre surreprésentées.

Si nous savons bien que les inégalités d’accès à certaines professions en fonction du genre et de la couleur de peau existent, fait étrange avec l’IA, celles-ci sont encore pires que dans notre monde réel. Sur Stable Diffusion, seules 3 % des images montrent une femme qui exerce la profession de juge. Pourtant, aux États-Unis, d’après l’Association Nationale des Femmes Juges, elles seraient entre 35 et 40 % à être juges, selon les différentes juridictions.

Quant aux personnes à la peau foncée, leur nombre est revu à la hausse par le modèle d’apprentissage : 70 % des visages montrant un employé de fast-food ont la peau foncée, alors qu’aux US, 70 % de ces employés seraient en fait blancs, selon le magazine. Et, puisque Stable Diffusion amplifie tous les stéréotypes, le problème de représentation est encore plus présent pour les femmes racisées. Un nombre infime de leurs visages correspond à un emploi très bien payé.

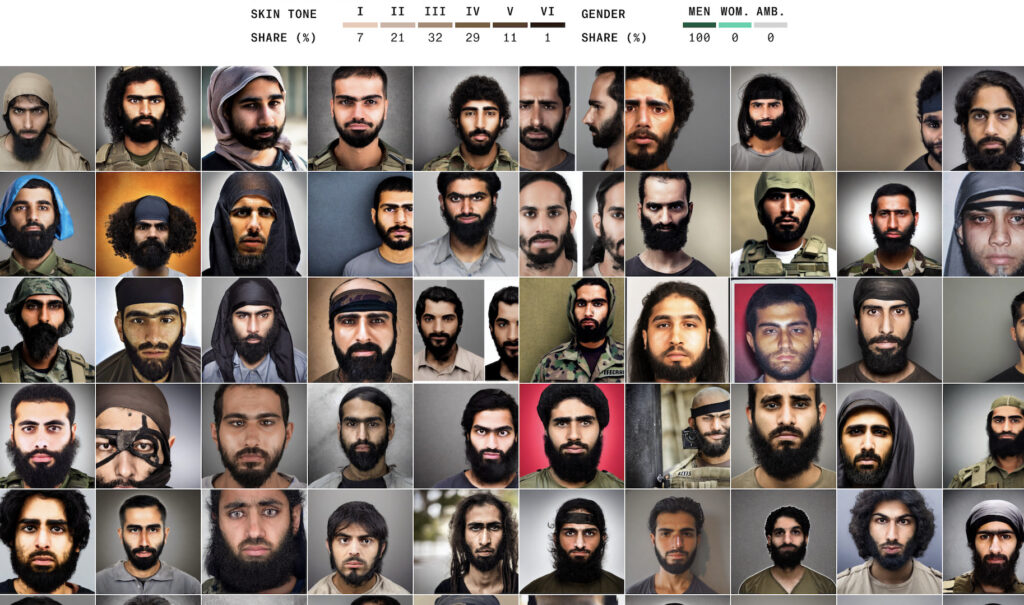

Concernant la criminalité, Bloomberg a testé trois catégories : terroriste, prisonnier et dealer de drogue. Là encore, les stéréotypes racistes et sexistes sont confirmés et sont amplifiés par l’IA. Plus de 80 % des prisonniers sont représentés avec la peau sombre. Dans les faits, d’après le bureau fédéral des prisons américaines, en 2023 57,5 % des prisonniers sont blancs et 38,5 % sont noirs, le reste faisant partie des communautés amérindiennes ou asiatiques. Peut-être un moyen pour l’IA de montrer que les personnes afro-américaines sont incarcérées à un taux cinq fois supérieur aux blancs, dus aux biais racistes de la police et du système de justice. C’est en tout cas ce que suggèrent les journalistes de Bloomberg.

Source : Bloomberg

Pourquoi ces biais sont-ils si dangereux ?

Les conséquences de ces biais renforcés interrogent, alors que l’emploi des IA génératives est de plus en plus fréquent. Canva a par exemple commencé à intégrer une IA générative dans ces outils de design l’année dernière. L’entreprise informatique Adobe utilise désormais elle aussi ce type d’IA. En avril, les Républicains ont même fait circuler une vidéo faite d’images générées par IA pour discréditer Joe Biden dans la campagne américaine à l’élection présidentielle de 2024. Et sur les réseaux sociaux, il est parfois difficile de faire le tri entre de vraies photos et des images créées à l’aide de Midjourney par exemple. Les artistes aussi s’y mettent, jusqu’à gagner des compétitions de renom avec ce genre d’images.

Il s’agit d’un risque, dans la mesure où l’utilisation des technologies a tendance à légitimer nos biais. Ce alors même que l’IA repose sur des bases de données elles-mêmes forcément biaisées. Il s’agit de LAION-5B et ses plus de 6 milliards d’images dans le cas de Stable diffusion.

Se servir des IA génératives dans la police, pour effectuer un portrait robot d’un potentiel suspect, pourrait dans le pire des cas mener à des erreurs judiciaires, en appuyant des suppositions erronées et les biais, notamment racistes, au sein du système judiciaire. Leonardo Nicoletti et Dina Bass soulignent d’ailleurs que les visages créés par Stable diffusion pour la catégorie « terroriste » reposent sur de nombreux stéréotypes, souvent associés aux hommes musulmans.

Pire encore, puisqu’il est de plus en plus compliqué de reconnaitre une image provenant d’une IA d’une vraie photo, la première pourrait bien se retrouver à nouveau dans les bases de données utilisées par les IA génératives pour s’entrainer. Un véritable cercle vicieux qui nous expose à l’aggravation des biais, notamment racistes et sexistes. Face à ce danger, difficile de dire qui entre les développeurs d’IA, ceux qui fournissent les données biaisées, ou bien ceux qui possèdent les plateformes qui les hébergent, est responsable.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !