Les assistants personnels utilisant une voix féminine pour répondre aux demandes des usagers doivent-ils les remettre à leur place lorsqu’ils franchissent la ligne rouge ? C’est la position que privilégie Microsoft avec Cortana : en effet, son application pour mobile peut produire des réponses exprimant le mécontentement du logiciel si les questions s’avèrent déplacées.

C’est ce qu’a révélé Deborah Harrison, une éditorialiste travaillant dans la division Cortana de Microsoft, à CNN.

Elle explique qu’au moment du lancement de l’assistant personnel en 2014, « une bonne partie des requêtes initiales concernait sa vie sexuelle ». Un constat qui a visiblement déstabilisé l’équipe en charge de concocter les réponses de Cortana. Au début, en tout cas. Car désormais, Cortana ne se laisse plus faire. « Si vous lui parlez comme le dernier des con***ds, elle s’énervera ».

Si vous lui parlez comme le dernier des con***ds, elle s’énervera »

Car pour Microsoft, les choses sont claires : il n’est pas question que Cortana puisse servir à reproduire certainement comportement sociaux qui ne devraient avoir cours au 21ème siècle. « Nous voulions être très prudents sur le fait qu’elle ne paraisse pas subordonnée d’une quelconque façon… ou d’éviter de mettre en place une dynamique que nous ne voulons pas perpétuer socialement ».

Autrement dit, que les hommes utilisant Cortana se sentent autorisés à la considérer comme un paillasson parce que le logiciel utilise une voix féminine. « Ce n’est pas le genre d’interaction que nous voulons encourager », ajoute Deborah Harrison.

Par défaut, c’est une voix d’homme en français et de femme en anglais. Mais l’option peut être changée.

La politique suivie par Microsoft sur ce terrain est visiblement assez novatrice, puisque l’on ne retrouve pas vraiment cette approche dans d’autres assistants personnels utilisant une voix féminine. Dans le cas de Siri par exemple, les réponses données par le logiciel à nos questions n’ont pas révélé clairement une volonté de nous remettre à notre place parce que nous étions grossiers ou trop curieux.

En organisant Cortana de façon à réagir lorsque les usagers se laissent aller au sexisme, Microsoft intègre de fait dans son logiciel une dimension politique et morale pour contrer toute attitude discriminatoire en raison du sexe. Or, est-ce le rôle d’un programme d’interpréter non seulement ce que dit un utilisateur, mais aussi d’indiquer si ce qu’il dit est bien ou mauvais ?

Ce faisant, et peut-être inconsciemment, Microsoft repose la question du droit des robots, ou du droit de l’IA. La question s’est en effet posée de savoir s’il fallait accorder aux robots les mêmes droits qu’aux animaux, qu’il est interdit de maltraiter, non pas seulement parce qu’il s’agit d’êtres vivants, mais aussi (selon une vision partagée par Saint Thomas d’Aquin, Locke ou Kant) parce qu’il faut encourager l’homme à se respecter lui-même, et à donc à ne pas céder à ses pulsions

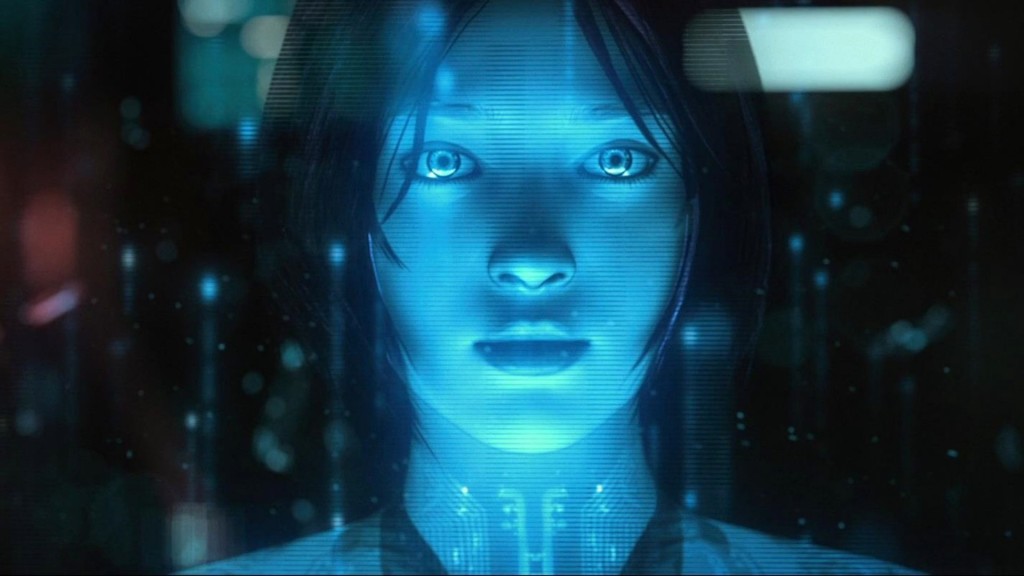

Cortana, une appli inspirée d’une personnage féminin de jeu vidéo

Cortana est bien entendu le reflet de l’entreprise qui la conçoit. En l’occurrence Microsoft, une société occidentale et plus spécifiquement américaine. Or, les valeurs du groupe ne sont pas le reflet de toutes les valeurs du monde. Il y a ce qui peut choquer en Occident et ce qui ne heurte pas dans d’autres régions du monde (il faut souhaiter que le sexisme n’en fasse pas partie). Et surtout, inversement, il y a ce qui paraît normal ou tolérable sous nos latitudes, qui devient au moins aussi répréhensible que le sexisme sous d’autres cultures. Que faut-il faire de ces sensibilités là ?

Car au-delà du sexisme, qui est absolument et universellement condamnable, c’est la question de l’universalisation de la morale qui se pose. Selon quels standards faut-il qu’une IA réagisse ? Qui la définit ? Où commence l’immoralité et où finit-elle ?

Avec cette approche, Microsoft a peut-être mis le doigt dans un engrenage qui pourrait lui donner du fil à retordre à l’avenir. Et si la lutte contre certains phénomènes (sexisme d’abord, racisme ensuite ?) à travers Cortana semble tout à fait légitimes, au regard du progrès évident que cela peut apporter à une société, d’autres sujets peuvent faire figurer des positions plus contrastées.

Une idée à laquelle on ne peut qu’adhérer mais qui soulève certaines interrogations.

Faudrait-il, par exemple, que Cortana prenne en ligne de compte les considérations des principales religions, en réagissant par exemple lorsque l’utilisateur insulte une figure sainte ou effectue une recherche particulière (les images du prophète Mahomet) ? Ou rejette les requêtes pornographiques lorsqu’elles reflètent une vision avilissante de la femme.

Peut-être qu’à ces questions, la réponse de Microsoft sera de créer à terme des versions localisées de Cortana qui prendront chacune en compte le système de valeurs du marché dans lequel elles évolueront. Mais cela risque fort de soulever d’autres problématiques, car les points de vue sur la morale ne sont pas uniformes, même au sein d’une société donnée.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !