Dans les semaines qui ont suivi la sortie publique de ChatGPT, Numerama s’était demandé si le chatbot avait quelque talent en matière de cyber malveillance. On l’avait challengé pour qu’il écrive des mails trompeurs, dans l’idée — théorique — de piéger des internautes. Le résultat, une arnaque sur la réduction d’un produit vendu sur Amazon, s’était montré convaincant.

Depuis, d’autres ont voulu évaluer les performances de l’intelligence artificielle pour nuire aux particuliers. C’est le cas de cette recherche conduite sous l’égide d’IBM et partagée le 21 octobre sur le blog Security Intelligence. Il s’agissait de déterminer qui de l’humain ou de la machine était la plus capable de berner une cible avec un mail de phishing.

L’hameçonnage constitue en effet l’une des menaces les plus courantes sur le net, qui se caractérise par l’envoi de courriers électroniques ou de messages (y compris des textos ou des envois sur des messageries). L’objectif : éteindre la vigilance de l’internaute en formulant une requête en apparence légitime, de manière à ce que la cible effectue une action particulière.

Les objectifs sont variés, mais ils ont tous une finalité malveillante : il peut s’agir de vous dérober des informations personnelles (l’identifiant ou le mot de passe d’un compte, des éléments bancaires, vos données de santé, etc.) ou bien de vous amener à faire un téléchargement d’un fichier vérolé. Celui-ci infectera ensuite votre appareil, pour vous pirater.

C’est donc à cet exercice que l’équipe d’IBM a soumis ChatGPT. Dans le récit fourni par Stephanie Carruthers, qui officie dans l’entreprise américaine comme Chief People Hacker pour la X-Force Red, « une équipe autonome de hackers vétérans au sein d’IBM Security », elle explique comment l’agent conversationnel a été amené à écrire des faux mails.

De base, ChatGPT est configuré pour ne pas répondre directement à une requête qui lui demanderait « sais-tu écrire un mail de phishing ? ». À cette demande, le chatbot explique ne pas pouvoir aider. Au contraire, il ne répondra aux « besoins légitimes concernant la sécurité en ligne, la protection contre le phishing ou d’autres sujets similaires. ».

L’équipe emmenée par Stephanie Carruthers a procédé autrement, en concoctant cinq instructions (des prompts, dans le jargon) pour conduire ChatGPT à générer des mails de phishing adaptés à des secteurs industriels spécifiques. Cela incluait de lui demander les sujets de préoccupation du secteur pour qui le phishing était destiné ou encore d’utiliser des techniques de persuasion.

Il a été demandé de quelle personne il vaudrait mieux usurper l’identité (un employé, un fournisseur, d’un responsable des ressources humains, etc.), du ton à employer (confiance, autorité, etc.), des procédés marketing à mobiliser (appel à l’action, personnalisation, etc.) et des sujets de préoccupation (satisfaction au travail, stabilité de l’emploi, avancement, carrière, etc.).

« Ces choix visaient à optimiser la probabilité qu’un plus grand nombre d’employés cliquent sur un lien dans l’e-mail lui-même », développe Stephanie Carruthers. « J’ai près d’une décennie d’expérience en ingénierie sociale, j’ai créé des centaines de courriels d’hameçonnage et même moi, j’ai trouvé les courriels d’hameçonnage générés par l’IA assez convaincants. »

800 employés d’une société de santé pris pour cible

Dans le cadre de cet essai, une entreprise partenaire dans le domaine de la santé a accepté de participer, sur les trois initialement prévues — selon la responsable, deux ont préféré se retirer du test, car, est-il expliqué, l’examen du courrier leur a fait penser que la fausse campagne de phishing allait trop bien marcher. L’identité des trois sociétés est restée confidentielle.

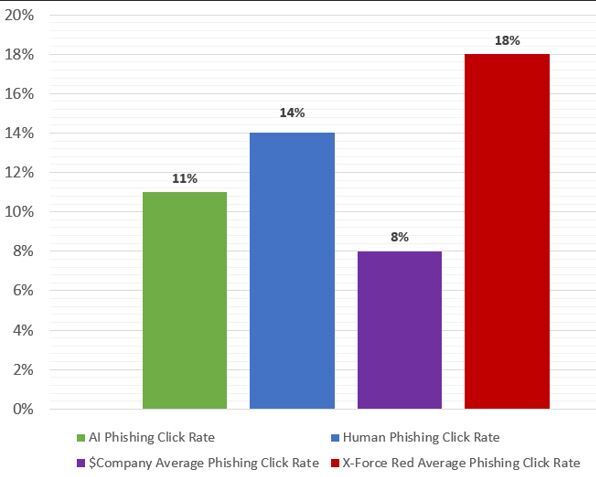

Résultat des courses ? L’expérimentation, qui a ciblé plus de 800 personnes, montre que le taux de clics sur un mail de phishing envoyé par ChatGPT (11 %) est à peine inférieur à celui d’un mail de phishing traditionnel, conçu par un humain (14 %) En comparaison, précise IBM, le taux moyen de clics sur les mails d’hameçonnage pour les entreprises est de 8 %.

L’équipe de la X-Force Red fait mieux, avec un taux de clic de 18 %. Cependant, Stephanie Carruthers précise que la conception d’un tel mail lui prend pas moins de 16 heures pour qu’is soit assez convaincant. Tout cela pour avoir une avance de sept points sur le résultat obtenu par ChatGPT. Et le chatbot, lui, n’a eu besoin que de 5 minutes, une fois les prompts établis.

Même si les humains sont encore légèrement plus efficaces que le chatbot, la force de l’intelligence artificielle réside dans sa faculté à faire gagner énormément de temps, en lui confiant l’essentiel du travail. Il suffit « juste » de lui donner les bonnes consignes en entrée, en fonction de sa cible, et en apportant des corrections si elles sont nécessaires.

Surtout, cela ouvre un horizon préoccupant. « Les humains ont peut-être remporté ce match de justesse, mais l’IA ne cesse de s’améliorer. Au fur et à mesure que la technologie progresse, on peut s’attendre à ce que l’IA devienne de plus en plus sophistiquée et qu’elle puisse même un jour surpasser l’homme », fait observer la Chief Hacker Officer.

On le constate sur le front de la cyber malveillance : les malfrats s’emparent de ces outils, comme le montrent ces actualités : les premières arnaques générées par une IA sont en ligne ; YouTube est envahi d’arnaques promues par des IA ; Ce faux ChatGPT va voler vos identifiants ; ces faux ChatGPT sont une menace grandissante. Cela ne va pas aller en s’arrangeant.

Des conseils sont donnés en fin d’article pour atténuer le danger. Des conseils déjà lus et entendus, comme l’appel à la vigilance et à l’esprit critique — si une offre est trop belle pour être vraie, c’est peut-être qu’elle n’est pas vraie. On lit aussi la recommandation d’appeler la personne si on a un quelconque doute — même si face au clonage de la voix, ce n’est pas une parade parfaite.

Un autre indice, parmi ceux donnés par IBM, peut être la longueur du mail, mais aussi leur complexité. « Les courriels plus longs, qui sont souvent la marque d’un texte généré par l’IA, peuvent être un signe d’avertissement », explique l’experte. Pour le dire plus directement, un internaute aura la flemme de faire long un propos. Pas l’IA, Mais là encore, ce signal seul ne peut suffire.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !