Mi-janvier 2023, les premières plaintes tombent contre les systèmes d’IA génératrices d’images, seulement quelques mois après leur diffusion. Trois artistes, Sarah Andersen, Kelly McKernan et Karla Ortiz, portent plainte contre Midjourney, Stability AI et DeviantArt, pour avoir « enfreint le droit d’auteur de millions d’artistes, sans leur consentement. » Ces entreprises sont à l’origine de générateurs d’images (Stable Diffusion, Midjourney, DreamUp) qui auraient été entraînés en récupérant du contenu sous copyright sur internet sans permission et sans rétribution pour les artistes. Le lendemain, c’est au tour de l’agence de photos Getty Images de s’élever contre Stable Diffusion pour les mêmes raisons.

Les systèmes génératifs d’images ont besoin de grandes quantités de contenus visuels pour être entraînés et à leur tour pouvoir produire des images. Face à leurs griffes, de quels moyens dispose-t-on pour protéger nos contenus en ligne ? L’heure de la revanche a peut-être sonné. Dans une étude mise en ligne en octobre 2023, encore non relue par les pairs, des chercheurs de l’Université de Chicago proposent un outil pour les empoisonner.

Une baie empoisonnée

Cet algorithme, les chercheurs l’ont baptisé Nightshade, qu’on peut traduire par belladone en français, c’est-à-dire une plante à baies noires toxique. L’outil porte bien son nom : si un modèle génératif d’images se nourrit de ces baies noires attrayantes d’internet, il sera rendu malade et verra la qualité de ses sorties diminuées. Par exemple, pour lui un chien ressemblera à un chat.

Tout repose sur un constat simple : « Les humains et les machines voient les images de façon différente », explique Shawn Shan, co-auteur de l’étude. Ainsi, il est possible d’apporter à une image de subtiles modifications des pixels (changement de couleur, échange), imperceptibles pour l’humain, mais qui sont une véritable source de confusion pour la machine.

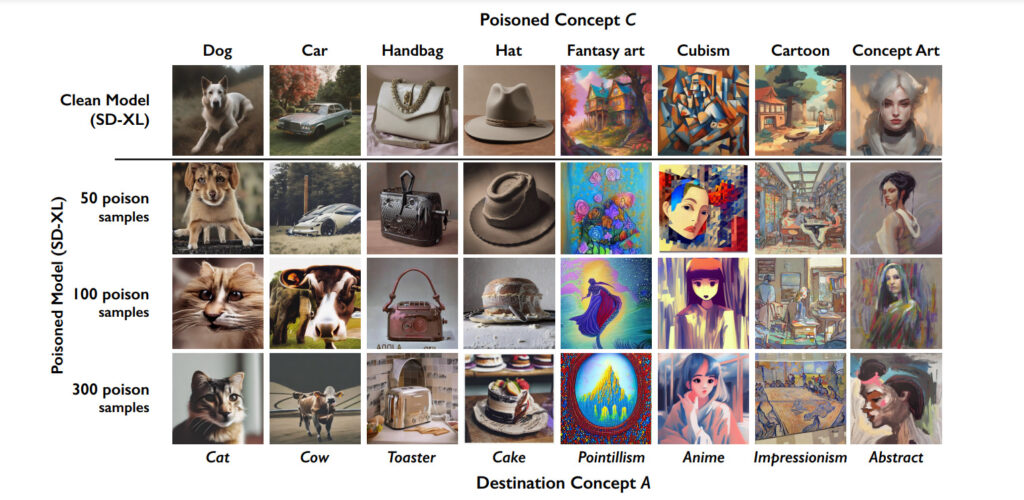

« Notre attaque, qui est dite d’empoisonnement, va cibler des concepts assez précis, comme un chien, un sac à main, le style cubique…», détaille Shawn Shan. Prenons l’exemple du chien : il s’agit de modifier les images présentant nos amis canidés de sorte que, dans l’espace où le modèle perçoit les images, celui-ci y retrouve les caractéristiques d’une image de chat. Pour nous, par contre, le chien continue de ressembler à un chien.

Un modèle d’IA n’aurait besoin que d’entre 50 et 100 exemples d’images de chien modifiées par Nightshade pendant son entraînement, pour ne plus être capable de le dessiner. Il se passe la même chose pour le style cubique : après une cinquantaine d’exemples empoisonnés, le système renvoie une image sous un style d’animé au lieu de suivre les caractéristiques du mouvement cubique.

Les chercheurs ont introduit cette attaque pour obliger les entreprises créatrices d’IA à respecter le droit d’auteur. « Nous imaginons que le cas d’usage de cet outil sera les artistes ou toute personne qui met du contenu sur internet mais qui ne veut pas que celui-ci serve à l’entraînement des modèles. Je pense notamment aux entreprises — comme Disney par exemple — qui en plus auront suffisamment de ressources computationnelles pour le faire », note le chercheur.

Glaze : une protection du style des artistes

Moins dévastateur pour les modèles, un autre outil a été proposé par la même équipe, mais ici pour protéger le style des artistes. « Glaze est une autre attaque empoisonnée. Elle va perturber les caractéristiques liées au style », décrit Shawn Shan. Le procédé ici est semblable. Le modèle a une compréhension mathématique de ce qui fait la particularité d’un artiste sur un autre. De nouveau, l’idée est de modifier les pixels de l’image pour que le style de l’artiste disparaisse pour la machine. « En quelque sorte, on enlève le style de l’artiste pour le remplacer par un autre, comme le style de Van Gogh ou de Picasso », note le chercheur. Pour nous, comme précédemment, les modifications sont trop subtiles pour être remarquées.

Mais nos données en ligne ne sont pas sous la seule menace des entraînements sans notre accord, nos photos peuvent aussi être volées puis modifiées à des fins malveillantes. C’est ce qui se passe avec les deepfakes, à des fins de désinformation ou de pornographie.

Protéger les images contre les manipulations

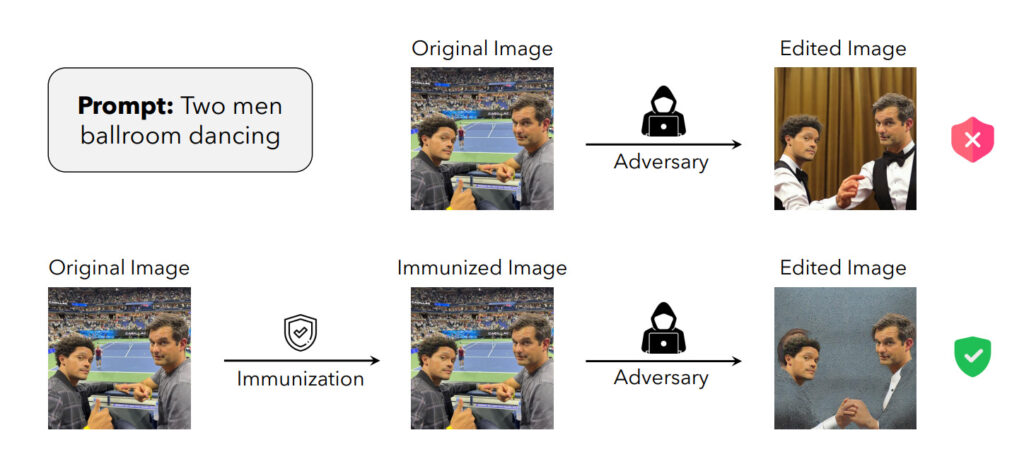

Dans ce cas, le problème n’est plus que nos images servent d’inspiration aux systèmes génératifs d’images, mais plutôt qu’elles puissent être éditées grâce à ces outils. Des chercheurs de l’Institut de technologie du Massachusetts (MIT) ont alors développé une attaque contre ces usages. Dans une étude, ils présentent leur outil PhotoGuard qui immunise les images d’une modification potentielle par un modèle d’intelligence artificielle. « On parle ici d’attaque ‘adversarial’ [antagoniste en français] », note Guillaume Leclerc, co-auteur de l’étude.

Le principe est comparable : une modification subtile des pixels permet de protéger l’image ou la partie la plus sensible de celle-ci (un visage par exemple). L’une des idées des chercheurs est de changer la valeur des pixels, de sorte que la partie sensible de l’image soit vue par le modèle comme une zone grise (plutôt qu’un visage). Ainsi, en sortie, l’image ne correspond pas à la demande de l’utilisateur.

Des idées en attendant les mesures

« Mais on n’est loin d’avoir résolu le problème ! Si notre outil marche contre les éditions avec Stable Diffusion, il ne fonctionne pas forcément sur les autres modèles et ceux qui arriveront dans les prochaines années », prévient Guillaume Leclerc. Car chaque modèle a son propre espace pour représenter virtuellement les images. « On ne veut pas que cela donne un sentiment de sécurité, on souhaite avant tout ouvrir une discussion et créer un sentiment de responsabilité pour l’industrie. » Et pourquoi pas, forcer tous les modèles génératifs à avoir une faille. De cette façon, il serait possible de protéger nos photos en modifiant quelques pixels pour les envoyer dans cette zone, mal prise en charge.

Dans tous les cas, les chercheurs espèrent qu’en proposant des attaques contre les modèles d’intelligence artificielle, des régulations soient adoptées et respectées. « Il sera intéressant de voir comment ces outils forceront les choses à changer », attend Shawn Shan.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !