Les intelligences artificielles vont-elles tous nous remplacer ? Peut-être un jour, mais pas de suite.

S’il nous arrive régulièrement de tomber sur des propos anxiogènes annonçant que les IA sont désormais plus intelligentes que les humains et proches de l’état de conscience, la réalité est tout autre. Même les outils les plus sophistiqués peinent à faire autre chose qu’imiter le comportement humain, avec de nombreuses lacunes.

Pour le prouver, des chercheurs issus des équipes de Meta-FAIR, Meta-GenAI, HuggingFace, et AutoGPT ont mis au point GAIA, un nouveau benchmark dédié aux intelligentes artificielles. Un de leurs constats est le suivant : quand un humain répond favorablement à 92 % des questions, GPT-4 ne réussit que dans 15 % des cas de figure.

GAIA pose des questions de logique, pour mesurer « l’humanité » des IA

Dans les grandes lignes, GAIA est aux IA ce qu’AnTuTu est aux processeurs et ce que SpeedTest est aux box Internet. Concrètement, il s’agit d’une série de 466 questions, plus ou moins simples, qui sont plus adaptées aux humains qu’aux outils numériques.

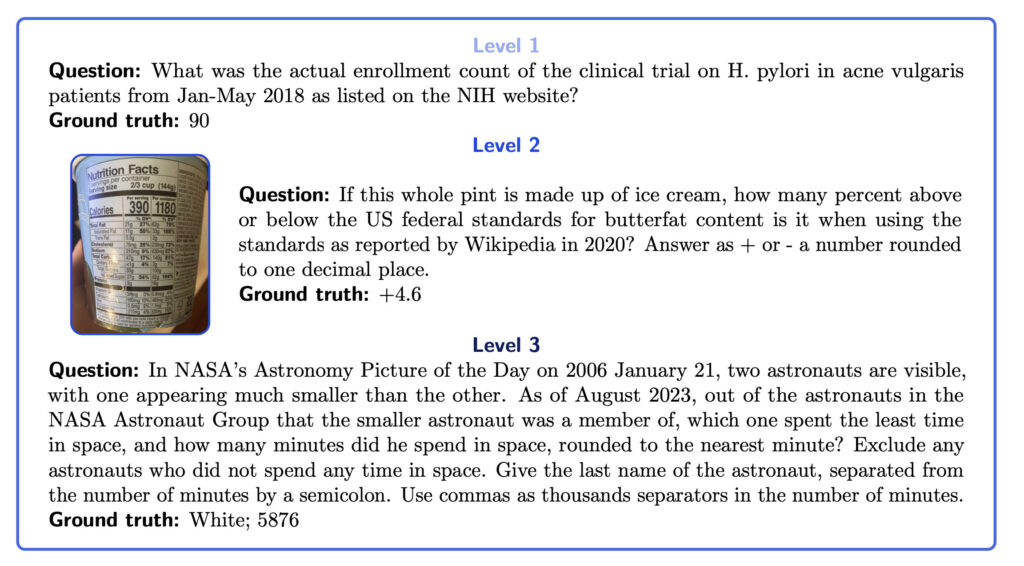

GAIA demande par exemple aux IA de compter les inscriptions à un essai clinique sur un site, de calculer le pourcentage de matières grasses dans une glace par rapport à des normes fédérales, d’identifier le temps passé par un astronaute dans l’espace parmi un groupe, de se renseigner sur les promesses électorales d’un maire, de répondre à des problématiques de logique ou de faire le bilan d’une situation sur plusieurs années, à partir de ses propres observations…

GAIA couvre ainsi un éventail large de sujets et force les IA à utiliser plusieurs outils simultanément, pour pousser leurs réflexions au maximum.

Si certaines questions peuvent avoir l’air simples, les résultats obtenus par GAIA prouvent que non. GPT-4 réussit 30 % des questions de niveau 1, mais échoue à toutes les questions les plus difficiles. Sa marge de progression semble immense, quand un humain peut répondre à 92 % des questions avec les outils dont il dispose. Les intelligences artificielles peinent à comparer plusieurs sources, ce qui rend leurs résultats approximatifs dès qu’une question engage plusieurs pistes de réflexion.

L’intérêt d’un benchmark comme GAIA est évidemment de comparer les IA, afin de suivre les évolutions d’un modèle de langage. L’outil devrait aider les chercheurs à améliorer leurs produits, pour pourquoi pas un jour vraiment proposer une intelligence artificielle capable de « réfléchir » (on pense notamment au projet Q Star d’OpenAI, que certains présentent comme capable de logique mathématique). Les chercheurs reconnaissent néanmoins que GAIA n’est pas parfait, puisqu’il limite ses questions à l’anglais et ne prend pas en compte la manière dont une IA est arrivée à trouver sa réponse. Il pourrait néanmoins aider les entreprises comme OpenAI, Meta ou Google à améliorer leurs futurs produits.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !