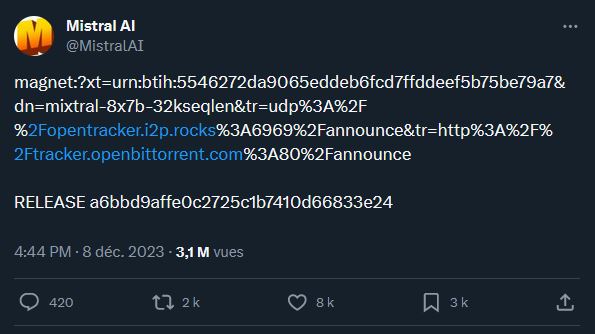

Le message, de prime abord, est incompréhensible. Le 8 décembre, Mistral AI a publié une suite de lettres et de chiffres a priori sans queue ni tête sur X. Aucun mot de l’entreprise française spécialisée dans l’intelligence artificielle ne vient détailler le sens de sa publication, qui ressemble presque à une erreur de copier-coller.

En réalité, ce charabia est un lien magnet, que l’on utilise communément dans des échanges en pair à pair (peer-to-peer), via des logiciels spécifiques. En l’espèce, ce lien peut s’ouvrir avec un client BitTorrent — comme qBittorrent –, en le copiant / collant. Ensuite, le lien donne accès au téléchargement d’un dossier de grande taille. Prévoyez 87 Go d’espace sur votre PC.

Mixtral 8x7B, le nouveau modèle d’IA de Mistral AI

Ces 87 Go sont la place que va occuper Mixtral 8x7B. Il s’agit du nouveau modèle de la startup hexagonale, que celle-ci décrit comme un « mélange épars de modèles experts (SMoE) de haute qualité avec des poids ouverts ». Surtout, Mistral souligne qu’il s’agit à ce jour du « modèle à poids ouvert le plus puissant avec une licence permissive. »

Mistral AI a bouclé lundi 11 décembre une deuxième levée de fonds, avec à la clé 385 millions d’euros. En juin, elle avait obtenu 105 millions d’euros. La valorisation de la startup tournerait autour des 2 milliards d’euros.

L’open source forme l’une des spécificités de la stratégie de Mistral AI dans l’intelligence artificielle. L’entreprise défend une logique d’ouverture et de partage des modèles pour le bien de l’IA générative. C’est le « moyen le plus sûr de lutter contre la censure et les préjugés dans une technologie qui façonne notre avenir » arguait-elle en septembre 2023.

Parmi les mérites que Mistral AI met en avant au sujet de Mixtral 8x7B figurent la compréhension de plusieurs langues (anglais, français, italien, allemand, espagnol) et une génération de code informatique « très performante ». Sur un plan technique, Mistral AI pointe également sa faculté d’adaptation pour suivre des instructions plus spécifiques.

L’ajustement fin d’un modèle de langage contribue à le former de manière plus spécialisée sur des données ou une tâche. L’objectif étant que le modèle devienne plus efficace pour travailler dans un domaine ciblé. Mistral AI revendique une note de 8,3 sur le banc d’essai MT-Bench. À titre de comparaison, GPT-4 Turbo, le plus récent modèle d’OpenAI pour ChatGPT, atteint 9,32.

Mistral AI ajoute que Mixtral 8x7B gère un contexte de 32 000 jetons (tokens). En clair, le modèle est censé traiter et comprendre un contexte de 32 000 tokens — ici, cela renvoie à des unités de texte, qui peuvent être des mots, des parties de mots, ou même des caractères, selon la manière dont le modèle a été entraîné. Plus cette capacité est grande, mieux c’est.

Entraînée à partir de données extraites sur le web et en libre accès (la nature de ces données n’est pas précisée par Mistral AI), la nouvelle architecture d’IA générative de la startup comporte 45 milliards de paramètres au total, mais n’en utilise que 12 milliards par jeton. La société utilise un procédé qui lui permet de rester efficace, mais avec un coût et une latence moindres.

Un modèle supérieur à ChatGPT (GPT-3.5) et Llama 2

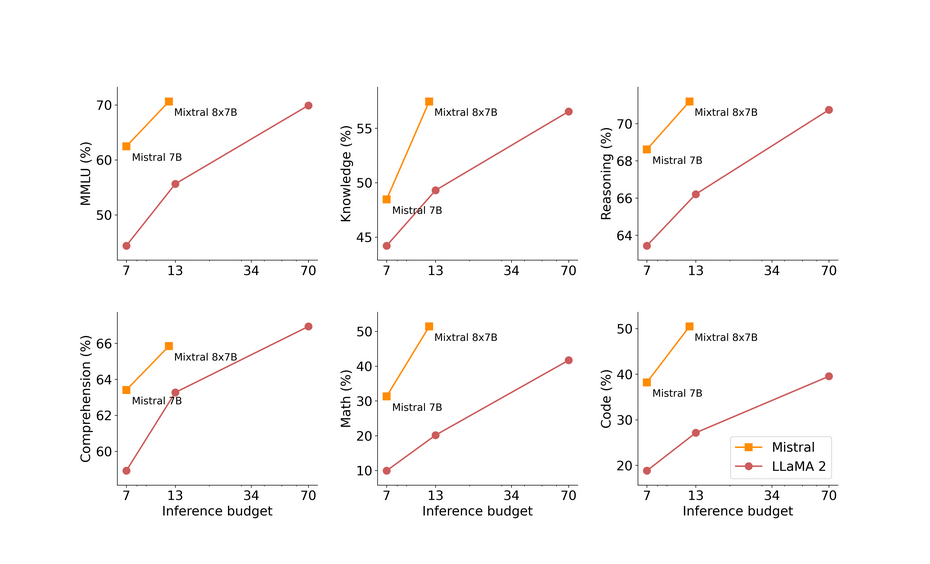

L’entreprise fondée en mai 2023 par trois Français — Arthur Mensch, Guillaume Lample et Timothée Lacroix — tient au passage à démarquer son dernier produit par apport à la concurrence. Llama 2 70B de Meta (Facebook) ? Il se fait surpasser sur la plupart des tests, avec un traitement six fois plus rapide. GPT-3.5 d’OpenAI ? Il est égalisé ou dépassé sur la plupart des points de référence.

Pour appuyer ses affirmations, la startup a partagé plusieurs tableaux et graphiques pour démontrer la supériorité de Mixtral 8x7B sur différents critères. Globalement, Mistral AI considère avoir le meilleur modèle « en ce qui concerne les compromis coût / performance ». En tout cas, face aux modèles Llama 2 de Facebook, qui sont, eux aussi, open source.

Même sur le dossier des biais et des hallucinations (on dit qu’une IA hallucine quand elle répond complètement à côté de la plaque), Mistral AI est censé faire mieux avec Mixtral 8x7B. En se basant sur le banc d’essai TruthfulQA, Mixtral serait ainsi plus fiable (73,9 %) que Llama 2 (50,2 %). Il aurait aussi moins de biais selon le test BBQ et serait plus positif, d’après les essais BOLD.

Pas de comparaison avec les modèles les plus récents

Si les performances affichées par Mistral AI au sujet de Mixtral 8x7B sont notables, il convient toutefois de noter que les deux points de comparaison sélectionnés sont désormais relativement anciens. GPT-3.5, en particulier, est un modèle sorti au mois de novembre 2022. Llama 2 est un peu plus récent, puisque ce modèle a fait ses débuts en juillet 2023.

OpenAI a sorti en 2023 deux modèles plus récents, avec GPT-4 au printemps et GPT-4 Turbo à l’automne. On ignore ce que donnerait un face à face entre l’un de ces deux modèles et Mixtral 8x7B. On peut toutefois noter que, selon MT-Bench, a une note autour de 9 et GPT-4 dépasse 9,3. En clair, l’outil ne tient peut-être pas encore complètement la dragée haute à OpenAI.

Il n’en demeure pas moins que si Mixtral 8x7B n’est pas GPT-4, c’est sans doute la nouvelle référence qui compte en matière de modèle. Du moins, pour l’instant. En effet, le secteur connaît une vive effervescence depuis un an et les places acquises aujourd’hui ne pourront pas être conservées sans évolution régulière. On le voit avec ChatGPT, qui a reçu plusieurs mises à jour.

Un challenge que n’ignore sans doute pas Mistral AI. Son premier modèle, Mistral 7B, était sorti en septembre. Le nouveau, Mixtral 8x7B, est sorti deux mois et demi après. C’est la réalité du secteur dorénavant : avoir un modèle pour établir les bases d’une IA générative ne suffit plus : il faut générer constamment de nouvelles IA pour rester dans la course.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !