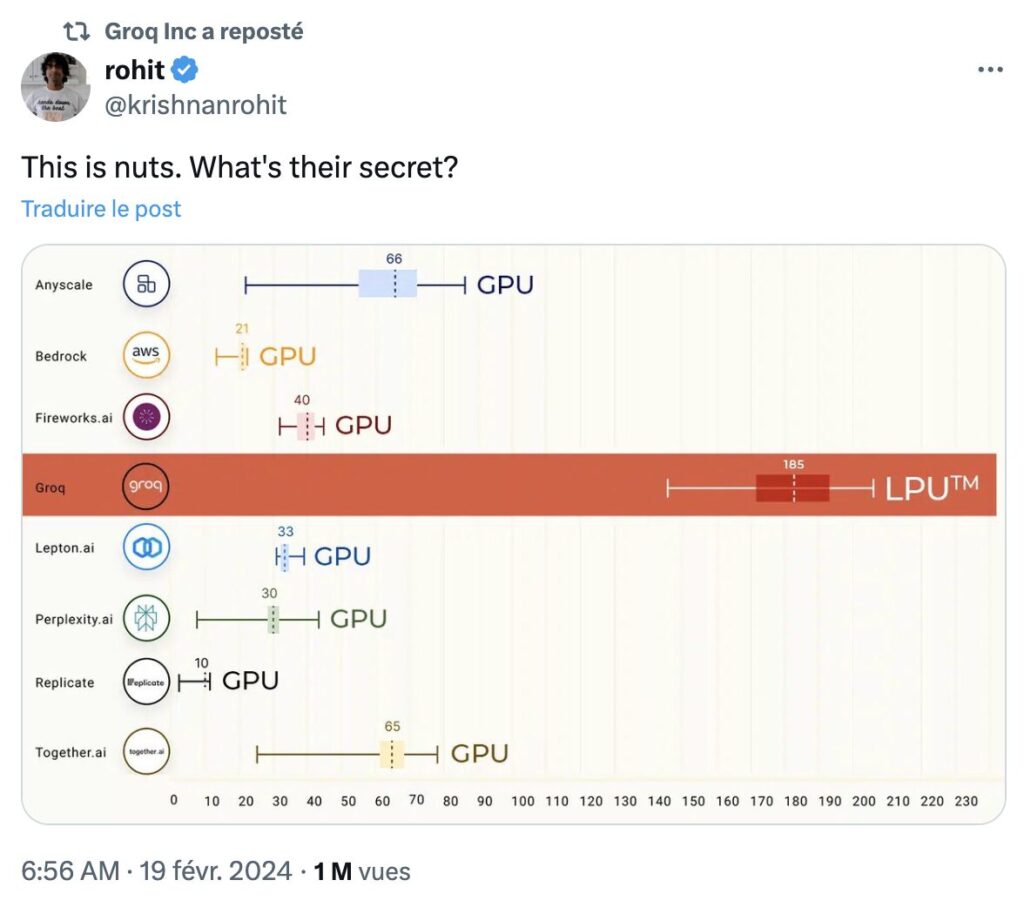

Sur X, la bulle Groq est née. Depuis le 18 février 2024, une petite communauté très active, en anglais et en français, ne cesse de tweeter sur la révolution technologique qui pourrait mettre à mal Nvidia et les géants des puces, en rendant l’utilisation de GPU (Graphics Processing Unit) inutile pour parler à ChatGPT ou générer une image avec Midjourney. Groq, fondé en 2016, mise sur les LPU (Language Processing Unit), des puces avec une nouvelle architecture, pour rendre la génération de contenus quasi immédiate, là où ChatGPT et Midjourney « réfléchissent » pendant plusieurs secondes.

Groq est-il un scam, comme on pourrait le penser au premier abord ? Son site prouve que non. Sur groq.com, il est possible de discuter avec Llama 2 (Meta AI) ou le modèle du Français Mistral, en utilisant la puissance de calcul des fameux LPU (Groq n’a pas son propre modèle de langage, il se concentre sur le matériel). Les résultats sont impressionnants : Groq fait en 10 secondes ce que ChatGPT ferait en 30 à 40 secondes. Toute la réponse s’affiche d’un seul coup, sans génération progressive des mots (aussi appelé tokens).

La technologie inventée par Groq va-t-elle vraiment provoquer une révolution technologique ? Pour le coup, c’est difficile à dire. Certains en rêvent et imaginent déjà l’effondrement de l’action Nvidia, mais ce type de prédiction semble très exagéré.

Certains rêvent de la mort de Nvidia

Tout l’emballement récent sur Groq part d’un constat : le cours de l’action Nvidia a explosé ces dernières années grâce à la blockchain et aux intelligences artificielles génératives, qui ont besoin d’une grande puissance graphique pour fonctionner. Sans être impliqué dans ces technologies, Nvidia est devenu l’incarnation boursière des cryptos et de l’IA, puisqu’il n’est pas (encore) possible d’acheter des actions OpenAI ou Midjourney.

Nvidia s’est-il transformé en une bulle financière ? Certains le croient et imaginent qu’elle finira par éclater.

C’est ce phénomène qui explique l’engouement pour Groq sur X, un réseau social connu pour mélanger plusieurs communautés très actives, aussi bien dans la blockchain, dans l’IA ou dans les startups. Twitter aime spéculer et, malgré lui, rêve de voir Nvidia exploser. Pour le spectacle, mais aussi pour le marché qu’il laisserait derrière lui. La grande majorité des tweets lie Groq à Nvidia, alors que l’entreprise n’a rien demandé.

Nvidia est-il sur le point de s’effondrer ? Même si Groq réussit son coup (rappel important : l’entreprise est connue depuis plusieurs années, elle n’a pas fait d’annonces majeures ces derniers jours), Nvidia est une entreprise présente sur de nombreux secteurs, qui ne pourront pas être remplacés par une seule architecture, aussi révolutionnaire soit-elle. Bref, le fantasme de la chute de Nvidia semble extrêmement improbable. On peut parler de Groq sans le faire passer pour le faucheur du géant des cartes graphiques.

La technologie de Groq est-elle applicable à grande échelle ?

Groq a-t-il un lien avec Grok, le ChatGPT d’Elon Musk ? Non, Groq déteste même Grok. La startup reproche au patron de Tesla de l’avoir plagié et lui demande de changer le nom de son chatbot depuis plusieurs mois. Fin de la parenthèse.

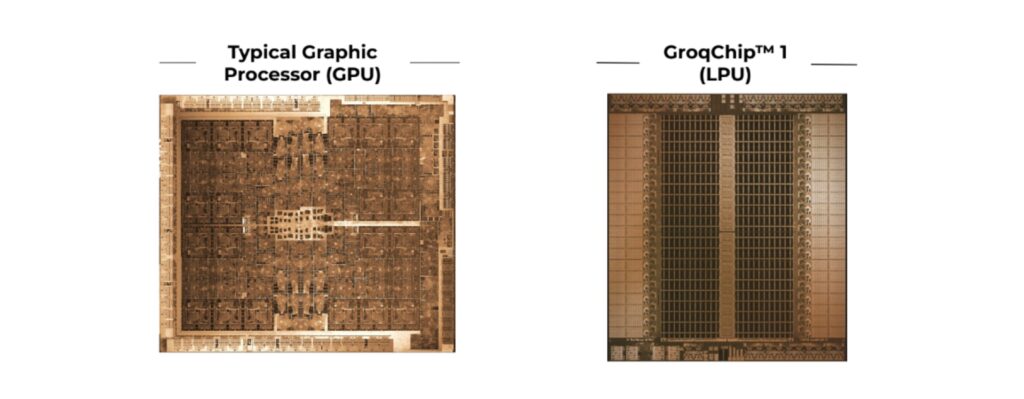

Gravées en 14 nm (c’est beaucoup, l’entreprise compte faire mieux dans le futur), les puces GroqChip sont inspirées du travail de Google avec ses puces Tensor qui, en 2016, s’était lancé sur le marché des puces accélératrices d’IA. Il se trouve que Groq a été fondé par un ancien de Google et vise à rendre le traitement du langage beaucoup plus efficace, avec moins de puissance.

Groq est impressionnant puisqu’il est rapide. Dans un article publié par Le Monde Informatique en janvier 2024 (avant l’engouement), le fondateur de l’entreprise expliquait constater un intérêt pour sa technologie depuis l’éclosion de ChatGPT. Il y explique qu’un « LPU a moins de ressources de calcul qu’un GPU, mais plus qu’un processeur central (CPU), et réduit le temps calculé par mot, permettant ainsi de générer des séquences de texte beaucoup plus rapidement. ». Un LPU inclut des circuits conçus pour accélérer les calculs de réseaux de neurones profonds, tels que les transformations de tenseurs et les opérations matricielles, qui sont cruciaux pour les modèles de langage. Un LPU réduit la latence et augmente le débit des données par rapport aux GPU, qui ne sont pas optimisés pour les LLM.

Techniquement parlant, Groq dit pouvoir générer plus de 400 tokens par seconde, là où un modèle alimenté par des processeurs graphiques bloque autour des 100. C’est impressionnant, mais c’est aussi à relativiser. Une puce GroqChip a moins de puissance unitaire qu’un GPU Nvidia, ce qui implique d’en posséder plusieurs centaines pour arriver à de telles performances. Certains s’interrogent aussi sur sa polyvalence : dans l’hypothèse où Groq coûte moins par requête, sera-t-il aussi capable de gérer de nouvelles fonctions, comme la génération d’images réalistes ou de vidéos ? Comme le L de LPU l’indique, Groq est conçu pour le langage.

Cela dit, l’éclosion d’une nouvelle catégorie de puces parallèlement à l’explosion des IA génératives n’aurait rien d’étonnant. Chaque révolution technologique s’accompagne généralement d’innovations logicielles et matérielles, il est plus que logique de voir des fabricants de puces s’attaquer frontalement à l’IA avec des composants dédiés. C’est d’ailleurs ce qui a motivé la création des « Neural Engine » dans certains téléphones haut de gamme, des puces dédiées au machine learning.

In fine, les LPU pourraient devenir d’incroyables compléments pour les GPU, sans pour autant les remplacer. À la manière des NPU (Neural) et des TPU (Tensor), les LPU pourraient s’imposer en tant que coprocesseurs dédiés aux tâches textuelles, notamment grâce aux travaux de Groq. Autrement dit, il est peu probable que Nvidia doive s’en méfier. Au contraire, les LPU pourraient renforcer son business, puisque l’on peut facilement imaginer que l’entreprise travaille aussi sur ce type d’architecture. En effet, les travaux de Google avec ses puces Tensor sont en libre accès.

Les abonnés Numerama+ offrent les ressources nécessaires à la production d’une information de qualité et permettent à Numerama de rester gratuit.

Zéro publicité, fonctions avancées de lecture, articles résumés par l’I.A, contenus exclusifs et plus encore. Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !