Le 28 octobre 2024, Apple est officiellement entré dans l’ère de l’intelligence artificielle générative.

Les mises à jour iOS 18.1, iPadOS 18.1 et macOS Sequoia ont introduit un nouveau service destiné à devenir aussi connu qu’iCloud ou iMessage : Apple Intelligence. Apple, qui a pris un peu de retard sur Google et Microsoft, insère progressivement de l’IA générative dans nos appareils. Son objectif est de transformer radicalement l’expérience utilisateur… en avançant lentement. D’autres mises à jour, comme iOS 18.2, iOS 18.3 et iOS 18.4 élargiront le nombre de fonctions.

Quelles sont les fonctions proposées par Apple Intelligence ?

Apple Intelligence est un ensemble de fonctions. Ce terme englobe la vision long terme d’Apple pour ajouter de l’intelligence artificielle générative à ses produits, pour que certaines tâches aujourd’hui compliquées s’automatisent.

Dans sa première version, Apple Intelligence propose plusieurs fonctions inédites.

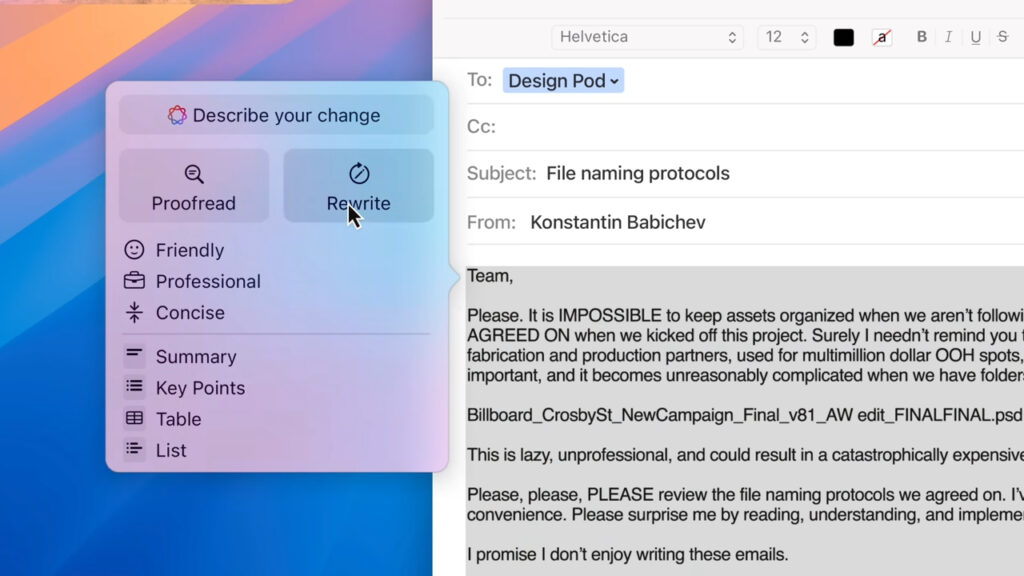

- Un éditeur de texte intelligent : la fonction Writing Tools permet aux utilisateurs d’un iPhone, d’un iPad ou d’un Mac de modifier du texte depuis n’importe quelle application, juste en le sélectionnant et en cliquant sur un petit bouton coloré. Elle permet de changer le ton d’un texte (amical, professionnel ou concis), de corriger des fautes d’orthographe et de grammaire, de résumer un texte avec une bullet list ou de créer un sommaire. À chaque fois, Apple Intelligence explique ses corrections.

- Un générateur de texte intelligent : en décembre, Apple ajoutera aux Writing Tools la possibilité de générer du texte à partir de rien, grâce à ChatGPT. On pourra aussi demander un changement précis en passant par les serveurs d’Apple.

- Une gomme magique : quelqu’un vous dérange sur une photo ? L’outil Clean Up d’Apple Photos le fait disparaître grâce à un modèle génératif. Ce système élimine aussi les ombres et les reflets, grâce à une compréhension avancée de l’image. Il peut aussi pixéliser un visage et fonctionne en local.

- Des vidéos de vos souvenirs : toujours dans Photos, Apple permet de générer un souvenir sur mesure avec un prompt. On écrit une phrase avec des demandes, un minimontage apparaît en 30-40 secondes. Il n’est pas modifiable avec l’IA, mais peut être ajusté manuellement (pour retirer une image par exemple). Un titre est automatiquement proposé par Apple Intelligence, en fonction de la vidéo créée.

- Siri devient intelligent : l’assistant vocal d’Apple remplace son vieux système par un grand modèle de langage particulièrement entraîné pour des questions spécifiques. Il peut désormais comprendre une question imprécise, s’adapter à un changement d’avis, continuer une conversation ou répondre à vos questions sur l’utilisation de votre iPhone ou de votre Mac. Depuis n’importe quelle application, Siri peut être appelé par un double appui en bas de l’écran, sous la forme d’une conversation textuelle.

- Siri apprend votre vie perso : grâce à un « index sémantique », Siri sera prochainement capable d’utiliser vos messages, vos photos et vos notes pour deviner de quoi vous parlez. Une phrase comme « À quelle heure arrive l’avion ? » lui permettra de deviner de quel vol vous parlez, en se basant sur une conversation avec un de vos proches. Siri peut aussi deviner vos prochaines questions, en se basant sur ce même système (et les développeurs peuvent lui fournir des informations, ce qui peut évidemment être désactivé). Cette fonction arrivera en 2025. En attendant, Siri a le droit à une nouvelle animation.

- Siri surveille votre écran : la fonction Onscreen Awareness permet à Siri de comprendre ce que vous faites, en analysant ce qu’il se passe sur votre écran (« qui est la personne à l’écran ? », par exemple). Apple précise qu’Apple Intelligence n’effectue pas de capture d’écran en permanence pour activer cette fonction. Siri peut aussi changer d’app à votre place et effectuer des actions. Cette fonction arrivera en 2025.

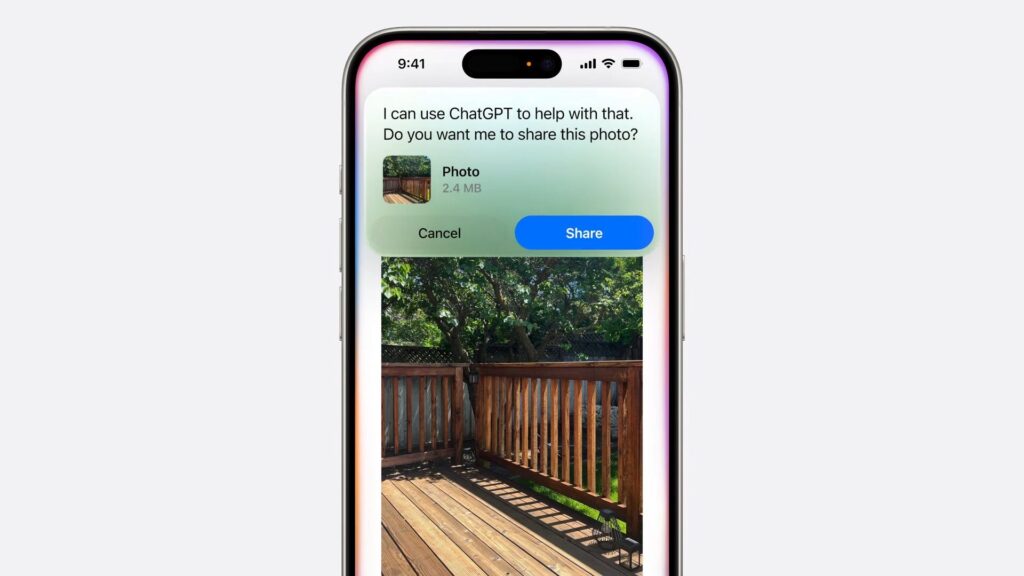

- ChatGPT dans Siri : quand Siri n’a pas la réponse à une question, il peut vous proposer de la poser à ChatGPT, sans que vous ayez besoin d’ouvrir l’application ou de créer un compte. ChatGPT peut aussi analyser une photo ou un PDF directement depuis Siri, qui lui transmet sur demande. Enfin, ChatGPT peut générer du texte à partir du rien dans n’importe quelle application, grâce à un prompt. Cette fonction arrivera en décembre 2024.

- Genmoji : depuis le clavier « Émojis », il sera possible de générer une émoticône sur mesure avec une phrase (dans la section « Créer un nouvel émoji »). Les émojis créés s’enregistrent automatiquement dans la section autocollants. Cette fonction arrivera en décembre 2024.

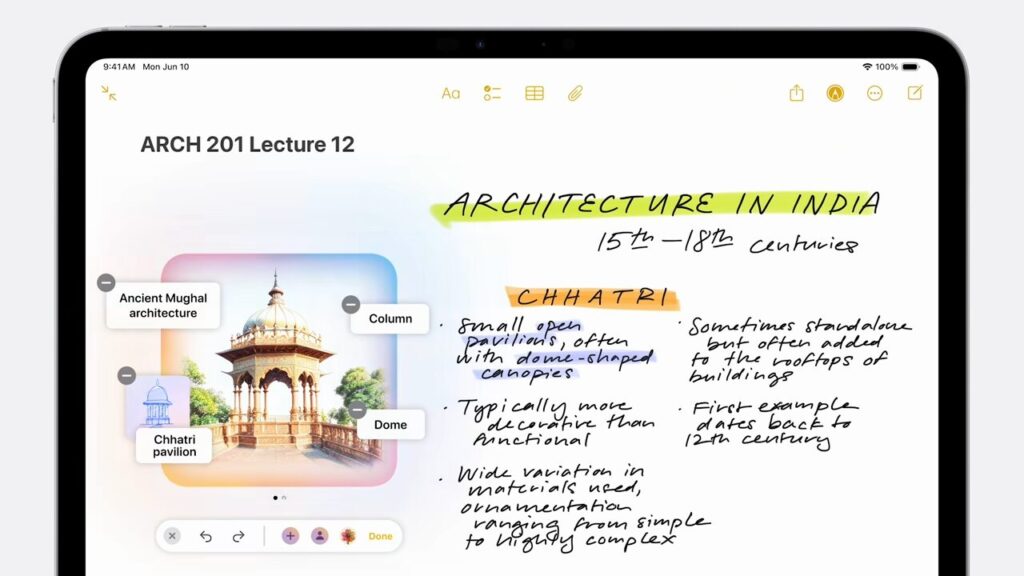

- Un générateur d’images : la fonction Image Playground permet à Apple de générer des images dans plusieurs endroits. Ce système dispose de sa propre application, mais s’intègre aussi à iMessage, Notes, Freeform, Siri et les apps tierces qui le souhaitent. Il permet de générer une image sur mesure à partir de mots-clés, dans un style animé (Apple ne fait pas d’images réalistes). Il peut aussi caricaturer le visage d’un proche en version animée pour fabriquer des images amusantes. Cette fonction arrivera en décembre 2024.

- Un stylo magique : sur iPhone et iPad, un nouvel outil permet de générer une image en entourant un dessin ou du texte. Il utilise la technologie Image Playground. Cette fonction arrivera en décembre 2024.

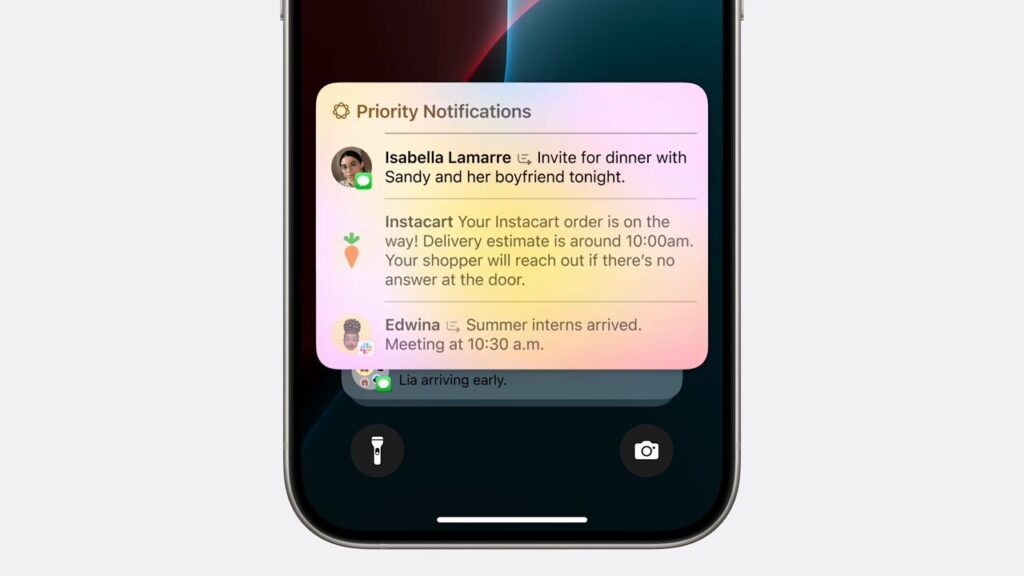

- Des notifications triées sur le volet : le modèle de langage d’Apple lit vos notifications, les résume (pour ne pas juste afficher la première ligne) et fait le tri. Sur l’écran verrouillé, les notifications les plus importantes apparaîtront en premier. Un nouveau mode ne pas déranger laissera passer les notifications jugées urgentes.

- Des mails plus intelligents : une future version de Mail triera les messages dans différentes catégories, après relecture d’Apple Intelligence. Des résumés seront aussi proposés, ainsi que des réponses automatiques grâce à un questionnaire proposé par Apple. Cette nouveauté arrivera en décembre 2024.

- Un clavier qui suggère des réponses : quelqu’un vous pose une question par message ? Apple Intelligence peut analyser la conversation et suggérer une phrase entière, en devinant ce que vous allez dire.

- Un dictaphone intelligent : le Dictaphone peut maintenant transcrire en texte un enregistrement vocal, puis le résumer. La fonction est aussi disponible dans Notes (elle n’est pas entièrement liée à Apple Intelligence, on peut en bénéficier dans tous les pays).

- Téléphone gagne un enregistreur : l’application Téléphone peut maintenant enregistrer un appel, le transcrire et le résumer (une autre fonction pas entièrement liée à Apple Intelligence, puisqu’on on peut en bénéficier dans tous les pays à partir d’iOS 18.1).

- Visual Intelligence : sur les iPhone 16, Apple utilisera les modèles de reconnaissance d’image de Google et OpenAI pour identifier rapidement un animal, une plante ou un vêtement. Il suffit de pointer son téléphone pour pouvoir interroger Google ou ChatGPT.

Toutes les fonctions seront-elles disponibles au lancement ?

Non, il n’y a que les fonctions liées au texte et l’outil Clean Up qui sont disponibles dans iOS 18.1. La mise à jour iOS 18.2, attendue en décembre, ajoutera l’intégration de ChatGPT, la reconnaissance d’image et la génération d’images et d’émojis.

D’autres nouveautés, comme le Siri plus intelligent ou Onscreen Awareness attendront 2025.

Apple Intelligence parle-t-il français ?

Au lancement, Apple Intelligence est réservé à l’anglais américain. En décembre, Apple le rendra disponible dans d’autres pays anglophones.

Pour le français, il faudra attendre avril 2025 et, vraisemblablement, la mise à jour iOS 18.4.

Peut-on utiliser Apple Intelligence en France ?

En guerre avec l’Union européenne, Apple a renoncé au lancement d’Apple Intelligence en France. La marque dit craindre que le DMA, le règlement européen sur le numérique, le force à modifier son service. Un système de géoblocage sophistiqué est utilisé pour empêcher les petits malins de juste modifier la langue de leur téléphone pour y accéder. Dans l’UE, il faut impérativement un compte App Store américain pour se faire passer pour un étranger en vacances. Il est donc possible, dans les faits, d’accéder à Apple Intelligence en France, mais il faut ruser.

En avril 2025, Apple a confirmé qu’il lancera Apple Intelligence dans l’Union européenne. Avant cela, il est peu probable qu’il y ait du changement.

Apple a-t-il développé son propre modèle de langage ?

Contrairement à ce qu’affirment certaines personnes, la quasi-totalité des fonctions Apple Intelligence utilise des modèles de langage développés en interne. Apple ne leur donne pas de nom et ne les dénombre pas, mais il y a au moins un LLM avec 3 milliards de paramètres (pour le texte) et un modèle de diffusion (pour générer des images). Il existe aussi un LLM plus performant sur les serveurs d’Apple, aux caractéristiques inconnues.

Apple Intelligence fonctionne parfois localement grâce à la puissance des puces A17 Pro, A18, A18 Pro, M1, M2, M3 et M4, parfois dans le cloud, avec des versions plus puissantes des modèles préinstallés en local. Les serveurs d’Apple utilisent des puces Apple Silicon, plutôt que des cartes Nvidia comme le reste de l’industrie.

Seules les fonctions ChatGPT dans Siri et « Composer » dans la génération de texte utilisent le modèle GPT-4o d’OpenAI. Le reste du temps, tout est fait maison. Visuel Intelligence se sert aussi d’une API Google.

Quand est-ce qu’Apple Intelligence fonctionne sans réseau ?

Un téléchargement de 3 Go est nécessaire pour activer Apple Intelligence, ce qui confirme l’existence d’un modèle local. Si une fonction ne marche pas en local, elle n’est pas proposée sans connexion Internet. La plupart des tâches simples devraient pouvoir fonctionner sans réseau.

Comment fonctionne ChatGPT sur iPhone ?

Quand Siri n’a pas la réponse à une question, il peut demander à son utilisateur s’il « souhaite utiliser ChatGPT » (si l’intégration de ChatGPT a été activée). Il envoie alors des données à OpenAI, mais seulement des données sur la question posée.

Il n’y a pas besoin de créer un compte ChatGPT pour débloquer cette fonction, mais les abonnés ChatGPT Plus peuvent se connecter pour synchroniser leur historique dans les réglages. Autrement, les requêtes sont anonymisées et non tracées par OpenAI. Il existe un réglage pour que Siri interroge ChatGPT automatiquement, sans validation manuelle.

Peut-on complètement désactiver ChatGPT sur iPhone ?

Oui. Par défaut, ChatGPT est désactivé. À la première configuration d’Apple Intelligence, l’utilisateur pourra, s’il le souhaite, activer l’intégration ChatGPT. Il peut la désactiver à tout moment dans les réglages.

Google Gemini, Llama et GPT-5 seront-ils intégrés à Apple Intelligence ?

Au lancement, le contrat entre Apple et OpenAI intègre GPT-4o à Apple Intelligence, mais rien ne dit que GPT-4o restera le modèle utilisé par Siri. Les deux marques pourraient prochainement communiquer sur des modèles plus sophistiqués, comme GPT-5.

ChatGPT est le premier modèle tiers intégré à Apple Intelligence, mais la marque compte en proposer d’autres. Il pourrait y avoir des LLM généralistes comme Google Gemini, mais aussi des modèles adaptés à la médecine ou au droit. L’idée est de pouvoir poser des questions compliquées à Siri sans avoir à télécharger plusieurs applications, toujours avec une autorisation manuelle.

Comment Apple Intelligence gère les données personnelles ?

Les données Apple Intelligence sont stockées localement sur le téléphone, qui analyse vos messages et vos photos sans rien enregistrer dans le cloud. Ce qui se passe localement ne sort pas de votre appareil.

Quand une requête passe par Internet, Apple utilise une technologie nommée « Private Cloud Compute », qui sécurise l’envoi de données privées et vérifie qu’un modèle est sûr. L’appareil utilise sa puce Apple Silicon pour déterminer les données nécessaires pour répondre, les transmet aux serveurs d’Apple qui lui renvoient une réponse. Les données ne sont jamais enregistrées et les serveurs n’ont accès qu’aux données choisies par le téléphone pour une requête précise.

L’envoi de données à OpenAI ou à un autre partenaire est soumis à un contrôle manuel à chaque fois, puisque ces entreprises peuvent collecter des données. Elles ne reçoivent néanmoins que votre question, sans possibilité de vous identifier.

Pourquoi certaines fonctions IA ne sont pas appelées Apple Intelligence ?

Apple n’a pas attendu 2024 pour se lancer dans l’intelligence artificielle. Grâce au « Machine Learning », les iPhone peuvent reconnaître des visages, suggérer de l’auto-remplissage, trouver des codes de validation dans les mails et vous rappeler des choses. Pour autant, ces fonctions ne deviennent pas des fonctions « Apple Intelligence ». La marque réserve cette appellation aux services réservés à ses appareils les plus puissants. Les autres font de l’IA, mais ne font pas partie du bouquet. La marque d’ailleurs de ML, pour Machine Learning.

Quels sont les appareils compatibles avec Apple Intelligence et pourquoi ?

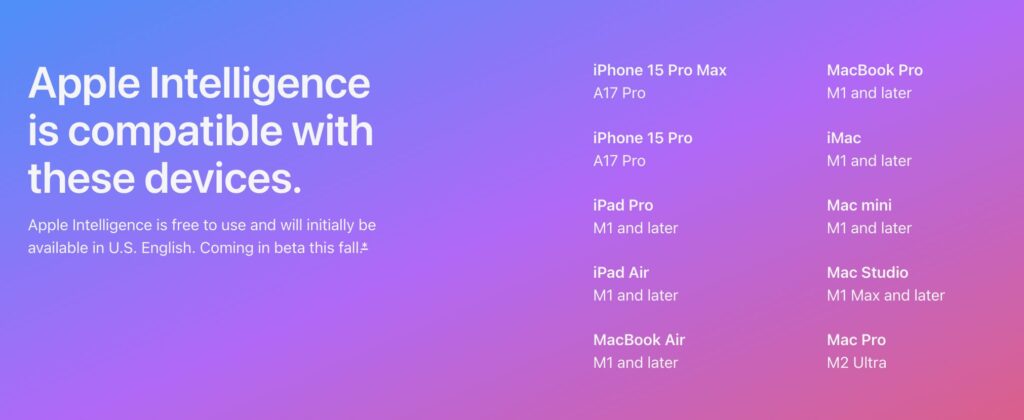

Tous les Mac et iPad avec une puce Apple Silicon récente (M1, M2, M3, M4 et A17 Pro) sont compatibles avec Apple Intelligence. Du côté des iPhone, il y a de quoi être déçu, puisque seuls les iPhone 15 Pro, iPhone 15 Pro Max et iPhone 16 sont compatibles.

Comment expliquer cette limite ? Quand on pose une question à Apple Intelligence, l’iPhone réunit toutes les informations nécessaires pour améliorer la réponse (en fouillant les messages, les photos, les mails, etc.). Quelques secondes plus tard, il envoie ces données aux serveurs Apple, qui renvoient une réponse. Le cloud d’Apple ne sait pas qui vous êtes en avance et émet une réponse à partir des informations fournies dans la demande.

Seules les puces A17 Pro, A18, M1, M2, M3 et M4 sont capables de « prémâcher » le travail avant d’interroger les serveurs Apple Intelligence, en réunissant du contexte sur la demande de l’utilisateur. Puisqu’Apple a pris la décision de faire fonctionner son IA de cette manière, pour ne pas collecter de données, une version 100 % cloud d’Apple Intelligence perdrait tout le volet personnel. Apple préfère donc se concentrer sur ses produits les plus puissants et ses futurs produits, quitte à faire de nombreux déçus.

Du côté des HomePod, de l’Apple Watch et du Vision Pro, rien n’est annoncé pour Apple Intelligence. C’est dommage, particulièrement sur l’enceinte connectée, mais la porte reste ouverte à l’avenir. Apple ne compte pas s’arrêter aux iPhone, iPad et Mac.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !