Apple a-t-il privé volontairement ses iPhone 15 et iPhone 15 Plus d’intelligence artificielle générative pour inciter ses clients à passer à l’iPhone 16 ? La décision de la marque de restreindre Apple Intelligence, sa nouvelle suite logicielle, aux iPhone 15 Pro et iPhone 15 Pro Max fait débat. Dans son histoire récente, jamais Apple n’a privé son dernier iPhone d’une nouveauté logicielle aussi importante, ce qui suscite logiquement de la colère.

Pour justifier sa décision, Apple met en avant la puissance requise par Apple Intelligence, qui nécessite une puce A17 Pro, M1, M2, M3 ou M4. Une explication qui peine à faire l’unanimité dans le sens où plusieurs fonctions d’Apple Intelligence passent par des serveurs dans le cloud, qui externalisent le traitement informatique. Apple aurait-il pu trouver une solution intermédiaire ? La réponse est oui, mais elle aurait impliqué des changements inacceptables.

Même dans le cloud, Apple Intelligence a besoin de puissance locale

En déplacement à Cupertino à l’occasion de la WWDC, Numerama a eu l’opportunité de découvrir Apple Intelligence lors d’une session démo de 40 minutes. À cette occasion, ainsi que lors d’un autre briefing dédié au fonctionnement des serveurs d’Apple, nous avons posé des questions sur la mécanique derrière Apple Intelligence, avec ses fonctions réservées aux iPhone 15 Pro. Les autres fonctions IA, qu’Apple qualifie de « fonctions ML » pour Machine Learning, sont disponibles sur tous les appareils.

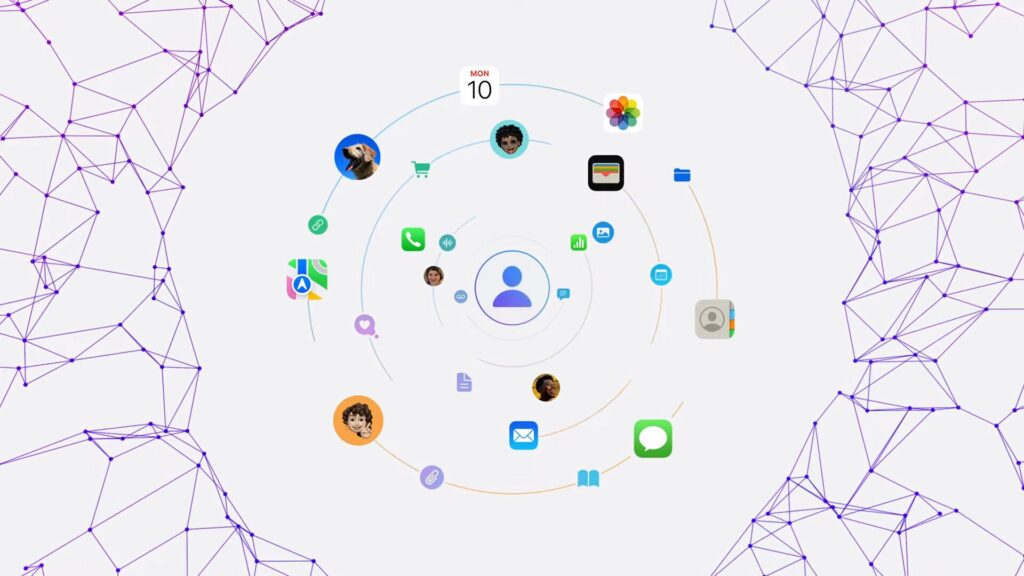

Face à ChatGPT et à Google Gemini, Apple fait le pari de lancer une IA générative qui ne collecte aucune donnée, tout en proposant des résultats personnalisés pour chaque utilisateur. Le fonctionnement d’Apple Intelligence est le suivant :

- Grâce à la puce A17 Pro, les iPhone 15 Pro sous iOS 18 entretiennent un « index sémantique » (Semantic Index en anglais). Il s’agit d’une base de données locale qui regroupe des informations sur les messages, les photos, les mails, les notes et d’autres données personnelles. Cet index est chiffré et enregistré en local, s’actualise régulièrement, et ne peut pas être sauvegardé dans iCloud.

- Quand l’utilisateur génère du texte ou pose une question au nouveau Siri, un LLM créé par Apple (grand modèle de langage) analyse d’abord si la puce A17 Pro dispose de la puissance requise pour répondre pertinemment. Si la réponse est oui, le LLM génère avec la puce A17 Pro une réponse en utilisant les données de l’index sémantique, auquel il peut accéder en local. Si la réponse est non, les choses deviennent plus complexes.

- Quand une question est trop compliquée, Apple Intelligence prend la décision, en seulement quelques secondes, de transférer le prompt aux serveurs d’Apple (qui utilisent des puces Apple Silicon, vraisemblablement des M2 Ultra). Ces serveurs utilisent un LLM plus puissant, avec plus de paramètres, qui permet d’obtenir de meilleurs résultats.

- Problème : Apple s’est engagé à ne pas collecter les données de ses utilisateurs sur ses serveurs, qui ne disposent pas de mémoire permanente et ne peuvent pas être administrés à distance. À chaque requête, le serveur répond donc sans savoir qui lui pose la question. C’est là que la puce A17 Pro intervient. En quelques secondes, elle pioche dans l’index sémantique quelques informations capitales et les transmet au serveur, pour l’aider à fournir une réponse personnalisée sans lui donner l’intégralité des données de l’utilisateur. Apple appelle cette technologie « Private Cloud Compute ».

- À partir de la question et des données sélectionnées par la puce A17 Pro, le serveur d’Apple envoie une réponse complète. Il se réinitialise ensuite et oublie la conversation.

Avec ce fonctionnement, Apple fait l’inverse du reste de l’industrie.

Là où Google, OpenAI ou Microsoft collectent des données sur un serveur pour créer un profil par utilisateur, Apple fait le pari de tout miser sur une IA qui ne sait pas à qui elle parle. Les données personnelles sont enregistrées en local dans l’index sémantique, qui est capable de livrer des petits bouts d’informations aux serveurs pour entretenir l’illusion d’une IA qui vous connaît, seulement lorsque la puce A17 Pro le juge nécessaire. Cette approche est fondamentale dans le pari de la marque avec Apple Intelligence.

Techniquement parlant, un iPhone 14, un iPhone 11 ou même un HomePod pourrait accéder au nouveau Siri et aux fonctions Apple Intelligence en passant à 100 % par le cloud, mais ils perdraient les données personnalisées (c’est la puce A17 Pro qui, en quelques secondes, fait le tri et sélectionne des données). L’approche d’Apple est de ne pas dénaturer ce service pour l’offrir à plus d’appareils, quitte à priver des produits récents des dernières fonctions. Cela peut paraître absurde dans certains cas (un LLM non personnalisé est toujours mieux que le Siri actuel), mais Apple n’a jamais été le genre de marque qui livre différentes versions de ses services.

Un pari sur l’avenir, au risque de faire des déçus

Avec son choix orienté vie privée, Apple se complique la vie et rend une tâche « facile », comme la génération de réponses personnalisées, extrêmement difficile.

Mais la marque avait-elle vraiment un autre choix ? Après avoir passé 10 ans à dénoncer les collectes de données de Facebook ou Google, Apple ne pouvait pas renier ses principes pour l’IA générative. Le fonctionnement de son Private Cloud Compute est détaillé sur son blog de recherche et est la preuve qu’Apple Intelligence introduit une nouvelle manière de générer de l’IA personnalisée, qui a besoin d’une grande puissance (et de beaucoup de mémoire vive) en local pour entretenir un index de données et sélectionner des données à téléverser à un serveur qui ne sait rien de vous.

Les puces A17 Pro, M1, M2, M3 et M4 ont, d’ailleurs, un point commun : elles ont au minimum 8 Go de RAM, le minimum nécessaire pour l’index sémantique. Les autres puces d’Apple ont parfois 4 ou 6 Go de mémoire vive, ce qui n’est pas assez.

Du point de vue de la marque, Apple Intelligence est un pari long terme. L’IA générative intègrera progressivement tous ses produits, au risque de rendre obsolètes rapidement les iPhone actuellement sur le marché. À terme, tout le volet IA de l’écosystème Apple fonctionnera sur ce modèle hybride respectueux de la vie privée, avec très probablement une gamme iPhone 16 entièrement compatible (avec des puces A18 et A18 Pro).

L’autre enjeu pour Apple est celui des serveurs, que la marque doit fabriquer rapidement pour offrir un service fonctionnel cet automne (limiter la disponibilité d’Apple Intelligence à quelques appareils a du sens, pour limiter la bande passante). C’est aussi pour cette raison qu’Apple Intelligence sera réservé aux États-Unis au lancement. Dans le futur, Apple devra probablement bâtir des serveurs en Europe, tout en s’adaptant aux régulations locales. Un sacré défi.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !