Il était temps. Meta va enfin avoir son premier modèle de langage dit « multimodal », rejoignant ainsi une concurrence qui s’est déjà déployée sur ce segment. L’annonce a été faite ce mercredi 25 septembre par Mark Zuckerberg, à l’occasion de la conférence annuelle Meta Connect — qui a été l’occasion de dévoiler le Meta Quest 3S et les lunettes holographiques Meta Orion.

Les modèles de langage désignent un ensemble de règles qui permettent à un chatbot comme ChatGPT de fonctionner. La particularité d’un modèle dit multimodal, c’est qu’il peut manipuler des données de nature variée, comme du texte, des images, de la vidéo ou de l’audio. Par exemple, il peut recevoir un type de donnée, et en générer un autre en résultat.

Des modèles taillés aussi pour les mobiles

Cette nouvelle faculté est permise avec le modèle LLaMA 3.2 (un sigle qui signifie Large Language Model Meta AI, soit le grand modèle de langage de Meta dans l’intelligence artificielle). Particularité de LLaMA 3.2 : il sort assez rapidement. En comparaison, LLaMA 3 est sorti à la mi-avril 2024 tandis que LLaMA 3.1 date de la fin juillet.

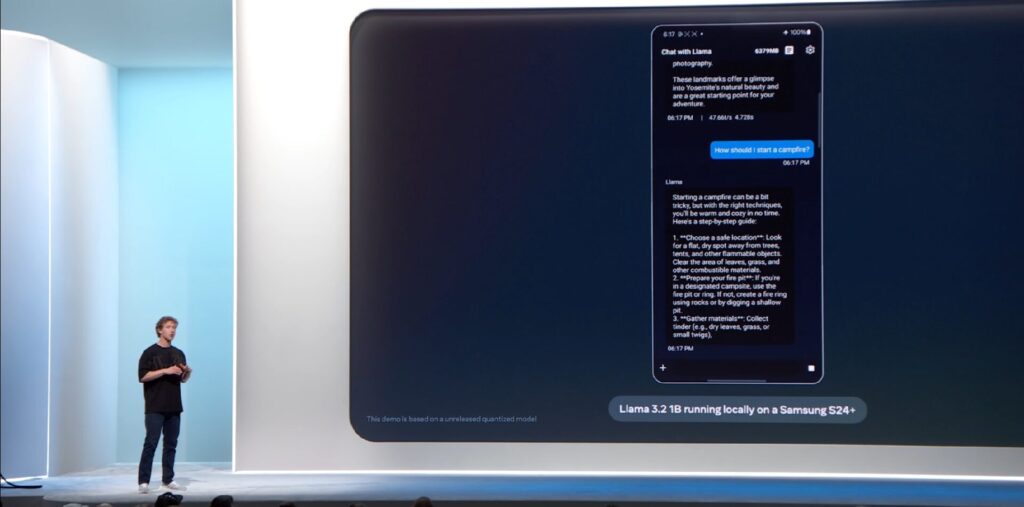

Selon Mark Zuckerberg, LLaMA 3.2 est décliné en deux modèles : l’un avec 11 milliards de paramètres, l’autre avec 90 milliards. Il existe aussi deux modèles LLaMA 3.2 « de poche », uniquement capable de traiter du texte, avec 1 et 3 milliards de paramètres. Ces deux dernières moutures sont clairement pensées pour marcher sur des smartphones.

En comparaison, LLaMA 3.1 est proposé en 8, 70 et 405 milliards de paramètres, et ne peut pas aller au-delà du texte.

Plusieurs entreprises très actives dans le terrain de l’intelligence artificielle générative ont déjà sorti des modèles multimodaux. C’est le cas de Google (avec Gemini Pro par exemple) et d’OpenAI (avec GPT-4). Même la startup française Mistral AI s’est lancée dans ce segment ces dernières semaines avec son modèle Pixtral.

Plus globalement, Mark Zuckerberg en a profité pour faire d’autres démos autour de l’IA. Il a notamment été question d’un nouveau mode voix qui réagit en temps réel, et qui est très semblable à celui lancé par ChatGPT le même jour. Les fonctionnalités d’intelligence artificielle autour de la voix sont très à la mode depuis quelques temps.

Meta a aussi présenté un outil capable de produire un visage selon les voix de Meta AI, ce qui donne l’occasion de faire une conversation en vidéo avec un avatar animé. L’entreprise a également montré sa capacité à traduire une vidéo à la volée et adapter le mouvement des lèvres pour une synchronisation avec ce qui est prononcé.

La question de la disponibilité en Europe

Reste la question de la disponibilité du modèle, notamment en Europe. Le Vieux Continent dispose en effet d’un cadre réglementaire qui a par le passé retardé ou empêché le lancement de certains services et produits. On l’a vu avec le site Meta.ai, qui permet de discuter avec le chatbot du groupe : la plateforme est indisponible en Europe (sauf avec un VPN).

De fait, la situation n’a pas bougé pour LLaMA 3.2. Meta renvoie la question de la disponibilité de l’outil dans l’Union européenne à une page dédiée, qui prend ici la forme d’une lettre ouverte / pétition titrée « L’Europe a besoin de certitude réglementaire en matière d’IA ». L’URL aussi est sans équivoque, avec un domaine indiquant que « l’Europe a besoin d’IA ».

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !