Faudra-t-il aussi construire des intelligences artificielles loin des hommes, à l’image de ce que cherchent à faire des internautes avec le web ? C’est l’une des questions qui pourraient se poser après avoir lu le récit partagé sur X (ex-Twitter) par Elizabeth Laraki, une conférencière américaine spécialisée dans les sujets liés à l’IA et à l’expérience utilisateur (UX).

Dans son message publié le 15 octobre sur le réseau social, elle raconte une expérience surprenante à laquelle elle a été confrontée. La photo qu’elle a fournie pour la promotion à venir d’une conférence à laquelle elle doit participer a été retravaillée par une intelligence artificielle générative, et par ailleurs légèrement sexualisée au passage.

Un chemisier davantage ouvert

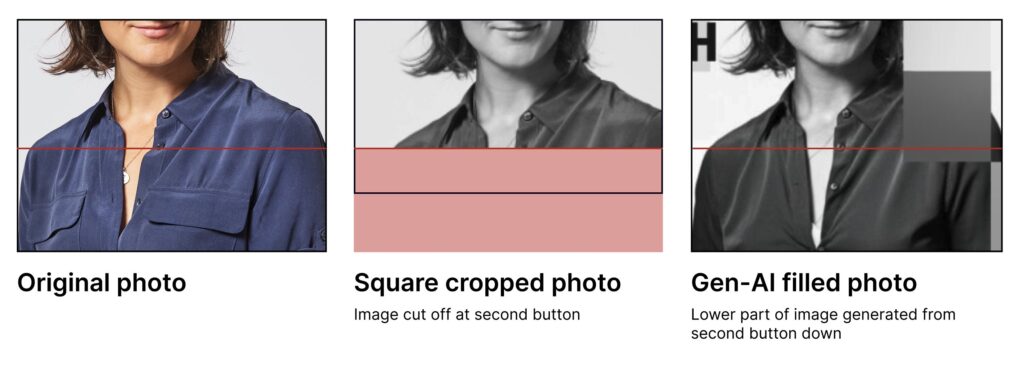

Dans le cliché initial, la conférencière porte un chemisier bleu entrouvert au niveau du col, qui permet de mettre en valeur un pendentif. Mais l’image a été retravaillée par l’IA (le type de service utilisé n’a pas été mentionné), le chemisier a été déboutonné davantage, afin de faire apparaître légèrement un bout de soutien-gorge, ou de dessous.

Une décision de la part de l’organisation de la conférence pour jouer sur le sex-appeal des participantes ? Il apparaît, selon l’explication d’Elizabeth Laraki, que c’est plutôt un résultat involontaire, conséquence d’une série de quelques maladresses dans le processus destiné à faire la promotion de l’événement. Un enchainement qu’elle raconte dans son tweet.

D’après les investigations de l’organisateur, que relaie Elizabeth Laraki, la personne chargée de la communication sur leurs réseaux sociaux « a utilisé une image recadrée [de la conférencière, NDLR] depuis leur site web. Elle avait besoin qu’elle soit plus verticale, donc elle a utilisé un outil d’extension d’image pour la rendre plus grande », dit-elle.

L’intelligence artificielle générative a ensuite « inventé la partie inférieure de l’image (dans laquelle elle estime que les chemises des femmes devraient être déboutonnées davantage, avec une certaine tension au niveau des boutons, et révéler un petit soupçon de quelque chose en dessous) ». Un sous-vêtement qui n’existe pas sur la vraie photo.

Dans la fausse image qu’elle donne, la présence du soutien-gorge est discrète, suffisamment en tout cas pour parvenir à tromper la vigilance de la personne qui s’est chargée d’ajuster la photo pour les réseaux sociaux. Cela étant, la bonne nouvelle, c’est que les choses sont vite rentrées dans l’ordre : la fausse photo a été supprimée et des excuses ont été faites.

Suiviez l’actualité de l’IA avec la newsletter de Numerama

La question des données d’entraînement

Cette histoire, qui relève de l’anecdote, soulève cependant une problématique technique. Toute intelligence artificielle générative se construit en fonction des données d’entraînement qu’on lui donne. Pour entraîner une IA à reconnaître un chat, la méthode courante en apprentissage profond (deep learning) consiste à exposer le modèle à d’autres images de chats.

Dès lors, l’affaire relatée par Elizabeth Laraki amène à s’interroger sur le corpus de données qui a permis de former le modèle utilisé par la personne ; plus largement, cela conduit également à poser la question de la façon dont les femmes sont représentées, ou se représentent sur Internet, si le service qui a formé le modèle a pioché librement des clichés en ligne.

Ce sont des enjeux loin d’être nouveaux. Ils ont d’ailleurs été posés dans d’autres circonstances. En 2018, par exemple, une étude menée dans le cadre du MIT a souligné que certains algorithmes étaient trop formés via des photos d’hommes blancs, ce qui les rendait moins efficaces pour des personnes à la couleur de peau différente.

Selon le contenu du corpus utilisé pour entraîner une IA, il y a un risque de reproduire, via le système, des biais et des stéréotypes. Un sujet qui n’est à ce stade pas complètement résolu, en témoigne ce récit, et qui concerne aussi le texte : en 2023, la manière dont a été formée ChatGPT avait été au cœur d’un débat politique en France.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !