Un Siri capable de répondre à des questions compliquées, un appareil photo qui peut reconnaître ce qu’il voit ou un outil pour vérifier son orthographe ? Sur le papier, Apple Intelligence offre plusieurs fonctions bien pratiques. L’arrivée d’iOS 18.2, une mise à jour qui intègre ChatGPT à l’iPhone, rend la suite de fonctions IA d’Apple plus intéressante que jamais.

En France, Apple Intelligence n’arrivera qu’en avril 2025, probablement avec quelques fonctions en moins (Apple n’est pas très explicite, mais on peut imaginer que Siri restera moins performant en français). Il est possible de tricher pour l’utiliser depuis l’Union européenne sans attendre, mais on perd alors accès à ses comptes App Store, Apple Music, Apple TV+ et Apple Fitness+ français. Une concession frustrante, qui empêche la majorité des Européens de profiter de cette grande nouveauté Apple.

Durant un déplacement de quelques jours à New York, Numerama s’est donné pour défi d’utiliser Apple Intelligence pour toutes ses requêtes, afin de tester au mieux le service d’Apple. Une expérience mitigée, qui trahit un retard technologique qu’il faudra plusieurs mois pour rattraper.

Apple Intelligence s’active automatiquement à la descente de l’avion

Première observation : le dispositif de verrouillage d’Apple Intelligence dans l’Union européenne est très bien conçu.

En France et dans l’avion, l’iPhone indiquait que le service n’était « pas disponible dans notre région ». Quelques secondes après notre atterrissage aux États-Unis, le service devient soudainement disponible. Au-delà de la localisation GPS, qu’il est possible de tromper avec le bon matériel, Apple semble s’appuyer sur les antennes relais, afin de limiter son service aux États-Unis. Aucune marque ne va aussi loin, un VPN suffit généralement à tromper un géo-verrouillage.

Autre constat étonnant : Apple Intelligence est un service qui s’active, même s’il modifie drastiquement plusieurs aspects d’iOS. C’est, à notre connaissance, la première fois qu’Apple propose deux expériences utilisateur différentes au sein d’un même système d’exploitation. À moyen terme, on imagine mal Apple Intelligence rester une option à activer manuellement. Le service s’accompagne d’ailleurs d’un téléchargement obligatoire de 3,18 Go dans iOS 18.2, que l’on imagine un jour intégré à l’OS.

Siri, ChatGPT, Visual Intelligence… Pourquoi aussi peu de clarté ?

Siri est toujours dans les choux

Une fois Apple Intelligence activé, l’utilisateur a le droit à un minitutoriel. On lui présente notamment le nouveau Siri (avec une animation colorée et un système pour poser une question écrite), ainsi que le résumé des notifications. Apple Intelligence ne s’active pas forcément du premier coup une fois la coche activée, mais un redémarrage suffit à le débloquer. Dans les réglages, il est aussi possible d’activer ChatGPT manuellement, pour autoriser Siri à aller demander de l’aide aux serveurs d’OpenAI quand il n’a pas une réponse. Par défaut, Siri se contente de Siri.

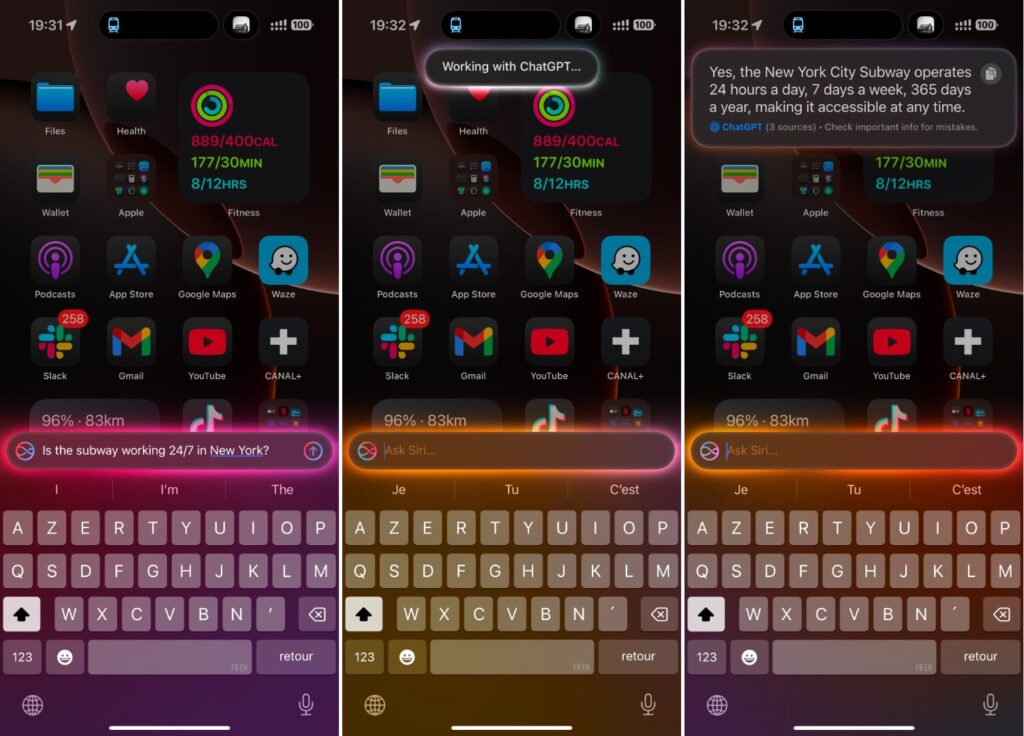

Que vaut le nouveau Siri ? Techniquement parlant, sa seule nouveauté est de pouvoir gérer de longues questions, là où la précédente version aurait répondu un simple « je n’ai pas compris ». Le nouveau Siri peut comprendre ce que vous voulez dire quand vous formulez mal votre demande, puis prendre la décision d’y répondre avec sa propre base de données… ou d’aller interroger ChatGPT.

C’est justement sur cet aspect qu’Apple nous semble faire fausse route. Souvent, et pour une raison qui nous dépasse, Siri préfère répondre qu’il n’a pas la réponse à une question, plutôt que d’interroger ChatGPT rapidement. Il faut alors lui demander manuellement la même chose en commençant par « Ask ChatGPT », afin d’avoir une réponse complète.

Dans d’autres cas, Siri prend l’initiative de demander à ChatGPT des choses simples comme « combien de temps pour aller à un tel endroit ». Problème : ChatGPT ne dispose pas de la localisation de l’utilisateur, il ne peut donc pas répondre. L’exemple ci-dessous porté sur le temps de marche pour atteindre la boutique Nintendo World, mais Siri a envoyé la question à ChatGPT, qui nous a fait une réponse générique.

Dans la rue, nous avons souvent essayé de déclencher Siri avec nos AirPods pour lui poser une question sur un monument. Quasiment à chaque fois, il n’a pas compris la question et n’a pas interrogé ChatGPT. Il faut spécifier manuellement le « Ask ChatGPT » pour avoir une réponse, mais le système perd alors en intérêt. Pourquoi utiliser Siri quand l’application ChatGPT existe, avec un mode voix à des années-lumière de celui d’Apple ?

Exemple concret : « quel est le nom de l’endroit avec le carrousel et la belle vue dans New York ? ». ChatGPT Voice répond le « Jane Carrousel » et suggère des beaux endroits pour prendre la photo, Siri récite la définition Wikipedia de Central Park.

Visual Intelligence, une interface réussie

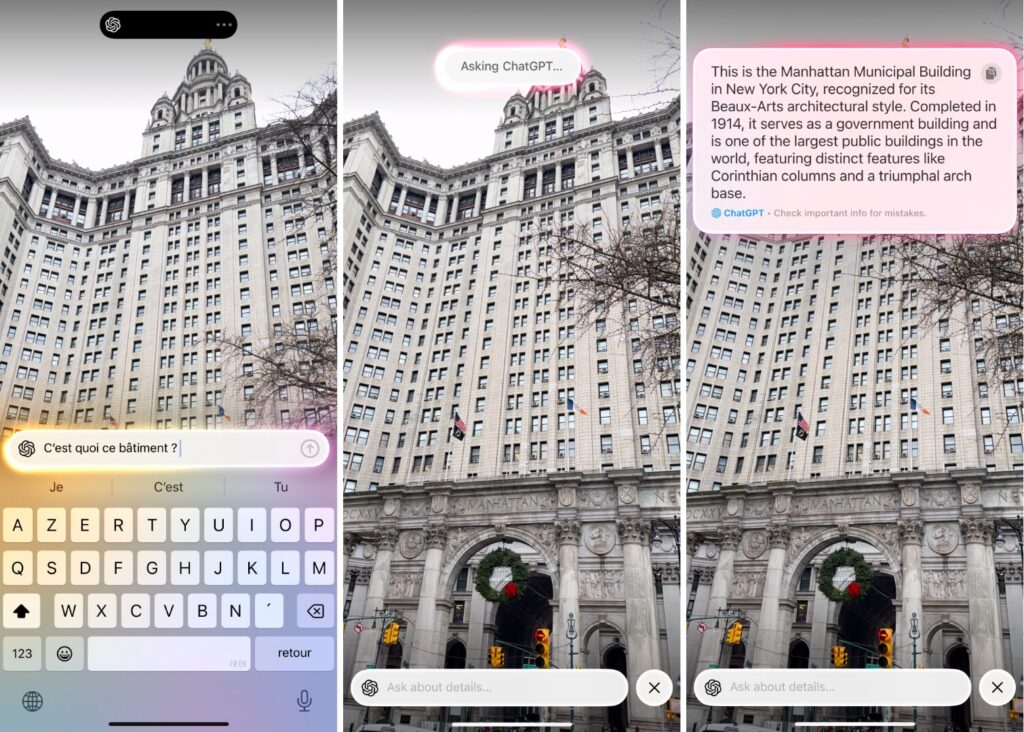

Autre système basé en partie sur ChatGPT : Visual Intelligence. Il s’agit d’une application exclusive à l’iPhone 16 (ce qui est incompréhensible), puisqu’on ne peut l’ouvrir qu’avec le bouton Camera Control. À l’intérieur, on trouve un appareil photo dopé à l’IA. On peut prendre une photo pour traduire du texte, le résumer, faire une comparaison Google Lens ou poser une question à ChatGPT.

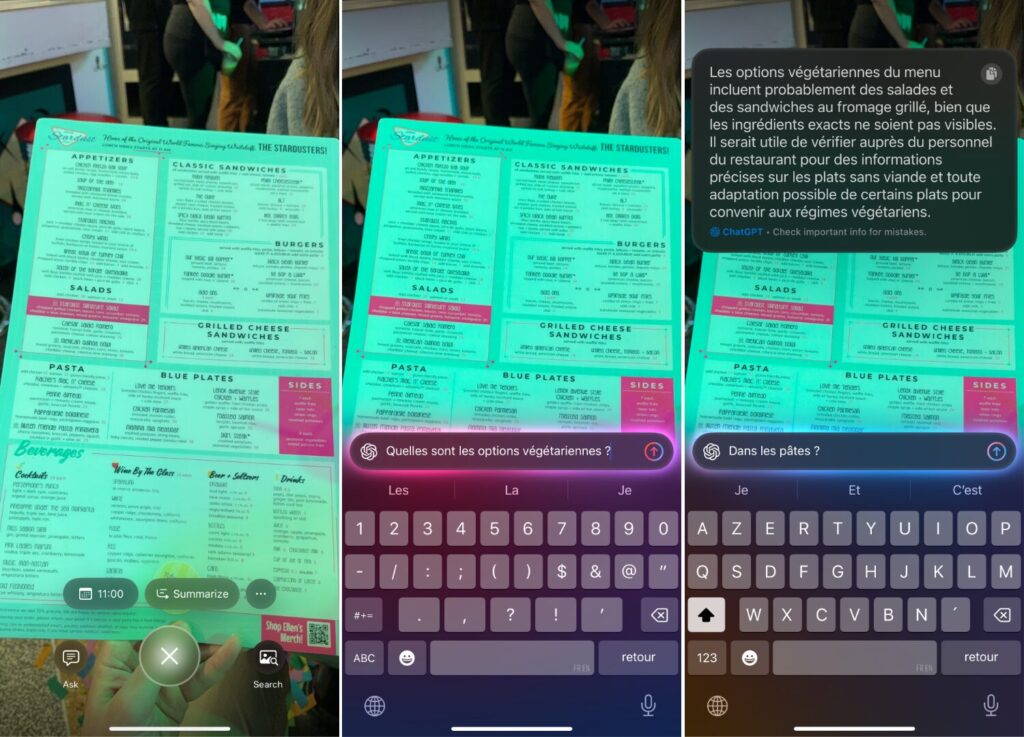

Visual Intelligence a un défaut : il est extrêmement sensible au tactile. Un toucher accidentel au milieu de l’écran réinitialise la conversation et force à tout recommencer. Autrement, c’est une des meilleures fonctionnalités d’Apple Intelligence. Pouvoir prendre en photo une statue puis demander à ChatGPT ce qu’elle représente est génial, interroger un menu dans une langue étrangère pour trouver les plats végétariens est encore mieux.

Pour améliorer Visual Intelligence, Apple pourrait faire trois choses :

- Permettre l’importation de photos existantes, ce n’est pas possible aujourd’hui.

- Permettre de scanner une capture d’écran, comme sur Android avec Entourer pour rechercher.

- Le lancer sous la forme d’une vraie application, pour que tous les appareils iOS et iPadOS en disposent.

À ces quelques détails près, le service est à la hauteur des promesses. Dommage qu’Apple n’exploite aucun modèle développé en interne, mais ChatGPT fait le job. Autre bonus : ChatGPT parle déjà français, on peut donc poser des questions dans la langue de Molière.

Reste néanmoins une problématique majeure : quel est l’intérêt d’un service intégré quand l’application ChatGPT (ou Google Lens) font la même chose ?

Apple devrait fusionner Apple Intelligence en une seule interface

Le problème d’Apple Intelligence dans cette V1 est simple : Apple n’assume pas encore son virage dans l’ère de l’intelligence artificielle.

Selon nous, il n’est pas normal d’avoir aujourd’hui plusieurs interfaces pour poser des questions à son iPhone. Siri (vocal et texte), Spotlight (recherche locale), Visual Intelligence (image), Look Up (analyse des photos)… Tous ces systèmes devraient fusionner en un, pourquoi pas sous l’appellation Siri. On aimerait pouvoir envoyer une capture d’écran à Siri pour lui demander de répondre à une question, ou dire vocalement à Siri « prends-une photo et dis moi ce que tu vois ». La coexistence de différentes fonctions complique l’expérience, là où une application comme ChatGPT est capable de tout faire. La bonne nouvelle est que Siri devrait s’améliorer avec iOS 18.4 en avril, ce qui ouvre la porte à plus de multimodalité.

On aime les Genmoji et les notifications, mais le reste est perfectible

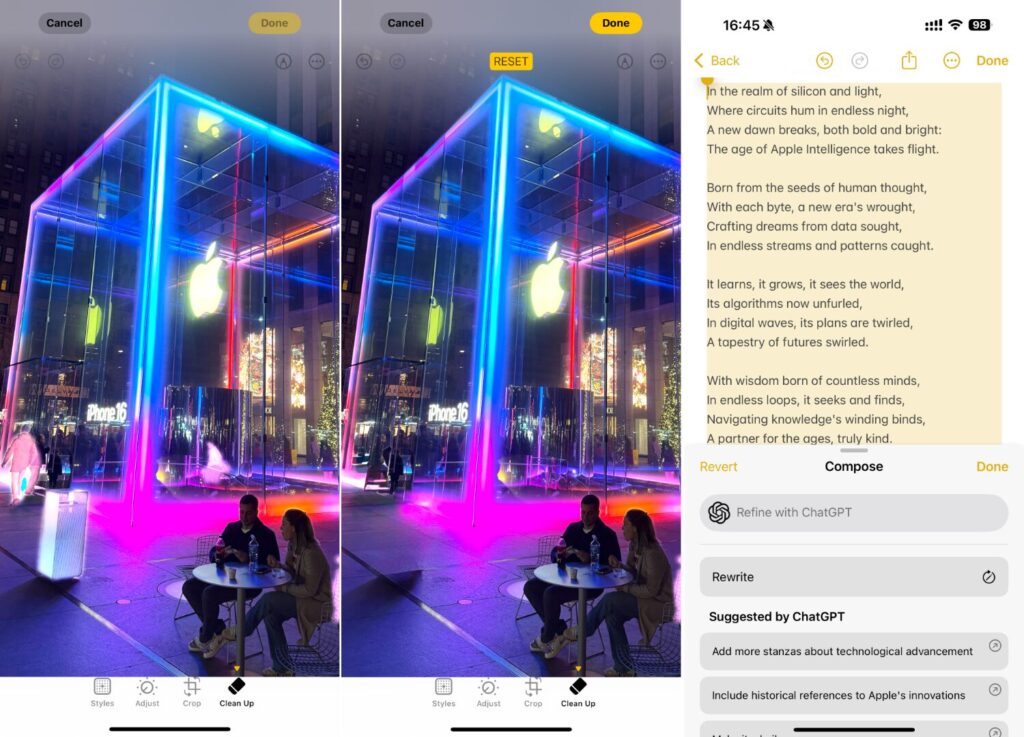

Dans son bundle Apple Intelligence, le constructeur californien inclut plein de services. Parmi eux, il y a notamment un outil pour générer des souvenirs en vidéo, une gomme magique pour supprimer un élément encombrant d’une photo, un système pour résumer un mail ou une page web, ainsi qu’un générateur de texte.

Dans ces services, seule la gomme magique est vraiment utile au quotidien, même si elle a tendance à faire de gros gribouillis quand l’élément à effacer est trop grand — décevant tant d’années après Google, pour ne citer que lui.

Les outils d’écriture sont pratiques pour vérifier l’orthographe d’un mail avant de l’envoyer, mais cette fonction est limitée à l’anglais pour l’instant. Ils permettent aussi de demander à ChatGPT de générer un texte à partir d’un prompt, ce qui peut s’avérer commode, mais, encore une fois, pourquoi passer par le système d’Apple plutôt que par l’app ChatGPT ?

La marque semble condamnée à ce raisonnement en attendant de développer ses propres modèles plus sophistiqués. En revanche, le résumé d’un texte par Apple Intelligence utilise un modèle Apple, qui fonctionne sans réseau. Les résumés sont étrangement très complets, avec des résultats très justes.

Les notifications résumées, la bonne idée d’Apple

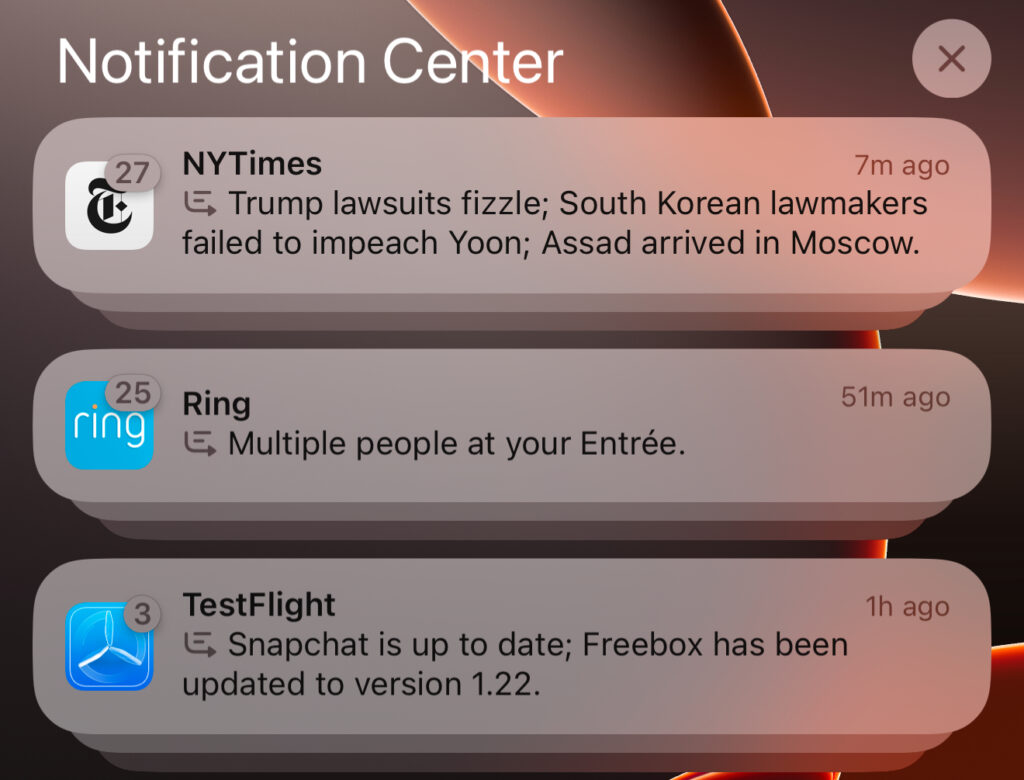

Une des fonctions les plus prometteuses d’Apple Intelligence, même si elle doit encore faire ses preuves en français, est le résumé des notifications.

Pour faire simple, il s’agit d’un système qui lit localement vos messages et les résume dans une seule notification. L’intérêt semble évident pour les utilitaires (un « porte fermé / porte ouvert / porte fermé » deviendra « porte fermée lors de la dernière interaction »), mais reste à prouver pour les conversations perso, où l’IA n’a pas le droit à l’erreur.

Nos premiers tests montrent qu’Apple Intelligence résume parfois des notifications français par inadvertance, mais le fait souvent avec des erreurs. Exemple concret : un « merci beaucoup mon cœur » transformé en un « maman vous remercie pour votre cœur ». De quoi provoquer l’incompréhension au premier coup d’œil.

Les Genmoji, la killer feature d’Apple Intelligence

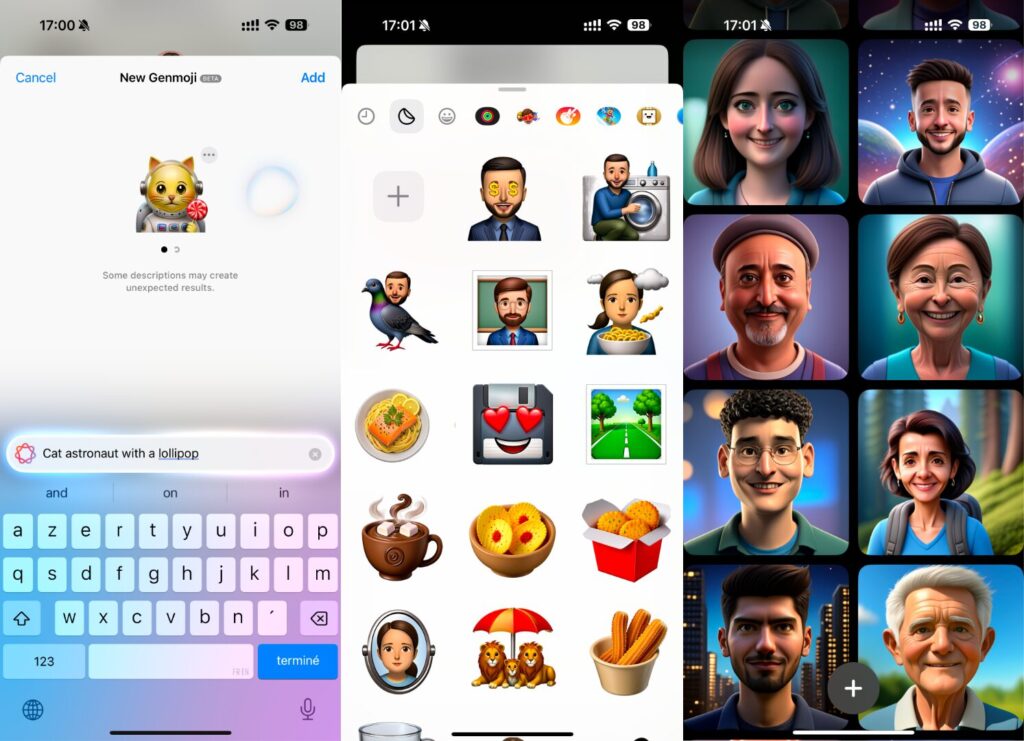

Finalement, la meilleure fonction d’Apple Intelligence est peut-être la plus bête : les Genmoji.

Conscient du succès planétaire des émojis, Apple a eu l’idée d’entraîner un modèle de diffusion pour générer, localement, de petites émoticônes sur mesure. Les requêtes problématiques sont bloquées, mais on peut quasiment tout fabriquer avec les bons mots. Les résultats sont fréquemment hilarants et aident à personnaliser ses conversations. C’est, de loin, la fonction que l’on utilise le plus avec iOS 18.2 et Apple Intelligence activé. Bonus : tout le monde peut enregistrer un Genmoji, même sans Apple Intelligence activé. Ils deviennent des stickers.

Dans le même genre, Apple propose avec l’application Image Playgrounds un générateur d’images amusant, qui reproduit le visage de ses proches en version animé. C’est extrêmement fun dès qu’on l’ouvre (on peut vraiment passer des heures à jouer avec), mais absolument inutile au quotidien.

L’enjeu principal pour Apple est là : au-delà de rattraper son retard sur OpenAI, Google ou Perplexity, le géant californien doit trouver un moyen de rendre l’intelligence artificielle utile. Il a plein de bonnes idées aujourd’hui, mais aucune ne transforme radicalement l’iPhone. iOS 19, iOS 20 et les futures mises à jour devront résoudre ce problème.

Les abonnés Numerama+ offrent les ressources nécessaires à la production d’une information de qualité et permettent à Numerama de rester gratuit.

Zéro publicité, fonctions avancées de lecture, articles résumés par l’I.A, contenus exclusifs et plus encore. Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !