Fondée en 2023, l’entreprise chinoise DeepSeek fait énormément parler d’elle depuis la fin du mois de décembre et la publication du modèle DeepSeek-V3, présenté comme un GPT-4o beaucoup moins cher et tout aussi performant. L’exploit de DeepSeek est d’avoir entraîné des modèles sophistiqués avec relativement peu d’argent (5,6 millions de dollars, contre plusieurs centaines de millions aux États-Unis) et du matériel considéré « ancien », le tout en open source et avec des API bien plus abordables que chez Google ou OpenAI.

Le 20 janvier 2025, un mois après V3, DeepSeek a publié son nouveau modèle d’avant-garde : DeepSeek-R1. L’entreprise chinoise attaque cette fois-ci o1, la version la plus performante de ChatGPT, qu’OpenAI présente comme « capable de réfléchir ». L’emballement est tel qu’il a permis à DeepSeek de détrôner ChatGPT sur l’App Store.

DeepSeek-R1 : un modèle qui simule une réflexion humaine pour 27 fois moins cher que ChatGPT-o1

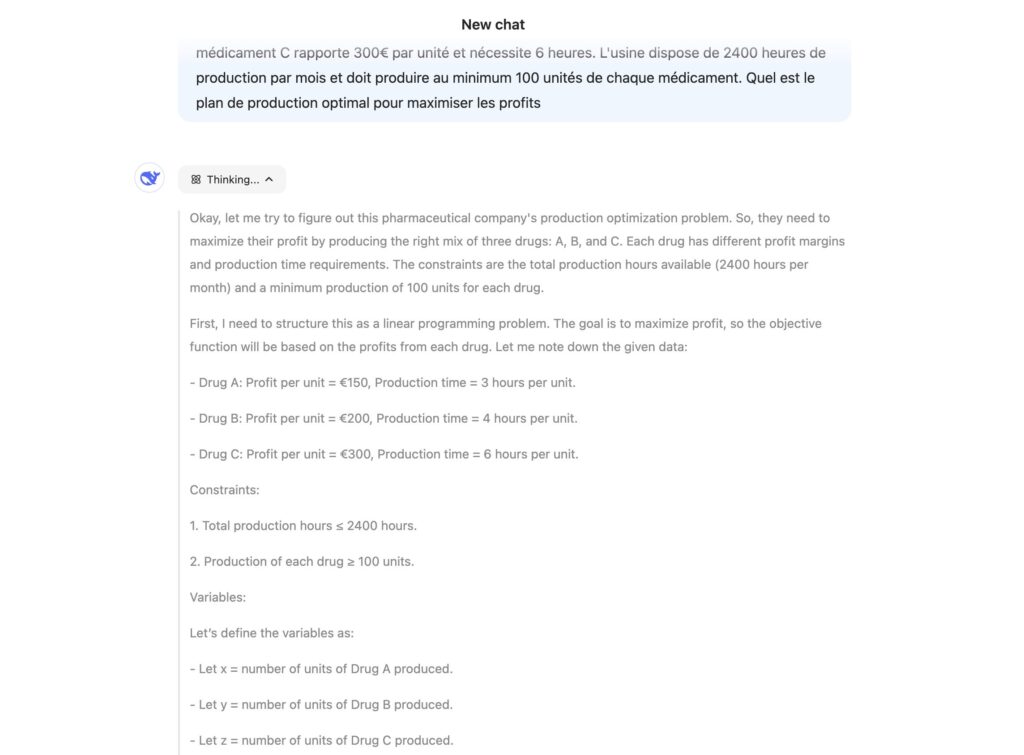

Comme OpenAI o1, DeepSeek-R1 peut s’auto-interroger afin de proposer un raisonnement cohérent, pour proposer la meilleure réponse possible. Ses « réflexions » apparaissent à l’écran, ce qui permet à l’utilisateur de comprendre le fonctionnement de l’IA de manière transparente. Le modèle principal dispose de 671 milliards de paramètres, mais en active 37 milliards par passage (une architecture appelée « Mixture-of-Experts », qui permet à DeepSeek de consommer très peu de ressources). Il supporte jusqu’à 128k tokens par demande, contre 200k chez OpenAI.

Ce modèle open source, qui s’inspire lui-même du travail d’autres chercheurs (Meta AI notamment), est optimisé pour des problèmes compliqués, qui impliquent plusieurs hypothèses. Il excelle particulièrement en mathématiques et dans la génération de code, deux domaines sur lesquels les LLM classiques font souvent des erreurs. Une de ses particularités est de pouvoir s’auto-entraîner, ce qui réduit les coûts de développement.

Comme chez OpenAI, qui décline son modèle de réflexion en deux versions (o1 et o1-mini), DeepSeek propose plusieurs versions de R1, avec entre 1,5 milliard et 70 milliards de paramètres. Le moins sophistiqué coûte moins cher par utilisation, mais se trompe aussi plus souvent. L’intérêt est de pouvoir les faire tourner sur des ordinateurs simples, sans configuration graphique spécifique.

Selon des tests publiés par DeepSeek, le modèle R1 avec 32 milliards de paramètres est équivalent à o1-mini, pour beaucoup moins cher. En dessous, DeepSeek propose des services introuvables pour l’instant chez OpenAI, avec des modèles nettement supérieurs à GPT-4o, mais capables d’aller plus loin.

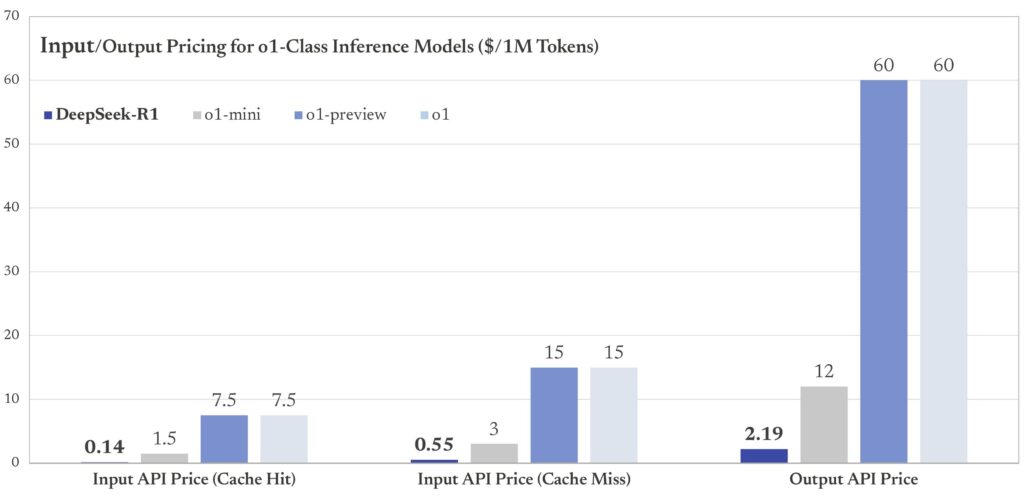

Toujours selon DeepSeek, l’utilisation de l’API DeepSeek-R1, qui permet aux développeurs d’intégrer l’IA à leur propre service (la SNCF pourrait, par exemple, lancer un chatbot qui utilise le modèle chinois), coûte 2,19 dollars par million de tokens. En comparaison, o1-mini coûte 12 dollars pour la même utilisation (mais de moins bons résultats), quand o1 dépasse 60 dollars pour une « réflexion » équivalent. DeepSeek proposerait donc un service considéré équivalent pour 27 fois moins d’argent.

Difficile de faire plus humiliant, d’autant plus que DeepSeek-R1 aurait coûté relativement peu à l’entrainement, avec une approche open source aux antipodes des visions fermées d’OpenAI et Google.

Quid de la rapidité des réponses ? Elle est logiquement assez moyenne pour les questions les plus complexes, puisque DeepSeek-R1 simule une réflexion pendant plusieurs minutes avant de répondre. Mais le modèle peut aller très vite quand la question est simple.

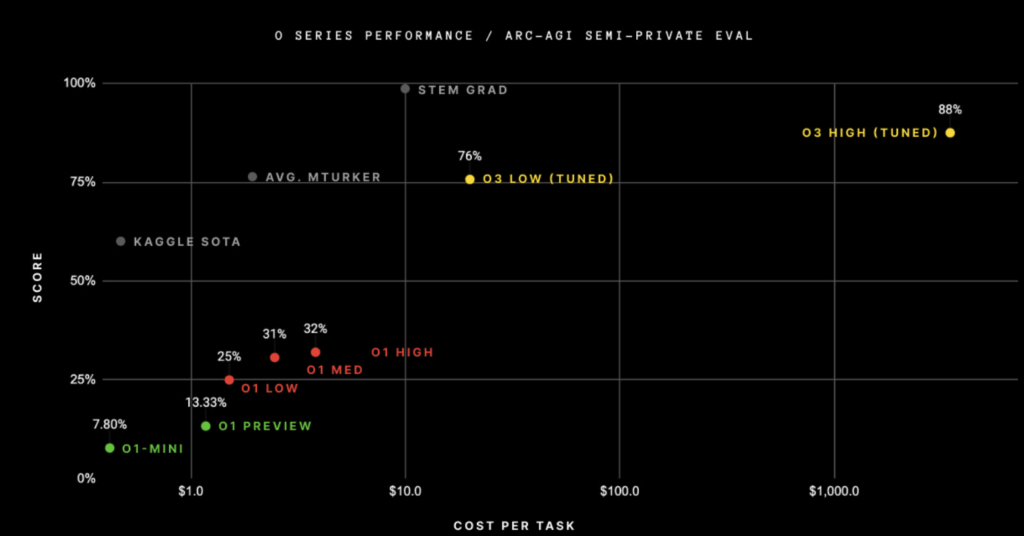

OpenAI-o3 : la réponse à DeepSeek arrive, mais les coûts vont s’envoler

Plus tard en 2025, OpenAI lancera o3 et plusieurs versions d’o3-mini. Ces modèles devraient, sauf surprise, dépasser largement DeepSeek-R1. La génération d’une réponse pourrait coûter plusieurs milliers d’euros à OpenAI dans la version la plus performante de l’IA, que l’entreprise présente comme le modèle le plus sophistiqué de l’histoire. o3 est capable de réflexions très poussées.

La supériorité technique d’o3 sur DeepSeek-R1 ne fait quasiment aucun doute, mais le coût de son utilisation interroge sur l’approche choisie par OpenAI et les autres géants américains. Tous misent sur des centaines de milliards de dollars d’investissement, quand la Chine, avec un « petit » projet open source, arrive à faire aussi bien en cassant les prix. DeepSeek pourrait provoquer un changement de philosophie aux États-Unis en mettant l’efficacité et le coût au cœur du développement des futurs grands modèles.

Les abonnés Numerama+ offrent les ressources nécessaires à la production d’une information de qualité et permettent à Numerama de rester gratuit.

Zéro publicité, fonctions avancées de lecture, articles résumés par l’I.A, contenus exclusifs et plus encore. Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !