Avec son nouveau modèle DeepSeek-R1, la Chine a provoqué un séisme technologique. Les actions des principales grandes entreprises de la tech aux États-Unis se sont effondrées, puisque le modèle de DeepSeek est aussi performant que ChatGPT-o1… mais 27 fois plus économe. Toute la course à la puissance des États-Unis est remise en question, d’autant plus que les travaux du groupe chinois sont open source et peuvent être repris par n’importe qui.

Avant DeepSeek, une autre entreprise faisait beaucoup parler d’elle pour ses modèles open source : Mistral AI. La startup française, que beaucoup ont tendance à oublier, utilise la même architecture (MoE, mixture-of-experts) que DeepSeek, qui lui permet d’entraîner des modèles à des tâches spécifiques. Quelques jours après la frénésie DeepSeek, Mistral vient de faire son grand retour en publiant un nouveau modèle en torrent : Mistral Small 3, qui pèse 47,16 Go. L’annonce a été faite via X le 30 janvier.

Mistral Small 3 n’est pas un concurrent de DeepSeek-R1, mais rappelle qu’il ne faut pas enterrer Mistral

Avec 24 milliards de paramètres, le modèle Mistral Small 3, comme son nom l’indique, est un petit modèle. Mistral AI ne sort pas un rival de DeepSeek-R1 et ses 671 milliards de paramètres (dont 37 milliards actifs), mais un grand modèle de langage (LLM) entraîné pour des tâches précises, compatible avec une exécution locale. L’entreprise met en avant une vitesse de 150 tokens par seconde, qui pourrait permettre à Mistral Small 3 d’être extrêmement efficace pour des tâches prédéfinies. Le LLM dispose d’une licence Apache 2.0 : n’importe qui peut récupérer son code.

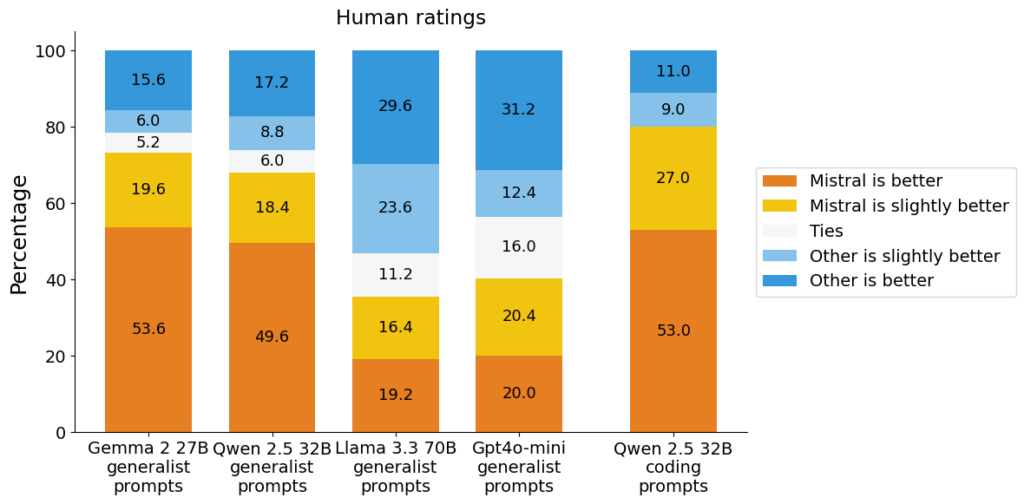

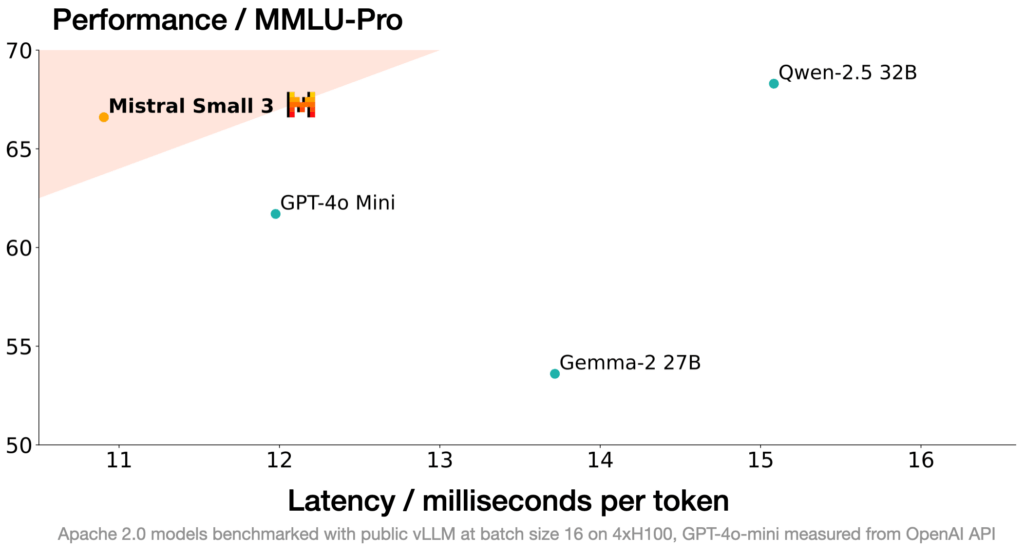

Selon les tests de performance effectués par Mistral, le modèle Small 3 est très efficace malgré sa petite taille. Il obtient de très bons résultats dans de nombreux benchmarks, souvent supérieurs à d’autres petits modèles comme Gemma 2, Qwen 2.5 ou GPT-4o-mini. Mistral AI avance qu’il se positionne au niveau de LLaMA 3.3 70B, le modèle open source de Meta avec 70 milliards de paramètres. Son exploit ici est que son modèle, avec 24 milliards de paramètres, est beaucoup plus petit.

Une des forces de Mistral Small 3 est qu’il peut fonctionner en local sur des machines relativement standards, comme un MacBook avec 32 Go de RAM ou un PC avec une carte graphique Nvidia RTX 4090. Mistral souhaite s’adresser à différents secteurs privés en quête d’une IA respectueuse des données confidentielles, capables de fonctionner en local et économe. C’est sur cet aspect qu’il s’aligne à DeepSeek, puisque son IA consomme bien moins que celles d’OpenAI ou de Google, le tout localement.

Pour Mistral, l’objectif principal aujourd’hui ne semble pas de proposer le modèle plus performant, mais le plus rapide et le moins consommateur en ressources. C’est ici que Small 3 marque un tournant pour l’entreprise, qui espère pouvoir proposer une alternative européenne, en l’espcèe française, aux grands groupes américains et chinois.

À la fin de son communiqué, Mistral présente Small 3 comme un « complément des grands modèles open source de raisonnement comme les dernières sorties de DeepSeek ». Cette sortie fin janvier n’est sans doute pas une coïncidence : Mistral AI veut récupérer sa place de référence de l’open source.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !