Perplexity n’est pas vraiment un rival d’OpenAI, de Google ou de Mistral, puisqu’il ne fabrique pas lui-même ses propres modèles de langage. La startup américaine, qui se présente comme un moteur de recherche de nouvelle génération, a mis au point un outil qui convertit vos recherches en des prompts sophistiqués, collecte de nombreuses sources, puis les envoie à un LLM concurrent, comme GPT-4o (OpenAI), Claude-3.5 (Anthropic) ou R1 (DeepSeek) pour générer une réponse. Sa mission est de simplifier la recherche, pas de générer du texte.

Même si Perplexity ne crée pas de LLM, l’entreprise a mis au point Sonar, un modèle entraîné en interne pour donner des réponses plus rapidement. Sonar est basé sur le modèle open source de Meta, Llama, avec un post-entraînement pour fournir des réponses complètes et simples à comprendre. Sa dernière version, annoncée le 11 février 2025, bat un record de vitesse pour un modèle de langage.

Le nouveau Sonar flashé à 1 200 tokens par seconde

La nouvelle version de Sonar se base sur Llama 3.3 avec 70 milliards de paramètres, un des derniers modèles de Meta. Sonar n’est pas un modèle conçu pour des tâches compliquées, puisqu’il rivalise plutôt avec GPT-4o-mini et Claude 3.5 Haiku, de petits modèles à bas coût conçus pour des réponses rapides.

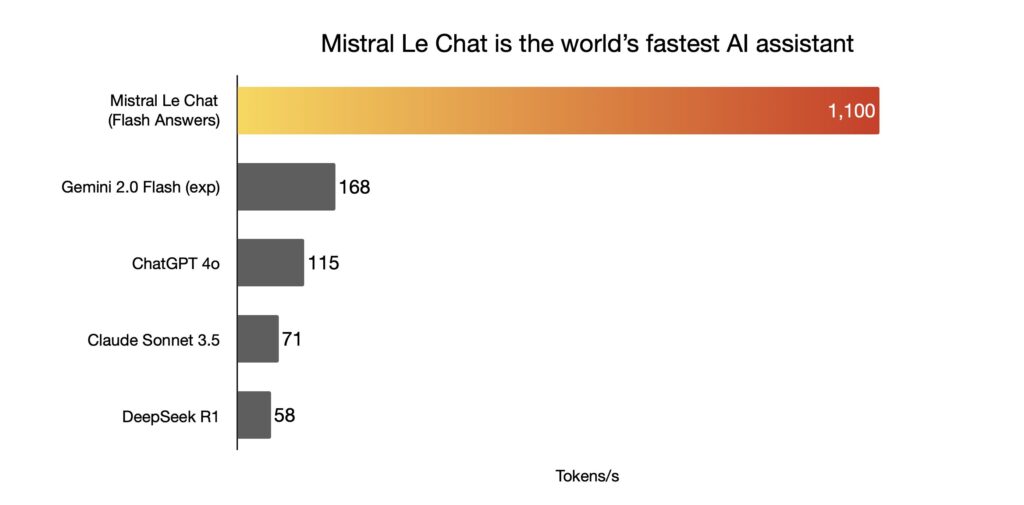

Un énième petit modèle à but précis sans intérêt ? Attendez de découvrir sa rapidité. Le nouveau Sonar de Perplexity génère des réponses à la vitesse folle de 1 200 tokens par seconde (un token correspond globalement à un mot généré), un nouveau record dans l’industrie. Une semaine plus tôt, le français Mistral avait annoncé un nouveau modèle à 1 100 tokens par seconde, déjà 10 fois plus rapide que ChatGPT. Cette vitesse permet à Perplexity, dans sa version standard, de générer des réponses instantanées, à la manière de Google. Il n’y a plus de temps d’attente pour générer une réponse.

Perplexity se compare à de nombreux modèles concurrents, qui plafonnent généralement autour des 100 tokens par seconde, mais oublie volontairement Mistral. C’est dommage, puisqu’il s’agit en réalité de son principal concurrent sur la vitesse.

Perplexity et Mistral ont un point commun : des puces différentes

Comment expliquer cette soudaine course à la rapidité, avec une multiplication par 10 des précédents résultats ?

Perplexity et Mistral ont un fournisseur commun : Cerebras, qui fabrique des puces avec une architecture différente de celles de Nvidia ou AMD. Sonar et Mistral-Large-2, qui tournent tous les deux sur des serveurs Cerebras, profitent d’une architecture spécialement pensée pour l’intelligence artificielle, qui va beaucoup plus vite qu’ailleurs. Le problème est que les capacités de Cerebras sont limitées : l’entreprise n’a pas (encore) les moyens de faire tourner un service utilisé par des centaines de millions de personnes. Le nouveau Sonar n’est d’ailleurs pas le modèle par défaut de Perplexity, sans doute pour cette raison.

En 2025, la rapidité pourrait devenir un des grands axes de développement des LLM. La génération mot par mot va-t-elle devenir invisible ? Perplexity et Mistral sont les premiers à s’y mettre.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !