Bien souvent, lorsqu’on parle des grands modèles de langage, ou LLM dans le jargon (de l’anglais large language model), on définit leur performance avec le nombre de tokens qu’ils peuvent utiliser. Un terme flou pour le commun des mortels, mais qui décrit ce qui est le nerf de la guerre de l’IA : la course aux systèmes les plus puissants. Pourquoi parle-t-on de tokens alors ?

Qu’est-ce qu’un token (ou jeton) dans l’IA ?

Le mot token signifie en anglais jeton, tout simplement. Lorsqu’on parle d’intelligence artificielle générative, le terme est mobilisé pour parler d’une représentation élémentaire du texte qui est donné en entrée du système. Ce sont les tokens qui permettent à ces fameux LLM de « comprendre » et de générer du langage.

Il s’agit donc de mots, de parties de mots, voire de caractères ou de signes de ponctuation. En somme, le token est unité de sens. Lorsqu’on tape une requête en entrée dans un chatbot, celui-ci découpe en quelque sorte ce texte : c’est ce qu’on appelle la tokenisation (ou tokenization en anglais). C’est ce processus qui permet aux modèles d’IA d’analyser le langage.

La tokenisation est primordiale : avec cette méthode, les LLM peuvent « comprendre » le concept de préfixes, suffixes, radicaux dans toutes les langues (on appelle ça des morphèmes). C’est aussi de cette façon qu’on leur inculque des termes techniques ou des néologismes. Ainsi, des LLM peuvent même apprendre ou créer des mots qui n’existent pas, ou du moins qui ne leur ont pas été inculqués.

Les tokens font donc l’interface entre le langage humain et le langage machine. Le fait de décomposer le texte en de petites parties permet plus facilement aux modèles de langage de l’analyser.

Comprendre le processus de tokenisation

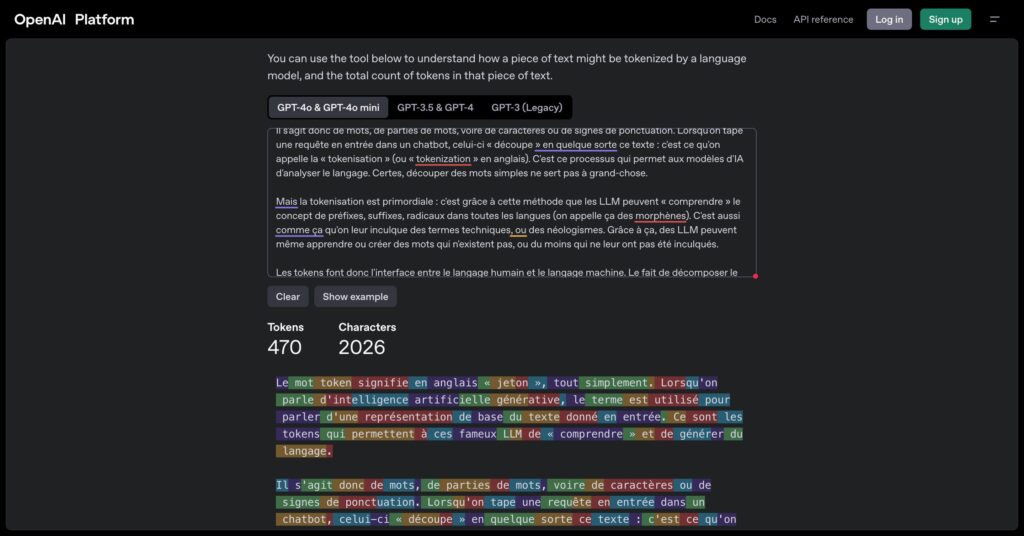

Le processus de tokenisation n’est pas le même en fonction de la langue : le découpage n’est pas le même. Par ailleurs, certains LLM peinent à tokeniser certaines langues non occidentales. Comme l’explique l’académie de Versailles, « un token correspond généralement à environ 4 caractères pour un texte en anglais courant. »

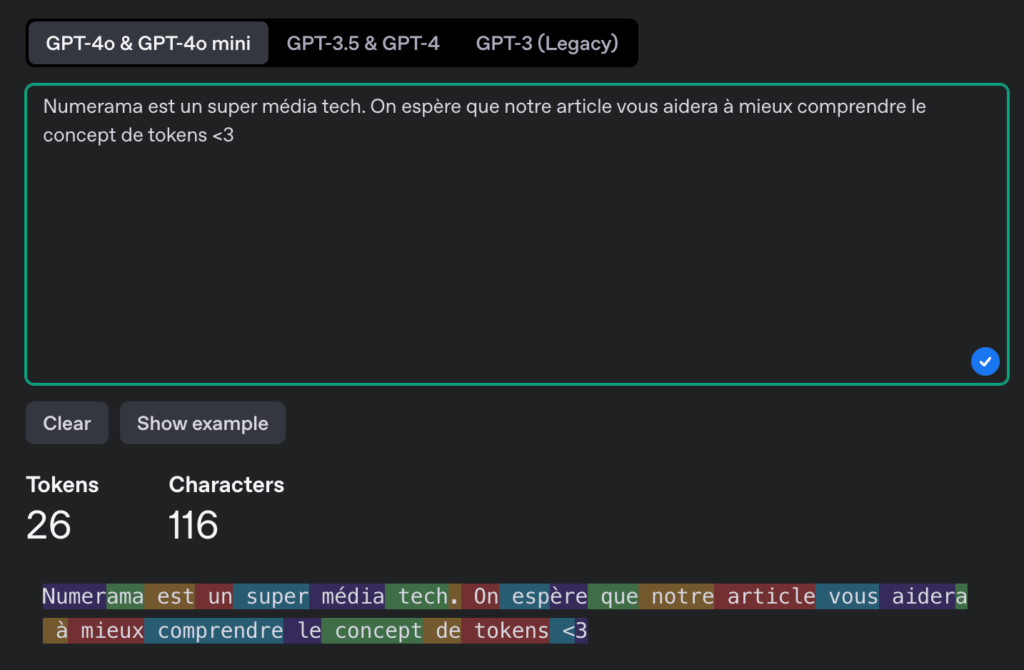

Pour s’apercevoir de la manière dont un LLM tokenise un texte, OpenAI met à disposition un outil en ligne.

Vous pouvez taper du texte dans le champ prévu à cet effet, choisir un LLM et observer combien de tokens sont nécessaires selon le nombre de caractères que vous avez tapés. Par ailleurs, l’outil montre visuellement la façon dont est découpé votre texte.

Chaque token possède un identifiant unique. Ce sont grâce à ces identifiants que le LLM crée des relations statistiques entre les tokens, pour générer de nouveaux mots.

Que se passe-t-il avec les tokens lors de l’entraînement d’une IA ?

Les LLM sont avant tout des systèmes statistiques : ils prédisent des mots les uns à la suite des autres, en se basant sur des probabilités. Si vous demandez à un ChatGPT ce que mange le chat, il vous répondra sans doute « la souris », car il y a souvent une relation entre le chat et la souris dans les kilomètres de texte ingérés par les systèmes d’IA.

On appelle ça des réseaux neuronaux probabilistes, contrairement aux réseaux neuronaux déterministes (qui produisent toujours la même sortie). Lorsqu’on entraîne une IA générative, on lui apprend tout cela, grâce à toutes les ressources qu’on lui propose en entrée. Tout Wikipédia, des livres, des pages web, etc.

Lors de cette phase, tous ces textes sont découpés, tokenisés. Alors, le LLM va apprendre des relations statistiques entre les tokens. C’est ce qui permet d’avoir des IA créatives, qui peuvent « imaginer » des textes. C’est aussi ce fonctionnement qui explique les hallucinations et autres absurdités que sortent les chatbots. La tokenisation est importante : elle permet de traduire des textes ou bien de faire de la reconnaissance vocale.

Le nombre de tokens est-il crucial pour la puissance d’une IA générative ?

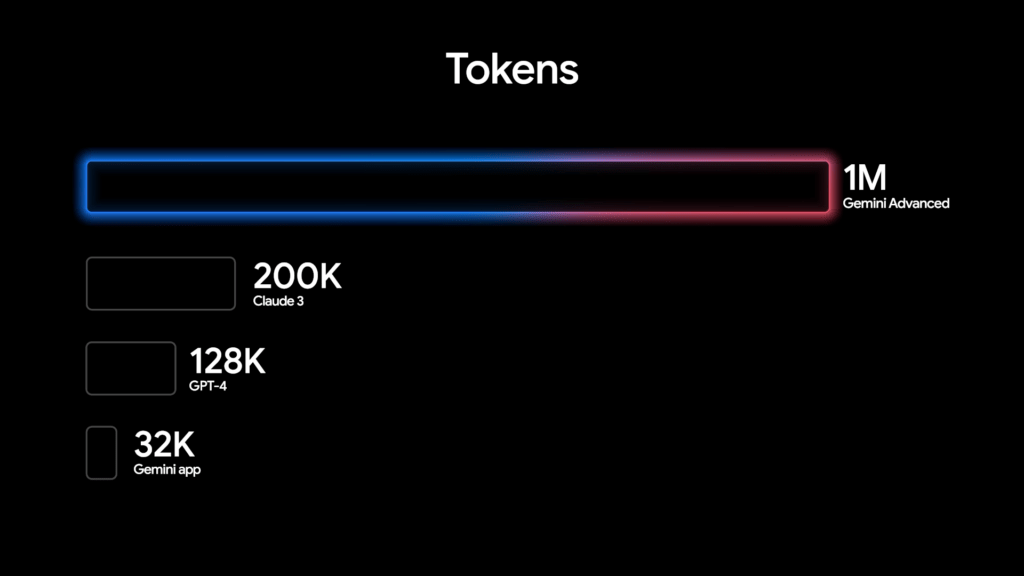

Un grand modèle de langage ne peut pas traiter en entrée et en sortie un nombre infini de tokens. Cela dépend de son architecture et de la taille de son réseau neuronal.

Voici le nombre de tokens que supportent les LLM les plus connus :

- GPT-4o : 128 000 tokens ;

- Claude 3 : 200 000 tokens ;

- LLaMA 3 : 128 000 tokens ;

- Mistral Large : 128 000 tokens ;

- Gemini 2.0 Flash : 1 000 000 tokens.

C’est bien souvent en fonction du nombre de tokens disponibles pour une requête que les éditeurs d’IA vendent leurs systèmes.

Il faut préciser que le nombre de tokens en entrée, à savoir le contexte qu’on donne à un chatbot, n’est pas le même en sortie. Les tokens en sortie sont bien moins importants que les tokens en entrée. C’est ce qui explique pourquoi il faut détailler ses requêtes, tout en étant concis, et en délimitant des étapes.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !