La compétition dans l’intelligence artificielle générative (GenAI) est avant tout une course de vitesse, dans laquelle les entreprises n’ont guère d’autre choix que de sortir régulièrement de nouveaux modèles de langage, et aussi vite que possible. Avec une contrainte particulière : chaque nouveau modèle doit bien sûr démontrer qu’il égale, voire terrasse la concurrence.

Meta, comme d’autres, a épousé cette logique. Après avoir lancé Llama (Large Language Model Meta AI) en février 2023, l’entreprise de Mark Zuckerberg a rapidement itéré. La deuxième version de son grand modèle de langage est sortie en juillet 2023, suivie d’une troisième mouture en avril 2024. Et puis Llama 4 est arrivé le 5 avril 2025.

Dans le détail, Llama 4 est décliné en trois versions :

- Llama 4 Scout : 17 milliards de paramètres actifs, 109 milliards au total (avec une architecture à 16 experts) ;

- Llama 4 Maverick : 17 milliards de paramètres actifs, 400 milliards au total (avec une architecture à 128 experts) ;

- Llama 4 Behemot : 288 milliards de paramètres actifs, 2 000 milliards au total (avec une architecture à 16 experts) ;

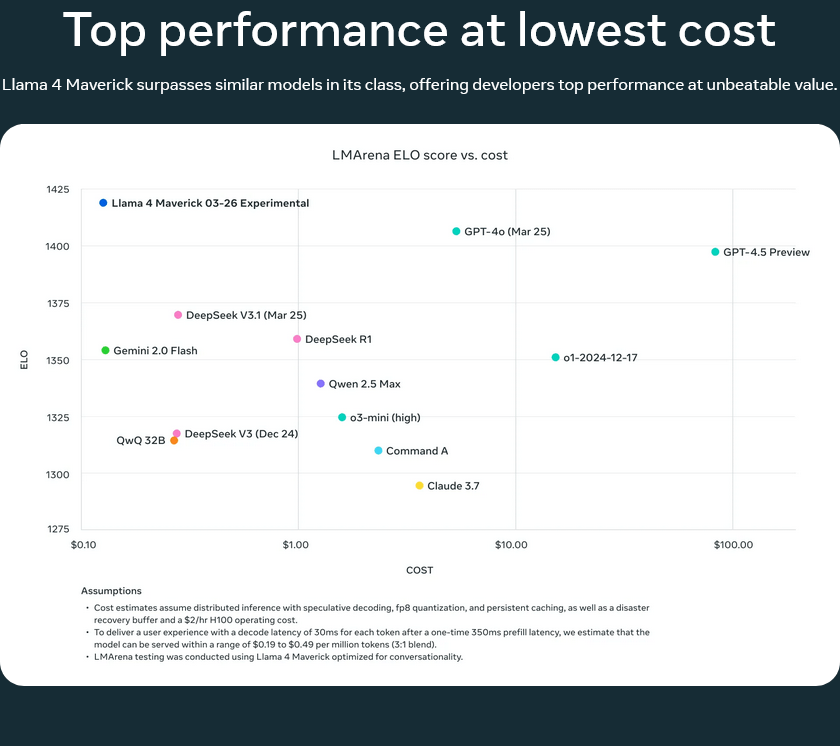

Ces trois modèles répondent à des nécessités différentes, indique Meta, qui se livre aussi au jeu des comparaisons. Ainsi, Llama 4 Maverick ferait mieux que Gemini 2.0 Flash de Google, GPT-4o d’OpenAI ou encore DeepSeek v3.1. La variante intermédiaire de Llama 4 aurait même obtenu l’un des meilleurs scores à ce jour sur le site LMArena, qui compare les modèles entre eux sur la base d’un système rappelant celui de l’ELO aux échecs.

« Llama 4 Maverick […] est le meilleur modèle multimodal de sa catégorie, battant GPT-4o et Gemini 2.0 Flash sur un large éventail de critères de référence largement diffusés, tout en obtenant des résultats comparables à ceux du nouveau DeepSeek v3 en matière de raisonnement et de codage, avec moins de la moitié des paramètres actifs », se félicite Meta.

Surtout, poursuit la maison-mère de Facebook, Instagram et WhatsApp, il « offre le meilleur rapport performance/coût de sa catégorie, avec une version expérimentale de chat obtenant un ELO de 1 417 sur LMArena ». Seule une version expérimentale de Gemini 2.5 Pro (Gemini-2.5-Pro-Exp-03-25) fait mieux, avec un ELO de 1 439.

Pas les mêmes versions de Llama 4 en jeu

Or, c’est là où le bât blesse : la version expérimentale de Llama 4 Maverick utilisée pour briller sur le tableau de LMArena n’est pas celle qui a été mise à disposition du public. La première a été « optimisée pour la conversation » et, a pointé Techcrunch dès le 6 avril, sur la base des retours des experts en IA, diffère donc de la seconde.

Cela a entraîné un début d’esclandre dans le milieu des spécialistes, qui a fini par remonter aux oreilles de l’équipe en charge de LMArena. Dans un message paru sur X (ex-Twitter) le 8 avril, pour exprimer sa désapprobation : cela « ne correspond pas à ce que nous attendons des fournisseurs de modèles langage. »

« Meta aurait dû préciser que ‘Llama-4-Maverick-03-26-Experimental’ était un modèle personnalisé visant à optimiser les préférences humaines », a continué LMArena, qui a annoncé un certain nombre de mesures « pour garantir une transparence totale », y compris la publication de nombreuses données à l’intention des spécialistes.

Par ailleurs, conclut l’équipe, ses politiques de classement vont être mises à jour « pour renforcer notre engagement en faveur d’évaluations équitables et reproductibles, afin d’éviter que ce genre de confusion ne se reproduise à l’avenir ». Le classement sur le site sera bientôt actualisé pour tenir compte de ces récents développements.

Meta prend la parole pour calmer le jeu

Inévitablement, cette affaire n’est pas sans rappeler les tentatives de gruge qui émergent ponctuellement dans le monde des smartphones. Ce milieu, qui mobilise aussi des benchmarks variés pour départager les téléphones entre eux, est pollué par certains constructeurs qui fournissent des produits optimisés, qui ne correspondent pas à ce qui est vendu.

La zone de turbulence dans laquelle s’est retrouvée Meta a même conduit Yann Le Cun, le grand patron de l’IA chez Meta, à prendre la parole, pour mettre en avant les explications additionnelles d’Ahmad Al-Dahle, qui a la responsabilité de toute la partie IA générative (dont Meta AI, le rival de ChatGPT, et Llama, entre autres).

Reconnaissant avoir entendu « des retours d’expérience faisant état d’une qualité inégale entre les différents services », l’intéressé explique que les modèles ont en fait été lancés « dès qu’ils ont été prêts », mais qu’il faut désormais à Meta « plusieurs jours pour que toutes les implémentations publiques se mettent en place » et « corriger les bugs. »

D’aucuns diraient qu’il est curieux de devoir faire encore des ajustements sur plusieurs jours pour des modèles présentés comme bons pour le service. Cela étant dit, il a tenu malgré tout à démentir les suspicions de tricherie sur Llama 4, notamment sur des entraînements basés sur des ensembles de données taillés pour les tests.

C’est « tout simplement faux », a assuré Ahmad Al-Dahle. « Nous ne ferions jamais cela. D’après ce que nous savons, la qualité variable que les gens constatent est due à la nécessité de stabiliser les implémentations », a-t-il continué. Et d’ajouter que ces nouveaux modèles « représentent une avancée significative » malgré tout.

Une crise de l’évaluation de l’IA ?

La polémique autour de Llama 4 a toutefois deux vertus : elle sonne en premier lieu comme un rappel à l’ordre pour les entreprises, qui risquent leur réputation à trop tirer sur la corde. Elle pousse aussi les plateformes comme LMArena a révisé les règles et les conditions dans lesquelles les modèles sont évalués et comparés.

Reste cependant une question sous-jacente, plus large, qui ne sera sans pas résolue immédiatement. Les benchmarks actuels pour l’IA sont-ils fiables et pertinents ? Techcrunch le disait précédemment : « LM Arena n’a jamais été la mesure la plus fiable des performances d’un modèle d’IA ». C’est pourtant lui que les firmes du secteur convoquent régulièrement pour se jauger les unes par rapport aux autres.

Plus généralement, d’aucuns considèrent qu’il y a plus généralement une crise de l’évaluation de l’intelligence artificielle, et qu’on ne sait plus trop vers quel indicateur se tourner. C’était ce que disait Andrej Karpathy, l’ex-boss de l’IA et de la conduite autonome chez Tesla, début mars : « Je ne sais pas vraiment quels indicateurs prendre en compte en ce moment. »

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !