Vous ponctuez vos prompts sur ChatGPT de sympathiques « bonjour », « s’il te plaît » et « merci », même si vous savez que vous vous adressez à un système d’intelligence artificielle ? Vos bonnes manières sont remarquables, mais elles occasionnent des coûts opérationnels significatifs pour OpenAI, la startup américaine derrière le célèbre chatbot.

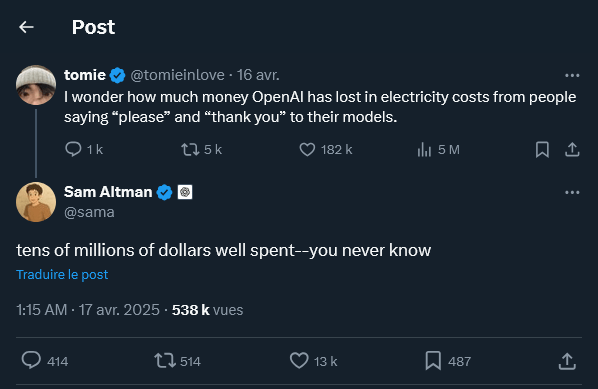

C’est Sam Altman, le patron d’OpenAI, qui a récemment abordé ce sujet, en réponse à un internaute qui s’est demandé « combien d’argent OpenAI a perdu en frais d’électricité à cause des gens qui disent ‘s’il vous plaît’ et ‘merci’ à leurs modèles ». La réponse de l’intéressé est très approximative : il chiffre la dépense des dizaines de millions de dollars.

Sam Altman donne en effet un ordre de grandeur, mais sans préciser s’il s’agit là d’un montant cumulé depuis le début de l’ouverture de ChatGPT au grand public ou d’un coût rapporté à une période — par exemple, sur toute une année, ou bien sur une fenêtre temporelle particulière. Malgré tout, à ses yeux, la facture en vaudrait la peine.

Comprendre comment fonctionne ChatGPT

Si Sam Altman n’explique pas pourquoi la politesse des internautes vis-à-vis de ChatGPT occasionne de tels frais, en consommation énergétique et en ressources informatiques, l’explication tient vraisemblablement à la façon dont un agent conversationnel fonctionne. En effet, celui-ci va analyser le prompt (« l’instruction ») de l’internaute avant de répondre.

Or, plus le message de l’internaute est long, plus le texte à analyser est long. C’est mécanique. De fait, l’ajout de formules de politesse au début et à la fin va rajouter du travail au chatbot, même si ces tournures polies ne sont pas au cœur de la requête. Pour mieux saisir cela, il faut comprendre que le prompt est découpé en séquences.

En effet, les grands modèles de langage d’OpenAI, qui indiquent à ChatGPT de quelle manière travailler, traitent le texte via un processus que l’on appelle « tokenisation ». Cela a pour effet de découper le texte en séquences, sans forcément respecter l’intégrité des mots. Les segments, ou « tokens », peuvent très bien passer au milieu d’un terme.

Un exemple ?

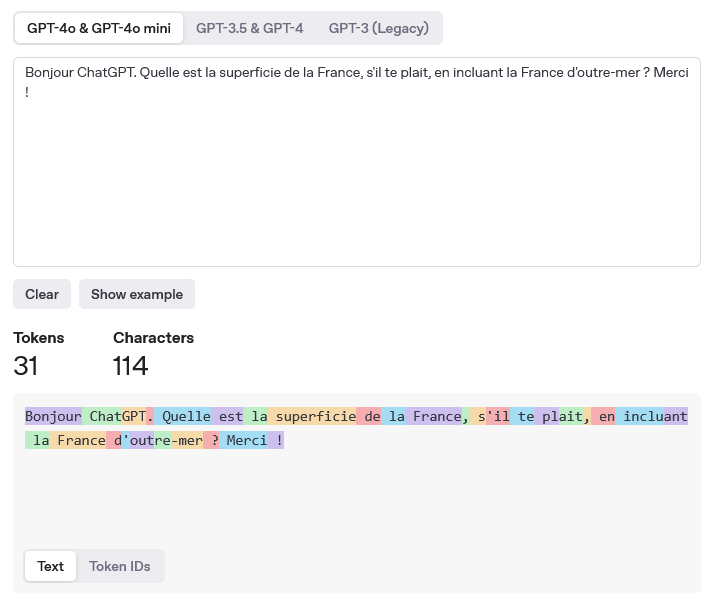

La requête suivante (« Quelle est la superficie de la France, en incluant la France d’outre-mer ? ») passée sur des modèles comme GPT-4o et GPT-4o mini compte 74 caractères et 19 tokens. Mais si on se montre poli (« Bonjour ChatGPT. Quelle est la superficie de la France, s’il te plait, en incluant la France d’outre-mer ? Merci !), on passe à 114 caractères et 31 tokens.

Il est à noter que le nombre de tokens (on dit aussi « jetons ») pour un même prompt change selon le modèle choisi. Avec GPT-3, la même phrase produit 41 tokens, mais 36 avec GPT-3.5 et GPT-4. Ce processus de conversion du texte en segments peut être testé sur une page dédiée sur le site d’OpenAI.

Or, comme le souligne l’entreprise américaine, les modèles de langage sont entraînés pour « [apprendre] à comprendre les relations statistiques entre ces tokens » et ensuite apporter une réponse. Quand ce processus rate, on dit qu’une intelligence artificielle hallucine : elle se met à raconter n’importe quoi. D’où la nécessité de toujours vérifier ce qu’elle raconte.

Un calcul infaisable, mais serait-il pertinent ?

Évidemment, le coût réel de cette politesse rapporté à chaque utilisateur est infime. Un internaute qui supprimerait tout tact dans son prompt n’aura sans doute aucun impact à son niveau. C’est à plus grande échelle que cela peut se jouer, en comptabilisant l’ensemble des internautes utilisant ChatGPT et se montrant poli.

Il est très difficile de faire une estimation du coût que cela peut représenter, car les paramètres sont très nombreux. Tout le monde ne met pas le même degré de politesse, et tout le monde n’est pas courtois avec une IA. En outre, les requêtes sont toutes différentes et la segmentation en tokens change d’un modèle à l’autre. Et tout le monde n’a pas le même degré d’utilisation.

Surtout, les dizaines de millions de dollars évoqués par Sam Altman doivent être nuancés au regard de la fréquentation de la plateforme : selon des chiffres de décembre 2024, 300 millions d’internautes utilisent le service chaque semaine, ce qui représente potentiellement 15,6 milliards de visites sur une année, si l’évaluation est stable et toujours valable. Et du côté des messages, il y en a un milliard par jour, soit 365 milliards à l’année.

Une très grossière approximation pourrait être celle-ci : supposons que le coût de la politesse représente même un milliard de dollars pour OpenAI. Si on rapporte ce montant aux 365 milliards de messages annuels, et si l’on suppose qu’ils sont tous polis, on tombe alors sur un coût par requête qui s’élève à une fraction de centime. Dérisoire.

Suivez l’actualité de l’IA avec Numerama !

Être poli a aussi des avantages

Faut-il malgré tout aller droit au but, en excluant tout le superflu de ses prompts, afin de réduire le texte et, donc, l’empreinte énergétique de ChatGPT ? En réalité, cela n’est pas forcément plus malin : la politesse est susceptible d’influencer positivement le travail du chatbot, en structurant mieux ses réponses et en le faisant mieux travailler.

D’abord, cela incitera le chatbot à répondre sur le même niveau de langue et avec la même courtoisie que vous, selon Microsoft. « L’utilisation d’un langage poli donne le ton de la réponse », indique Kurtis Beavers, un cadre de l’équipe en charge du design de Microsoft Copilot, une autre plateforme d’intelligence artificielle générative.

Au-delà d’une IA plus agréable, polie et professionnelle, la politesse aurait aussi une influence sur sa capacité à mieux travailler. C’est ce qu‘ont avancé des chercheurs de l’université Waseda et du centre de recherche sur l’IA de l’institut Riken, à Tokyo. Avec toutefois une limite : il ne faut non plus verser dans la flagornerie, cela finirait par être contreproductif.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !