Depuis plus de vingt ans maintenant, la fondation américaine Internet Archive poursuit une mission démesurée : explorer et mémoriser le web afin de « permettre à tous d’accéder au savoir, gratuitement et pour toujours ». Ainsi, chaque semaine, elle enregistre 300 millions de nouvelles pages dans sa base de données, de façon à ce que chacun puisse les consulter ultérieurement.

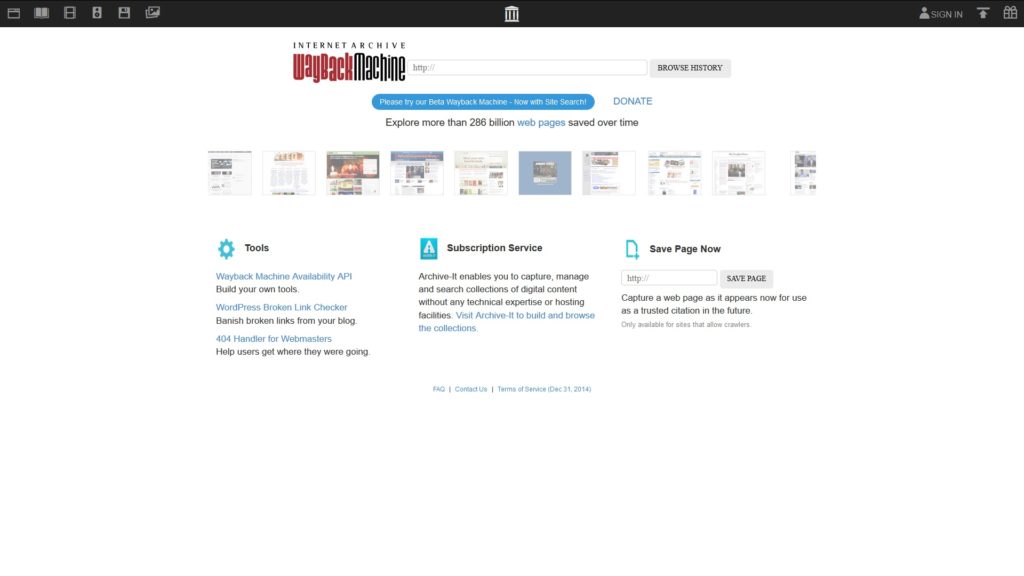

Pour consulter cette gigantesque mémoire, composée de 286 milliards de pages web, il suffit de prendre une « machine à remonter le temps ». En effet, grâce à la Wayback machine, il est possible de retrouver des pages introuvables via leur adresse d’origine. Car on a beau dire que le web n’oublie pas, il s’avère que les sites meurent aussi et que des informations finissent par disparaître.

Mais pour la fondation américaine, il y a un problème. Et ce souci s’appelle robots.txt. « Les fichiers robots.txt ont été inventés il y a plus de 20 ans afin d’aider les ‘robots’, surtout ceux des moteurs de recherche, à savoir quelles sont les sections d’un site web qui devraient être explorées et indexées pour la recherche », explique Internet Archive. Or, ce petit fichier baptisé robots.txt entrave le bon fonctionnement de son projet.

Il faut en effet comprendre que les moteurs de recherche n’indexent pas le web « à la main ». Le processus est automatisé grâce à l’emploi de logiciels, qu’on appelle robots d’indexation, qui ont pour mission d’aller de page en page pour trouver de nouveaux contenus à incorporer mais aussi de revenir sur celles précédemment analysées pour voir s’il y a du nouveau.

Robots.txt

Ces programmes passent en revue toutes les ressources qu’ils peuvent croiser en cours de route : cela va des pages web aux documents, en passant par les vidéos et les images. Il est toutefois possible de donner des consignes à ces robots : c’est là qu’entre en jeu le fichier d’exclusion « robots.txt ». En principe, les robots d’indexation le consultent avant d’entrer sur le site web avant de savoir ce qu’il faut faire ou ne pas faire.

Ce scénario, c’est lorsque tout va pour le mieux dans le meilleur des mondes. Car s’il existe des robots qui respectent effectivement les consignes figurant dans le fichier robots.txt, il y en a d’autres qui s’en moquent complètement. Et là surgit le dilemme d’Internet Archive : doit-il continuer à utiliser un robot respectueux des conventions, quitte à faire sa mission imparfaitement, ou faut-il changer son fusil d’épaule ?

Au fil du temps, nous avons observé […] une recrudescence de l’utilisation des fichiers robots.txt

« Au fil du temps, nous avons observé […] une recrudescence de l’utilisation des fichiers robots.txt pour retirer des domaines entiers des moteurs de recherche lorsqu’ils passent d’un site web actif à un nom de domaine mis en parking, ce qui a toujours conduit à la suppression, au niveau de l’aperçu de la Wayback machine, de l’ensemble du domaine », explique l’organisation.

La mise en parking d’un domaine fait référence à l’enregistrement d’un nom de domaine Internet sans que celui-ci ne soit associé à un quelconque service comme de l’e-mail ou un site web, rappelle Wikipédia. Cela a peut-être été fait en vue de réserver le nom de domaine pour un développement futur et de se protéger contre la possibilité de cybersquattage, ajoute l’encyclopédie.

Les domaines mis en parking peuvent être monétisés ou non. « Avec le parking des noms de domaine, vous pouvez gagner de l’argent grâce à des liens publicitaires thématiques qui s’affichent sur votre page de parking. Votre portefeuille grossit ainsi lors de chaque clic ! », annonce par exemple cette entreprise. Il peut donc être intéressant de récupérer d’anciens sites pour en tirer profit discrètement.

« En d’autres termes, un site cesse de fonctionner puis le domaine parqué est ‘bloqué’ des moteurs de recherche et personne ne peut regarder l’histoire de ce site dans la Wayback Machine. Nous recevons des demandes de renseignements et des plaintes sur ces sites ‘disparus’ presque tous les jours », explique l’initiative, qui se demande s’il n’est pas venu le temps de ne plus tenir compte des fichiers robots.txt.

Les premiers tests sont concluants

Un premier test a d’ores et déjà eu lieu et a donné des résultats plutôt encourageants. Assez en tout cas pour envisager une généralisation de cette approche : « il y a quelques mois, nous avons cessé de nous référer aux fichiers robots.txt sur les sites web gouvernementaux et militaires des États-Unis pour l’exploration et l’affichage des pages (bien que nous répondions aux demandes de retrait qui nous sont adressées) ».

Pour Internet Archive, la question d’un changement complet de philosophie se pose. L’archivage du web ne doit plus se faire en tenant compte des déclarations des fichiers robots.txt qui s’adressent avant tout aux moteurs de recherche. Il doit se faire en prenant en compte le point de vue de l’utilisateur, de façon à lui montrer le web tel qu’il est aujourd’hui. Et tel qu’il était autrefois.

Changement de philosophie pour le meilleur et pour le pire ?

Une décision qui peut évidemment s’entendre mais qui pourrait déplaire aux webmasters puisqu’ils perdent la possibilité de donner des directives aux robots d’indexation — en tout cas à celui utilisé par Internet Archive –, en indiquant par exemple que telle ou telle partie du site n’a aucun intérêt à être parcourue par un robot. Car en effet, il y a des sections qui n’ont strictement aucun intérêt pour le public (comme un répertoire /junk ou un autre rassemblant des scripts).

Et si l’organisation indique qu’elle répond aux demandes de retrait qui lui sont adressées, on doute qu’elle puisse le faire si des requêtes arrivent par centaines ou milliers du monde entier.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !