Depuis l’élection surprise de Donald Trump, à la fin 2016, les bulles de filtrage se sont imposées comme un enjeu de toute première importance. En effet, leur influence est pointée du doigt à des moments critiques de la vie en société, par exemple avant un scrutin électoral, en confortant le point de vue de chaque internaute par un ensemble de traitements algorithmiques.

Facebook a longtemps contribué à tisser ce « cocon numérique », en estimant que les internautes appréciaient voir des informations en rapport avec leurs goûts et leurs préférences. Pour cela, le réseau social se base sur divers signaux issus des profils (comme les commentaires, les liens partagés ou lus, le temps qui y est consacré, etc.) et leur montre ensuite des contenus qui sont censés leur plaire.

Tout ceci ne serait sans doute pas bien grave si l’on ne partageait que des photos de chatons. Le fait est que le site permet aussi de partager de l’actualité et que les systèmes algorithmiques de Facebook sont en mesure de ratisser très large ; dès lors, le risque est que le site vous maintienne dans votre zone de confort intellectuel, en vous montrant des articles similaires à ceux qui ont déjà été lus par exemple.

Ce phénomène, Facebook tente aujourd’hui de le combattre, alors que des initiatives ont aussi émergé pour essayer de percer ces bulles.

Cette prise de conscience est nécessaire : ces bulles de filtrage sont susceptibles de renforcer ou de valider une opinion et une lecture du monde, en nourrissant des idées préconçues. Or, quand l’on sait que les réseaux sociaux sont une source croissante d’information, il est normal de se demander quelle influence ont ces bulles sur la démocratie.

Surtout à l’heure où la crainte du moment est la propagation de la désinformation sur le net et plus particulièrement sur Facebook.

Comment Facebook trie l’actualité ?

Lorsque l’on est soi-même sur Facebook, il est difficile de se rendre compte de l’effet des bulles filtrantes et des algorithmes sur l’organisation de l’actualité. Le travail réalisé par des membres de la World Wide Web Foundation cherche justement à mettre en lumière, et en graphiques, les effets de ce processus sur l’information et sur la façon dont il peut peser au moment où l’opinion publique se forme.

Le test a consisté à créer six faux profils en leur faisant apprécier certaines pages avec le bouton « J’aime », et pas d’autres, pour voir ce qui est montré ou non.

https://twitter.com/avilarenata/status/988352426322419712

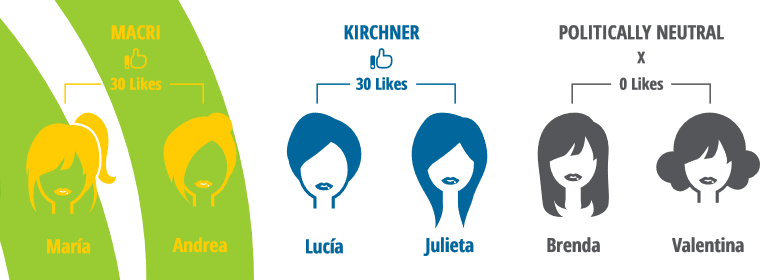

Afin d’échapper aux biais, il a été décidé de faire en sorte que ces six comptes soient aussi identiques que possible. Ainsi, ils ont été créés le même jour à Buenos Aires, en Argentine, et ont été réglés comme s’ils appartenaient à six femmes — Lucía, Julieta, Brenda, Valentina, María et Andrea — d’une trentaine d’années. Aucune information particulière n’a été renseignée, hormis l’âge et le nom.

« Ces six profils ont été mis en place pour suivre les 20 mêmes pages Facebook — gérée par des sources d’information en ligne — et 2 pages politiques (l’une appartenant à Mauricio Macri, l’actuel président, et l’autre à Cristina Fernández de Kirchner, l’ancienne présidente et une figure clé de l’opposition) », explique la fondation pour présenter son test et la méthodologie qui a été appliquée.

« Le 15 décembre — une semaine après le début de l’expérience — nous avons polarisé nos profils. Le but de la variation était de déterminer si cette légère polarisation entraînerait des changements dans les nouvelles transmises à un utilisateur de Facebook », poursuit la fondation. Deux profils ont aimé 30 publications de Macri, deux autres 30 messages de Kircher et les deux derniers sont restés politiquement neutres.

Le test, qui a duré onze jours, s’est déroulé en deux temps. Une première partie du 8 au 15 décembre, juste avant la polarisation des opinions, puis une seconde, du 16 au 19 décembre, après le ralliement de certains profils à Macri ou Kirchner. La période était politiquement intéressante, car il y avait alors des débats sur la réforme du système public de retraite et des réunions de l’OMC dans le pays.

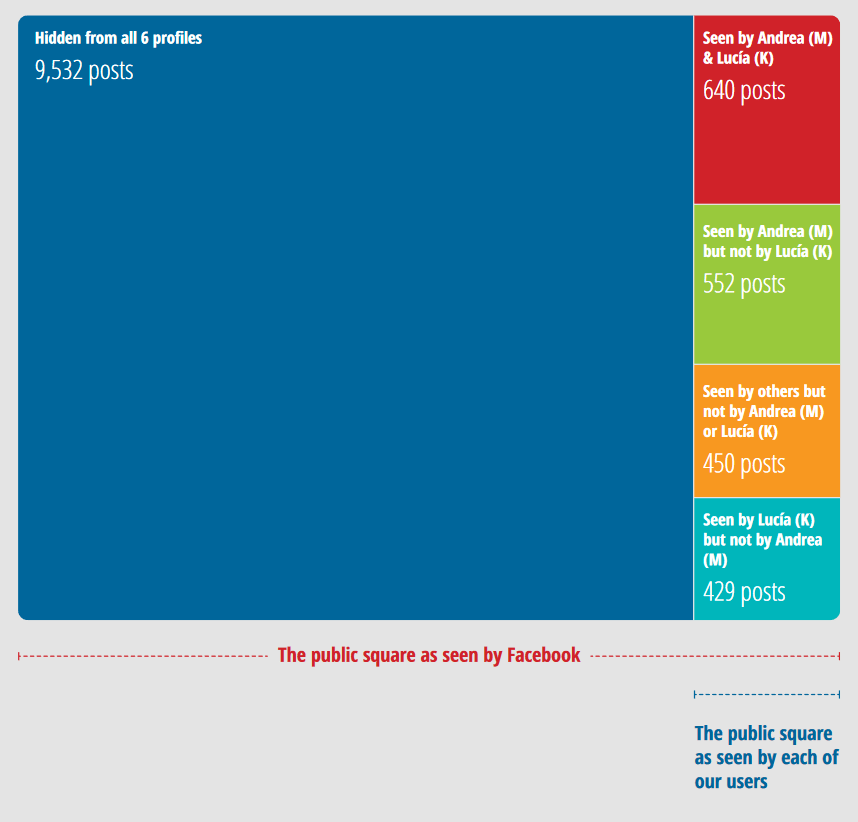

Pendant la période au cours de laquelle l’expérience s’est déroulée, il a été noté que les 22 pages (les 20 des médias et les 2 des deux chefs d’État) ont publié un total de 11 603 messages. Mais il s’avère que l’immense majorité de ces contenus n’a pas été vue par ces six profils : en effet, 9 532 publications sont restées hors du flux d’actualité de ces six (fausses) Argentines. Soit 82 % de la totalité.

Dans le détail, Andrea (pro-Macri) et Lucía (pro-Kirchner) ont chacune vu 640 posts. En revanche, Andrea en a vu 552 autres qui n’ont pas été poussées vers Lucía. 450 messages ont été vus par les quatre autres profils mais pas Andrea et Lucía Enfin, 429 publications ont été vues par Lucía mais pas par Andrea. Ensemble, elles n’ont vu que 18 % de l’activité des pages (2 071 messages).

Bien sûr, l’on peut tout à fait rétorquer que le flux d’actualité serait très vite surchargé s’il n’y avait pas une sélection automatique opérée par Facebook : car ici, le suivi n’a impliqué que 22 pages. Or, en l’espèce de onze jours, elles ont déjà généré 11 603 publications. Pour un profil standard, il faut aussi ajouter les contenus publiés par d’autres pages, mais aussi ceux mis en ligne par la liste de contacts.

« Ces décisions de filtrage placent Facebook dans une position de contrôle sur le discours public »

« Ce que nous observons, c’est que, par l’utilisation d’algorithmes, les plateformes placent chaque utilisateur dans des versions séparées [du service], qui sont micro-gérées par leurs algorithmes. Ces décisions de filtrage placent Facebook (et d’autres plateformes) dans une position de contrôle sur le discours public, ce qui entraîne des responsabilités-clés pour les entreprises », observe la fondation.

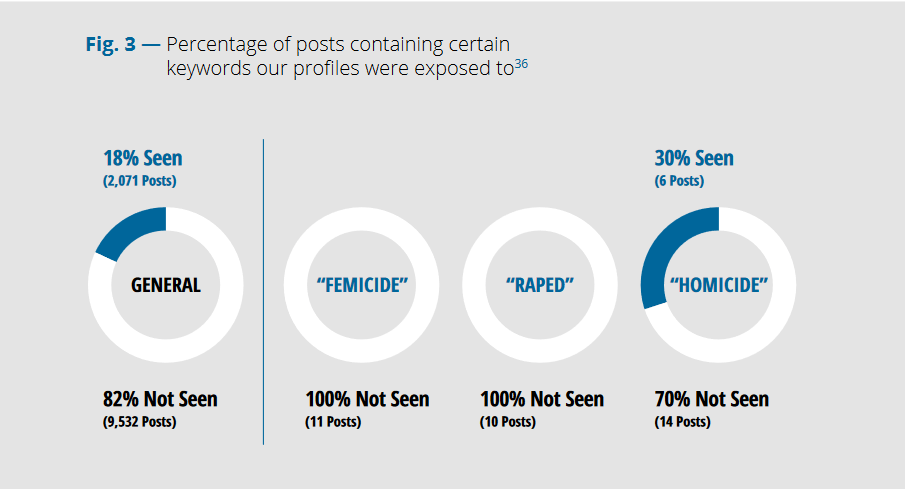

Surtout lorsque les algorithmes font passer sous silence, et de manière certes involontaire, des enjeux sociétaux majeurs : au cours de la période, 11 publications portaient sur le meurtre de femmes et 10 autres sur le viol. Aucun des six profils féminins ne les a vues. Sur le meurtre d’hommes en revanche, il y a eu 20 publications mais seules 6 d’entre elles (30 %) ont été vues, les 14 autres n’ont pas été affichées.

Selon la fondation, trois Argentins sur cinq passent par Facebook pour lire l’actualité. Or, fait remarquer l’étude, « ces deux questions [sur le viol et le meurtre des femmes] ont pris une importance accrue dans le discours public et politique, et elles ont notamment conduit à des protestations sociales (sur les médias sociaux et dans la rue) ». Mais encore faut-il pouvoir être confronté à cette problématique.

« Notre recherche révèle que les algorithmes de Facebook semblent décider quels journaux vous recevez, quand vous les recevez et ce que vous trouverez à l’intérieur », conclut la fondation, en avançant des suggestions, notamment à Facebook, pour atténuer ces effets. Des recommandations que le site est invité à suivre, tant son empreinte « affecte la circulation de l’information, le discours public et la société dans son ensemble ».

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !