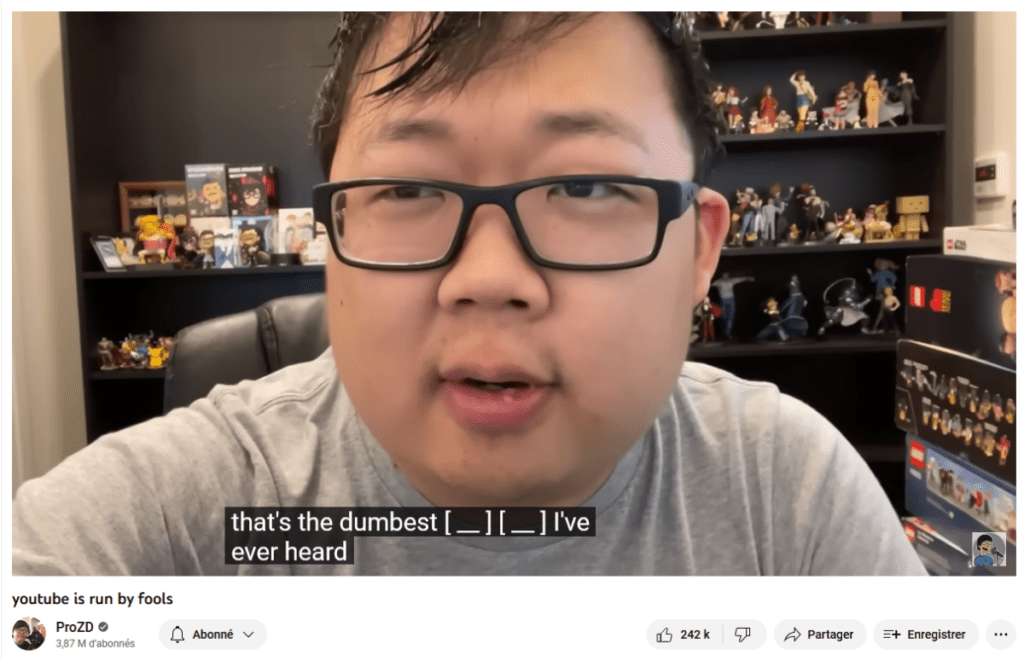

En début d’année, youtubeurs et youtubeuses ont fait une drôle de découverte : ils et elles n’avaient plus le droit de dire des gros mots. En cause, un changement des règles internes de YouTube concernant les contenus « appropriés pour les annonceurs« , c’est-à-dire qui ont le droit d’engranger des revenus publicitaires. Il n’était plus autorisé d’utiliser des mots vulgaires dans les 8 premières secondes d’une vidéo, à de rares exceptions près. Ce bouleversement a très vite été critiqué par les créateurs et les créatrices, qui ont dénoncé des règles opaques et bizarrement strictes. Certain·es ont perdu le droit de monétiser de vieilles vidéos, publiées avant l’interdiction des mots vulgaires. D’autres ont souligné l’hypocrisie de ce système : pendant que des youtubeurs et youtubeuses sont sanctionné·es pour quelques mots vulgaires, de nombreuses vidéos haineuses ou de grave désinformation échappent à la modération de YouTube et engrangent des revenus publicitaires sans souci (pour des exemples récents, tournez-vous vers le Brésil).

Toute cette situation a fait des remous jusqu’en France, où des créateurs et des créatrices ont été forcé·es de masquer leurs gros mots par des bips sonores. Face aux critiques, YouTube a finalement annoncé qu’il allait réexaminer ces règles pour mieux les « ajuster » (cela concerne aussi les vidéastes français·es). On pourrait en rester là, et je pourrais fièrement vous écrire : putain, j’en ai déjà fini avec cette newsletter ! Sauf que cette histoire est, selon moi, emblématique d’un phénomène plus large. Petit à petit, des mots disparaissent du web.

La modération automatique pénalise les personnes qu’elle est censée protéger

Le problème est simple : il y a beaucoup de contenus immondes en ligne. Cela pose deux difficultés majeures aux grandes plateformes. La première, c’est que ces contenus mettent parfois en danger leurs utilisateurs ou leurs utilisatrices, parce qu’il s’agit de harcèlement ou de propos violents envers certaines catégories de personnes. Mais, il s’agit aussi d’un enjeu financier. Dans un écosystème en ligne dont le modèle économique repose encore principalement sur l’affichage de publicités, il est important que les annonceurs (les entreprises qui paient pour afficher des réclames sur telle ou telle plateforme) soient satisfaits. Or, croyez-le ou non, mais Coca-Cola n’aime pas spécialement voir son logo s’afficher à côté de propagande terroriste ou d’un mème antisémite. En 2017, YouTube a d’ailleurs subi un boycott inédit de plusieurs grandes marques qui avaient découvert leurs campagnes sur des vidéos haineuses. Et, puisque la modération en ligne est un grand bazar, les plateformes optent donc généralement pour des solutions de détection automatique de contenus dits problématiques. L’idée est, qu’au mieux, ces publications seront vite supprimées ou, au pire, elles ne seront pas associées à des publicités, et n’engrangeront donc pas de revenus.

La modération automatique est un système qui fonctionne mal. Elle ne repère pas forcément les contenus violents. Pire, elle est facilement manipulable, et elle a tendance à pénaliser les personnes qu’elle est censée, techniquement, protéger (si j’empêche l’utilisation d’une insulte, personne ne se fera insulter). C’est Twitter qui censure les mots « pédé » et « gouines« , ou la phrase « comment fait-on pour que les hommes cessent de violer« ? C’est TikTok qui, pendant au moins quelques mois, a empêché les personnes dans des maisons délabrées ou avec des handicaps visibles d’apparaître dans ses recommandations, officiellement pour des raisons de « lutte contre le harcèlement« . On ajoute à tout ceci l’opacité habituelle du fonctionnement des réseaux sociaux, et on obtient une paranoïa généralisée chez les internautes, qui s’auto-censurent à cause de règles de modération réelles ou supposées. On a déjà parlé ici de « l’algospeak« , un phénomène né sur TikTok, où des jeunes internautes utilisent des métaphores plus ou moins absurdes (seggs, le$bean, depre$$ion, etc) pour parler de sujets qui ne sont ni violents ni dangereux. Il se généralise ailleurs. Chez certain·es de mes youtubeurs et youtubeuses préféré·es, on emploie désormais des subterfuges pour éviter de parler de sexualité, de drogues, d’alcool ou de mort.

Même si l’utilisation de faux mots pour échapper à la modération a toujours existé en ligne (n’importe qui ayant un peu trop traîné sur des forums entre 1990 et 2010 pourra en témoigner), c’est l’automatisation de cette pratique qui m’inquiète. Plutôt que de craindre l’écriture inclusive (un enrichissement de notre langage qui suit l’évolution de notre société), on pourrait se préoccuper davantage de cette restriction progressive des mots que nous utilisons sur le web. Non pas parce que le monde change, mais parce que de grandes entreprises sont dépassées par leurs problèmes. Peut-on encore leur dire merde ?

La revue de presse de la semaine

Libérez (enfin) les tétons

Depuis 2020, Meta (maison mère de Facebook) s’est doté d’un conseil de surveillance indépendant, l’Oversight Board, qui est chargé d’examiner les décisions de modération du réseau social qui font le plus débat, et parfois de les annuler. Hier, l’organisme a rendu un avis très intéressant concernant la fameuse censure des tétons sur Facebook ou Instagram. Un couple de personnes trans et non-binaires protestait contre la suppression d’une photo les montrant poitrine nue, mais avec les tétons couverts. Meta avait estimé que cette photo violait ses règles contre les contenus à caractère sexuel. À tort, a estimé l’Oversight Board, qui en a profité pour critiquer plus généralement ses règles floues concernant la nudité, « qui entravent la liberté d’expression des femmes, des personnes trans et non-binaires [sur Instagram et Facebook] (…) avec un impact encore plus important sur les personnes LGBTQI+« . Plus de détails (en anglais) du côté d’Engadget.

Alerte

Vous connaissez peut-être Hoshi pour ses chansons d’amour. En coulisses, la chanteuse française subit depuis plusieurs années un cyberharcèlement violent. Il s’organise notamment via le forum 18-25 du site jeuxvidéo.com, déjà réputé pour d’autres affaires du même genre (à noter qu’elle a d’aussi subi des attaques sexistes, grossophobes ou homophobes provenant de médias tout à fait traditionnels, car internet n’a pas le monopole de la haine). Hoshi a dénoncé la semaine dernière l’incapacité de la justice française à retrouver et à condamner ses agresseurs en ligne, et en appelle désormais à Emmanuel Macron. C’est à lire sur le site de France Inter.

À l’aide, mon IA me harcèle

À l’origine, Replika est un chatbot qui prétend donner à ses utilisateurs et utilisatrices « un· ami·e virtuel·le« , capable de répondre à leurs messages grâce à des procédés d’intelligence artificielle. Contre un abonnement payant, on peut choisir que le logiciel agisse de manière romantique, voire érotique. Problème : pour certain·s internautes, l’expérience a viré au harcèlement sexuel de la part d’un logiciel aux propos beaucoup plus agressifs qu’attendus. C’est à lire (en anglais) chez Vice.

Grand seigneur

On s’éloigne un tout petit peu des sujets de prédilection de cette newsletter, mais je vous recommande la lecture de cette interview de l’économiste Cédric Durand, récemment publiée par L’Obs, à propos des ambitions d’Elon Musk. Selon le maître de conférences, l’acquisition de Twitter par l’homme le plus riche du monde s’inscrit dans une logique « techno–féodale« , dont le but serait de contrôler les données et leurs capacités de traitement. J’ai trouvé cette idée passionnante, quoique terrifiante. C’est à lire par ici (article réservé aux abonné·es).

Quelque chose à lire/regarder/écouter/jouer

Dans un univers fantastique où des clercs sont chargé·es d’archiver l’histoire du royaume, l’adelphe Chih enquête sur la vie d’une impératrice récemment décédée. Iel se rend dans son ancienne maison, où elle a été exilée pendant de longues années, et y rencontre son ancienne servante, Lapin. Cette dernière refuse de répondre aux questions frontales. C’est en examinant différents objets du quotidien que Chih parvient, petit à petit, à percer le mystère qui entoure l’impératrice.

J’ai dévoré L’impératrice du Sel et de la Fortune, dont un exemplaire m’a gentiment été envoyé par les éditions L’Atalante (merci !). Il s’agit de la première novella (une histoire courte, généralement aux alentours de 20 000 mots) d’un cycle de trois contes, Les archives des Collines-Chantantes, par l’autrice américaine Nghi Vo. L’archiviste Chih y est un·e personnage récurrent·e. Pourtant, iel n’est pas l’héro·ïne de ces épopées. Dans L’impératrice du Sel et de la Fortune, ce sont les secrets de l’impératrice et de Lapin qui nous obsèdent, et c’est au travers d’objets banals, plutôt que des reliques glorieuses, qu’elles se dévoilent : des dés, des ustensiles de cuisine, des boîtes de rangement, une robe, etc. Les puissant·es ne sont pas forcément celles ou ceux que l’on croit. Et c’est dans l’intime que le pouvoir prend racine.

L’impératrice du Sel et de la Fortune, de Nghi Vo, éditions L’Atalante

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !