Microsoft a revu et corrigé sa copie en matière de reconnaissance faciale. L’entreprise américaine, qui avait été apostrophée par des spécialistes informatiques en début d’année parce que son outil de détection souffrait de biais algorithmiques, annonce mardi 26 juin avoir procédé à des changements techniques pour mieux percevoir les visages figurant sur les photographies.

Mais de quel souci parle-t-on ?

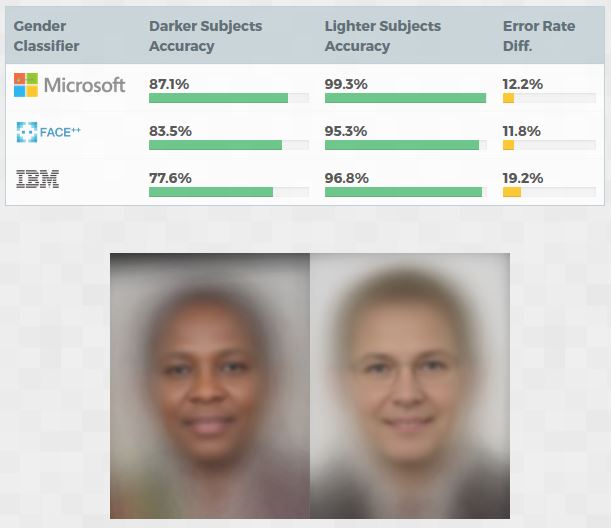

D’un biais ethnique. Une étude du MIT Media Lab a en effet mis en évidence que trois technologies de reconnaissance faciale, dont celle de Microsoft, identifiaient mieux les personnes à la peau blanche, surtout les hommes, que celles dont la pigmentation est plus sombre. La précision de l’outil de Microsoft atteignait alors 99,3 % pour les personnes à la peau claire et 87,1 % pour les autres.

Résultat des courses, Microsoft avec son outil Face API avait plus de mal à identifier le genre des personnes non blanches, en particulier celles de sexe féminin. La raison ? Il s’avère que les outils de reconnaissance faciale sont entraînés avec un volume excessif de clichés montrant justement des personnes à la peau blanche, par rapport aux clichés qui montrent d’autres ethnies.

Tenant compte des observations de l’étude, Microsoft dit que « l’équipe de Face API a apporté trois changements majeurs : elle a élargi et révisé les jeux de données pour former l’algorithme et servir de point de référence, lancé de nouveaux efforts de collecte de données pour améliorer davantage les données d’entraînement en se concentrant spécifiquement sur le teint de la peau, le sexe et l’âge, et amélioré le classificateur pour produire des résultats plus précis ».

D’après le géant du logiciel, ces ajustements ont permis de diviser par 20 le taux d’erreur pour les hommes et les femmes à la peau sombre, dans le meilleur des cas. Quant aux femmes, le taux d’erreur a été divisé par 9. Spectaculaire et encourageant, mais il faudra toutefois que ces affirmations puissent être vérifiées par des tests indépendants, que ce soit par le MIT Media Lab ou d’autres.

À travers cet épisode, c’est l’enjeu des biais dans l’apprentissage automatique qui est posé. Cela ne concerne pas uniquement la reconnaissance faciale : le problème existe aussi dans le traitement naturel du langage et, par conséquent, reprendre les travers qui existent chez les humains. Le sujet est d’importance, au point d’ailleurs que des scientifiques en font un véritable sujet d’étude.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !