Que ce soit au go ou aux échecs, DeepMind n’a plus grand-chose à prouver : ces jeux de plateau sont parfaitement maîtrisés par ses systèmes d’intelligence artificielle. Ce n’est donc pas par hasard que la filiale de Google spécialisée dans l’IA se tourne vers d’autres défis, vidéoludiques cette fois. Le jeu de stratégie en temps réel StarCraft II est ainsi devenu un terrain d’expérimentation prometteur.

Début juillet, la société britannique a toutefois dévoilé que le célèbre RTS de Blizzard n’était pas le seul titre sur lequel elle planche : en effet, un autre jeu vidéo occupe les ingénieurs, un jeu que les moins de vingt ans ne connaissent pas forcément. Il s’agit de Quake III Arena, un titre développé id Software et vendu par Activision à partir de décembre 1999. Il y a donc presque… vingt ans.

L’IA joue à capturer des drapeaux

Les travaux de DeepMind sur Quake III Arena ont été présentés le 3 juillet sur le blog de l’entreprise. On y apprend à la lecture de l’article que c’est un mode bien précis du jeu qui a été utilisé, celui du CTF (capture the flag, la capture du drapeau). Ici, chaque équipe doit essayer de récupérer le drapeau d’en face, situé dans la base adverse, tout en défendant le sien des incursions ennemies.

Et naturellement, il faut que votre drapeau soit à sa place au moment de ramener celui de l’ennemi pour marquer un point.

Si vous avez déjà joué à ce jeu vidéo culte, qui se joue à deux équipes, vous savez que la clé du succès ne repose pas que sur le niveau de jeu individuel : il faut aussi un bon degré de coopération pour que l’équipe se coordonne entre l’attaque et la défense. C’est justement cette dimension qui a intéressé DeepMind en axant ses recherches sur la collaboration entre « agents coopératifs complexes ».

Apprentissage par renforcement

« Grâce à de nouveaux développements dans l’apprentissage par renforcement, nos agents ont atteint des performances de niveau humain dans Quake III Arena CTF, un environnement multi-agents complexe et l’un des jeux multijoueurs cultes en 3D à la première personne. Ces agents démontrent leur capacité à faire équipe avec d’autres agents artificiels et des joueurs humains », explique DeepMind.

L’apprentissage par renforcement est l’une des voies classiques pour entraîner une plateforme en se basant sur l’expérience et les connaissances précédentes. Cela peut se faire de façon relativement passive : on présente des exemples déjà résolus à l’IA, qui se contente d’observer ce qu’on lui montre, pour ensuite se mettre à l’épreuve via des exercices. Mais un enseignement plus actif est aussi possible.

« Nous formons une population d’agents qui apprennent en jouant les uns avec les autres, fournissant une diversité de coéquipiers et d’adversaires »

DeepMind explique : « au lieu de former un seul agent, nous formons une population d’agents, qui apprennent en jouant les uns avec les autres, fournissant une diversité de coéquipiers et d’adversaires. Chaque agent dans la population apprend de son propre signal de récompense interne, ce qui permet aux agents de générer leurs propres objectifs internes, comme la capture d’un drapeau ».

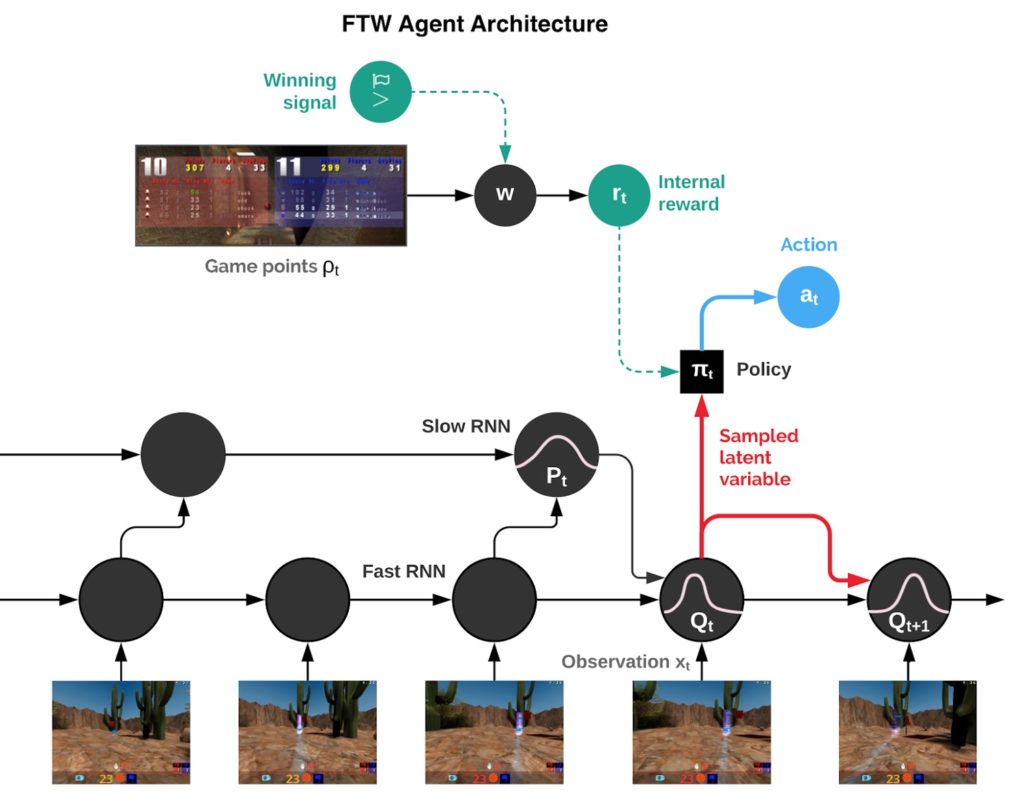

« Un processus d’optimisation à deux niveaux optimise les récompenses internes des agents directement pour gagner, et utilise l’apprentissage par renforcement sur les récompenses internes. Les agents opèrent à deux échelles de temps, rapide et lent, ce qui améliore leur capacité à utiliser la mémoire et à générer des séquences d’actions cohérentes » complète la société.

L’architecture d’apprentissage, avec le signal en cas de victoire et les deux modes d’apprentissage, rapide et lent.

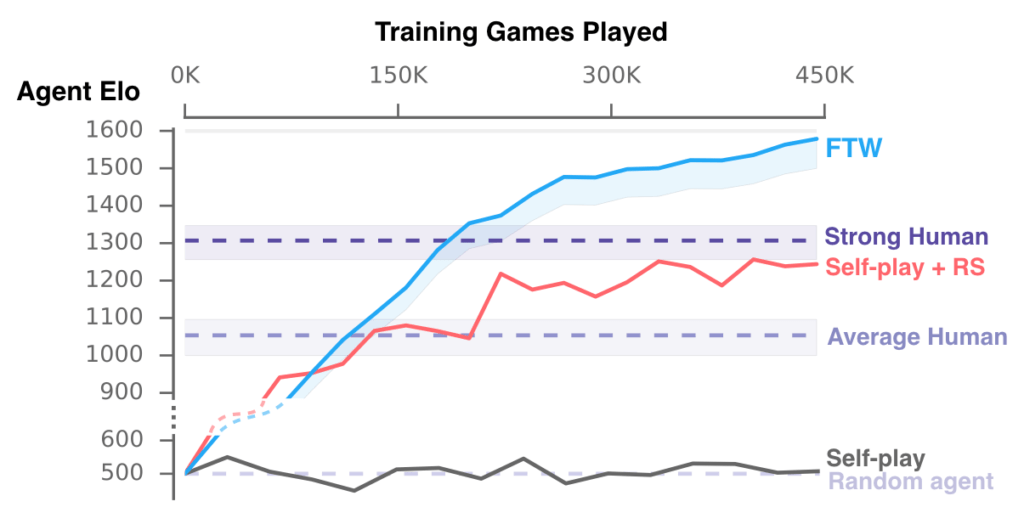

450 000 parties pour dominer

C’est donc avec cette technique que DeepMind a lancé les agents FTW (for the win, pour la victoire, une expression d’encouragement courante dans les jeux vidéo en ligne). Ceux-ci ont été massivement entraînés — pas moins de 450 000 parties ! — pour qu’ils gagnent très vite en compétence. D’après le graphique de progression, ils dépassaient déjà le niveau du joueur moyen après 150 000 parties.

Le plus spectaculaire dans ce travail est l’absence totale de connaissance du jeu des agents FTW au départ. « Nos agents devaient apprendre à partir de zéro comment voir, agir, coopérer et concourir dans des environnements invisibles, le tout à partir d’un seul signal de renforcement par match » leur disant si la partie était gagnée ou perdue. « Il s’agit d’un problème d’apprentissage difficile », observe DeepMind.

Difficile, mais pas impossible : dans le cas des échecs et du go, DeepMind est aussi parti de zéro, en ayant simplement comme base les règles de fonctionnement de chaque jeu. C’est la même logique qui a présidé avec Quake : « Les agents n’ont jamais été informés des règles du jeu, mais ont appris ses concepts fondamentaux et développé efficacement une intuition pour le CTF ».

C’est donc en jouant que les agents ont appris comment jouer, en somme.

DeepMind raconte avoir mis en place un tournoi qui a impliqué 40 joueurs humains et ceux-ci étaient dispatchés dans des équipes mixtes avec des agents FTW. Les équipes étaient constituées au hasard et les coéquipiers de la partie précédente pouvaient devenir ensuite les adversaires de la suivante. Parfois, les matchs opposaient un groupe d’humains contre des agents FTW.

Le résultat est sans appel : les équipes constituées uniquement de systèmes d’IA sont restées invaincues dans les matchs contre des équipes composées exclusivement d’humains. Par ailleurs, elles avaient 95 % de chances de gagner contre des équipes dans lesquelles les humains jouaient avec un agent artificiel. Spectaculaire, tout comme l’est d’ailleurs un autre enseignement :

« En fait, dans une enquête auprès des participants, ils ont été jugés plus collaboratifs que les participants humains », écrit DeepMind. Il n’est toutefois pas besoin d’être grand clerc pour savoir que dans les jeux avec des coéquipiers, la coopération n’est pas toujours la qualité la plus prégnante. Ceux et celles qui jouent à des jeux de tir à la première personne (FPS) à la Quake ont sans doute des tas de récits sur le sujet.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !