Les intelligences artificielles n’étant pas des êtres conscients et autonomes, elles sont entièrement dépendantes de leur code source. Cela signifie qu’elles comportent des biais humains, issus des a priori culturels et sociaux des personnes qui les développent. Parmi ces biais, se pose la question du genre. Jeudi 20 février 2020, Google a annoncé une avancée majeure liée à ce sujet : son IA de traitement des photos ne désignera plus les gens comme « femme » ou « homme ».

Les potentialités sexistes des IA proviennent des équipes humaines qui sont derrière. Comme nous le confiait Dipty Chander (présidente de E-mma, association pour la mixité dans le numérique), dans un article publié en 2018, les intelligences artificielles sont là pour « apporter les solutions », mais celles-ci ne sont pas forcément neutres. Par exemple, « les hommes n’ont pas la même vision du monde que les femmes ». Or, les équipes de développement manquent encore de diversité. C’est ainsi que le HealthKit commercialisé par Apple en 2014 n’offrait pas de possibilité de surveiller les menstruations. En bref, le problème est le suivant : les intelligences artificielles peuvent contribuer à marquer les inégalités sociales.

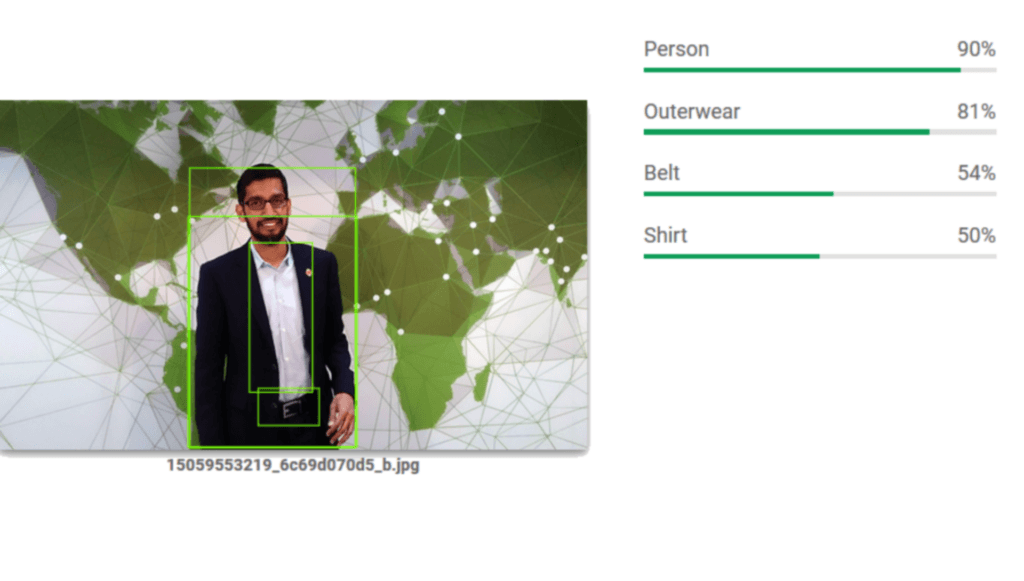

L'API Google Cloud Vision permet de reconnaître les objets et personnes sur les photos, mais aussi des émotions.

Source : Numerama / Google Cloud

L’outil Cloud Vision de Google est un algorithme qui reconnaît automatiquement tout ce qui est présent sur une photo : les humains, leurs émotions, les objets, l’environnement, etc. Lorsque cette IA accole automatiquement l’étiquette « homme » ou « femme » à un visage sur une photo, cela participe à une structuration sociale pré-déterminée : la division de la société en genres. Qui plus est, rien ne dit que la personne étiquetée n’est pas non-binaire ou une personne transgenre en transition. Définir le genre par l’apparence pré-supposée est un biais… auquel vient de renoncer Google.

Des labels non-genrés

C’est dans email adressé aux développeurs que la multinationale a annoncé le changement. Google explique que les labels « femme » et « homme » ne seront plus utilisées par l’IA, remplacés par le terme non-genré « personne ». Deux raisons sont invoquées dans cet email. La première est, comme nous l’avons déjà relevé, qu’un genre ne peut être pré-supposé à partir de l’apparence.

La seconde raison relève de la charte de Google dédiée à l’intelligence artificielle. Le principe n°2 mentionne que « les algorithmes d’intelligence artificielle et les bases de données peuvent refléter, renforcer, ou réduire des biais d’inégalité. […] Nous chercherons à éviter tout impact injuste sur les gens, tout particulièrement sur des caractéristiques sensibles comme l’origine, l’ethnie, le genre, la nationalité, le revenu, l’orientation sexuelle, la capacité et les convictions politiques ou religieuses ».

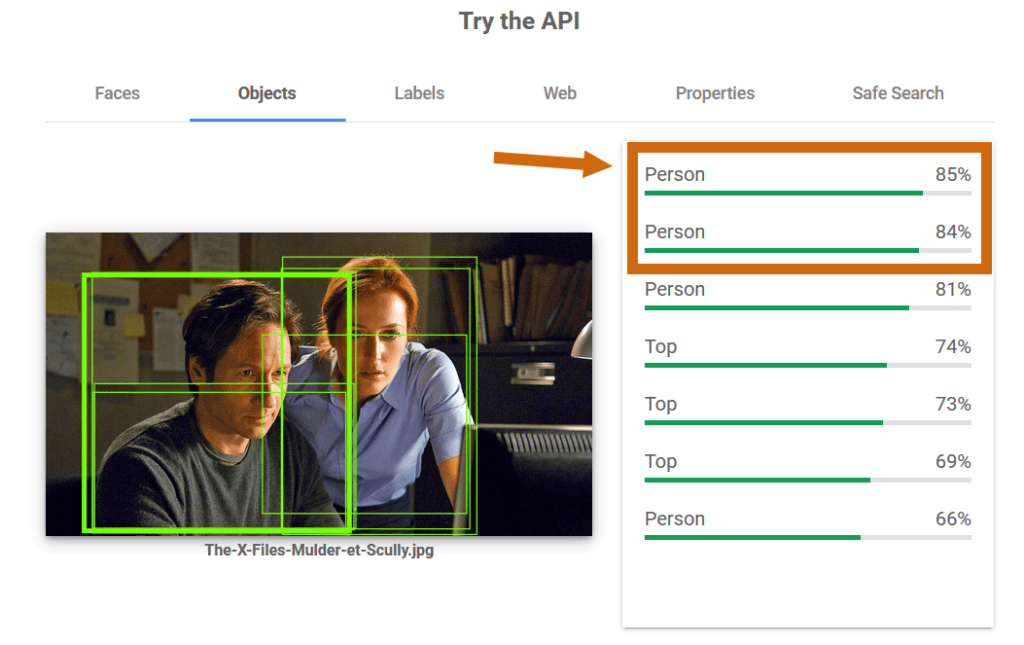

Nous avons testé sur plusieurs photographies via l’API Cloud Vision et il en ressort que le changement est d’ores et déjà en vigueur : c’est bel et bien le terme « personne » qui est utilisé dans la section objets, comme vous pouvez le voir sur l’image ci-dessous.

L'API de Google mentionne bien des personnes et non plus des labels genrés.

Source : Numerama

Cette annonce s’inscrit dans la continuité d’un mouvement de fond pour identifier et réduire tous les biais de conception des intelligences artificielles, mais il reste encore du travail. La couleur de peau reste encore aujourd’hui l’objet de discriminations dans les algorithmes de reconnaissance faciale. Ce type d’IA est encore trop rarement conçu avec une véritable capacité à reconnaître les personnes noires et, en juillet 2019, nous vous relations d’ailleurs l’étude Gender Shades, dont la conclusion montrait qu’un biais de genre en plus d’un biais de couleur de peau entraîne une discrimination des IA plus forte envers les femmes noires.

La déconstruction du genre en IA peut même s’étendre à la voix et à la personnalité que l’on accole aux assistants comme Alexa, Siri. En mars 2019, une équipe de linguistes et d’ingénieurs ont proposé un prototype de voix d’IA non-genrée. Mais cette voie ne colle pas toujours avec les stratégies des entreprises visant plutôt à personnifier leurs assistants, comme c’est le cas notamment pour Alexa.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !