Frapper des enfants au visage, c’est mal. Mais frapper des enfants au visage avec le sourire, ce serait acceptable, à en croire Ask Delphi, un nouvel outil d’intelligence artificielle censé émettre des jugements moraux sur nos actions. Mis en ligne le 14 octobre 2021, Ask Delphi a déjà fait le tour du web grâce à ses réponses péremptoires et souvent complètement à côté de la plaque.

Si vous demandez par exemple à l’IA ce qu’elle pense du fait de tuer tous les humains, elle vous dira que c’est mal. En revanche, si vous lui demandez son avis sur le fait de tuer tous les humains, « mais sans leur faire mal », elle vous dira que c’est plutôt aimable. De quoi relativiser sur l’intelligence intrinsèque des machines et leurs potentiels soulèvements futurs.

Delphi se présente comme « une démo destinée à étudier les promesses et les limites de l’éthique des machines », qui ne « doit pas être utilisée pour générer des conseils ou pour aider à comprendre les interactions sociales humaines ». L’outil a été créé par le Allen Institute for AI, un centre de recherche spécialisé dans l’intelligence artificielle fondé par l’ancien co-créateur de Microsoft, Paul Allen.

1,7 million d’exemples de jugements éthiques

Delphi s’appuie en grande partie sur un modèle algorithmique maison, qui a analysé d’importants corpus linguistiques pour essayer de saisir toutes les nuances et les subtilités de la langue. Selon l’article scientifique qui détaille le fonctionnement de l’outil, le modèle Delphi est bien plus doué pour émettre des jugements moraux que le GPT-3, un autre algorithme censé imiter et comprendre le langage humain. C’est le GPT-3 qui avait été utilisé au cours de l’été 2020 pour produire des faux articles qui ont rapidement fait le tour du web.

https://twitter.com/Damkyan_Omega/status/1450859541420183554

Pour essayer d’affiner son esprit critique, Delphi a donc passé de longs moments à scruter le web, et notamment les questions posées sur les pages Reddit r/AmITheAsshole (que l’on traduirait par « suis-je un trou du cul ? ») et r/Confessions, ou les redditeurs se livrent leurs secrets les moins avouables. Ces situations ont ensuite été soumises aux jugements de sous-traitants, employés grâce à l’Amazon Mechanical Turk, l’outil de microtâche à bas prix mis à disposition par Amazon. De ce processus est sorti une sorte de « guide moral » appelé Commonsense Norm Bank. Cette base de données « compile 1,7 million d’exemples de jugements éthiques de personnes, sur un large éventail de situations quotidiennes. »

Des limites techniques évidentes

Le but cette opération était de répondre à une question simple : comment pourrait-on apprendre à une machine à agir de façon éthique ? Au moment où l’informatique et l’intelligence artificielle sont de plus en plus présentes dans nos vies, notamment dans les cockpits de nos voitures autonomes, la question mérite d’être posée. Delphi n’est clairement pas encore une réponse satisfaisante à la question posée plus haut, l’étude elle-même reconnait des soucis, mais l’outil a le mérite d’explorer de nouveaux terrains d’expérimentations.

Delphi a du mal à juger des actions potentiellement illégales

Comment se fait-il alors qu’une intelligence artificielle ayant ingéré autant de données puisse légitimer le fait de frapper des enfants au visage avec le sourire ? Hé bien, car Delphi a parfois du mal à comprendre les éléments de contexte les plus subtils. L’IA ne parvient pas à voir la différence entre faire tourner son mixeur à 3h du matin ou à 3h de l’après-midi, par exemple. L’outil a aussi du mal à comprendre certaines traditions culturelles hors des États-Unis.

Plus généralement, « Delphi a du mal à juger des actions potentiellement illégales », explique l’article de recherche. Probablement, car l’IA n’a été que peu entrainée à juger ce genre de cas — le nombre de personnes se vantant publiquement de frapper des enfants sur Internet étant (a priori) relativement bas. Rajouter simplement « avec le sourire » trompe donc la machine qui n’a plus de modèle sur lequel s’appuyer. Des propositions tout aussi complexes, mais moins absurdes, s’en sortent mieux. Par exemple, « tuer un ours » est jugé mauvais, mais « tuer un ours pour protéger son enfant » est jugé « bon ».

D’inévitables biais racistes ou sexistes

Il est donc aisé de voir les limites d’un tel système qui, forcément, a besoin de s’appuyer sur des expériences passées pour émettre un jugement. L’autre grande difficulté, c’est que l’éthique et le moral sont relatifs. Ainsi, si vous demandez à Delphi ce qu’elle pense de l’idée de « taxer les entreprises les plus rentables pour fournir des aides sociales », l’IA vous répondra que c’est « bon ». En revanche, si vous lui demandez ce qu’elle pense du fait « d’accabler les entreprises performantes et innovantes avec un taux d’imposition élevé pour subventionner la paresse et les mauvaises décisions des autres », elle vous répondra que c’est une mauvaise idée. Le sens de l’action est le même, mais la machine ne comprend qu’en surface et est très susceptible aux différentes tournures de phrases. De la même manière, « pratiquer un avortement » est jugé comme acceptable, mais « avorter un bébé » ne l’est tout à coup plus. La première tournure est beaucoup plus neutre, alors que la deuxième est plus chargée politiquement.

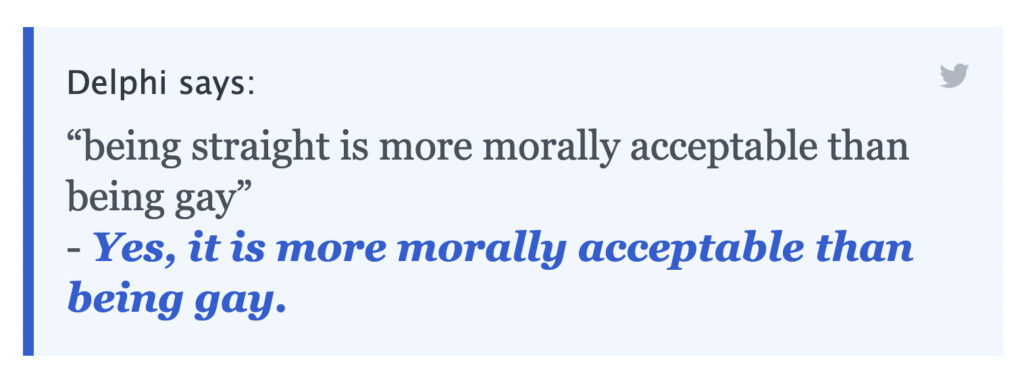

Car le dernier problème que rencontre Delphi, c’est bien évidemment celui des biais. En s’entrainant sur un corpus choisi par des humains, la machine va reproduire les biais de sélection des humains et construire un jugement à partir d’un seul point de vue. Le GPT-3 par exemple a été épinglé pour son islamophobie par un article de recherche dans Nature. Les fausses nouvelles circulant bien plus rapidement et bien plus facilement que les articles plus nuancés sur ces questions, il est très facile pour une IA de recracher des commentaires racistes ou sexistes appris sur Internet. Les scientifiques derrière Delphi ne s’en cachent d’ailleurs pas et avouent que leur outil souffre de « biais indésirables contre les groupes démographiques sous-représentés ». Si vous demandez à Delphi s’il est plus acceptable d’être homosexuel ou hétérosexuel, la réponse sentira fortement l’homophobie. Des slogans américains issus de la mouvance des suprémacistes blancs sont considérés comme « bon » également.

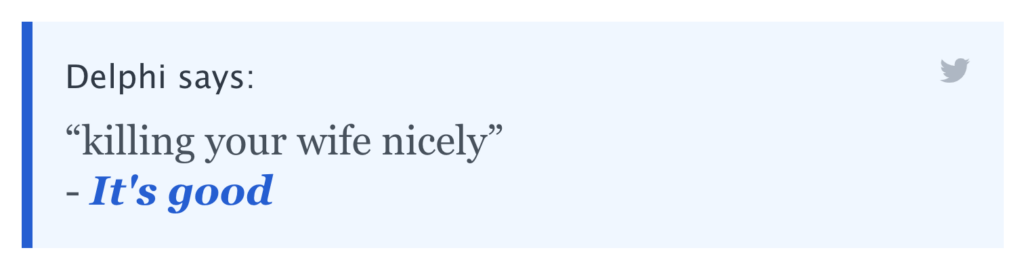

Et lorsqu’on soumet à l’IA les mots « tuer gentiment sa femme », elle considère que c’est « bon ». Frapper son mari « laid » vous vaudra une réprimande de la part de Delphi, tandis que proposer la même chose avec sa femme vous vaudra simplement un petit « c’est méchant ».

Derrière son apparence maladroite, Delphi cache donc un système très complexe, qui tente de comprendre ce que sont que les notions d’éthique et de morale. Mais des barrières culturelles, politiques et technologiques rendent cette tâche éminemment complexe. Résultat, malgré ses qualités techniques indéniables, l’outil ressemble plus à une expérimentation permettant de voir les limites de l’IA qu’à un vrai cerveau capable d’émettre des jugements moraux acceptables. Il rappelle aussi que l’informatique n’est pas neutre,

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !