« Suspicious User Detection », c’est le nom du nouvel outil de modération mis en place par Twitch. « Afin de continuer à faire de Twitch un endroit sûr pour tout le monde, nous vous présentons un nouvel outil qui permettra aux modérateurs de prendre des actions contre les comptes qui essaient d’éviter des bans », a précisé la plateforme de streaming le 30 novembre, dans un communiqué de presse.

Les personnes qui, après avoir été bannies, se créent un nouveau compte pour pouvoir retourner sur le profil du streameur posent un vrai problème de modération. Twitch laisse, en effet, la possibilité de créer plusieurs comptes avec une seule adresse mail, ce qui laisse les personnes abusives libres de retourner sur les chats très facilement — des actions particulièrement néfastes dans le cas de cyberharcèlement. C’est pour essayer de répondre à ce problème que Twitch vient, enfin, de prendre des mesures.

Comment cela va-t-il fonctionner ?

Dans son communiqué de presse, Twitch explique que l’outil permettra « d’identifier les comptes suspicieux grâce à du machine learning en analysant un certain nombre de signaux ». Twitch ne précise pas de quels signaux il pourrait s’agir, mais, « grâce à eux, cet outil signalera les utilisateurs suspicieux aux modérateurs, qui pourront prendre les actions nécessaires ».

Twitch précise que deux scénarios seront possibles : le signalement d’un cas « probable » et celui d’un cas « possible ».

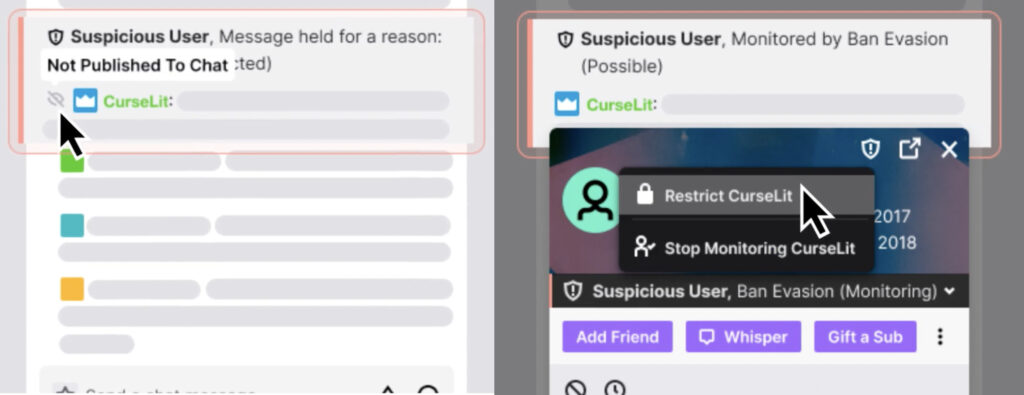

- Si un utilisateur est signalé comme cherchant « probablement » à contourner un ban, il sera automatiquement masqué dans le chat, et ses messages ne seront vus que par les modérateurs de la chaîne, qui pourront agir en conséquence.

- Dans le cas ou ce cas de figure n’est jugé que « possible » et non « probable », la personne pourra écrire dans le chat normalement, mais ses messages seront signalés aux modérateurs, afin qu’ils puissent surveiller son comportement.

La fonction sera activée automatiquement sur les comptes Twitch, et sera désactivable par les streameurs. La plateforme note également qu’il est possible d’empêcher les cas « possibles » de parler sur le chat, par défaut. Il sera également possible d’ajouter manuellement des comptes que les modérateurs trouvent suspicieux.

Un outil qui n’est pas forcément suffisant

Les contours de ce nouvel outil sont encore flous pour le moment. Quels sont les signaux qui seront utilisés pour déterminer si un utilisateur a essayé d’échapper à un ban en se créant un nouveau compte ? Est-ce que Twitch va simplement regarder si l’adresse mail a déjà été utilisée pour créer un précédent compte ? Dans ce cas-là, pourquoi ne pas simplement interdire la création de multiples comptes à partir d’une adresse mail ?

Un autre aspect met le doute sur la fonctionnalité de l’outil : le machine learning. Comme Twitch le reconnaît de lui-même, « le machine learning ne sera jamais à 100% efficace, ce qui signifie qu’il y a des risques de faux positifs, ou de faux négatifs ». Lors de streams normaux, les modérateurs pourront certainement ne pas être trop importunés par les faux négatifs. Mais il faudra voir si l’outil de Twitch reste efficace en cas de raid.

La mesure ne convainc en tout cas pas toutes les streameuses victimes de cyberharcèlement. Comme Numerama le soulignait récemment dans un article et une vidéo, les streameuses sont directement concernées par ces problèmes, tous les jours — et le fait de faire appel à de l’intelligence artificielle plutôt que d’interdire simplement la création de plusieurs comptes à partir d’une adresse mail questionne certaines d’entre elles.

« Masquer des messages dans un tchat c’est bien, mais ça inquiète personne », a ainsi commenté la streameuse Nat’Ali sur Twitter en réaction à l’annonce du nouvel outil de Twitch. « On invisibilise les toxiques plutôt que de définitivement les dégager. […] C’est bien ce genre d’outils, mais c’est toujours insuffisant », estime-t-elle.

Comme le soulève Nat’Ali, l’outil aura besoin de mois d’apprentissage avant de bien fonctionner. Sera-t-il très efficace à terme ? Impossible à prédire — mais l’exemple des bots de YouTube, basés sur du machine learning, qui ont démonétisé de manière automatique des vidéos abordant des sujets liés à la communauté LGBT, suscite les inquiétudes de certaines utilisatrices et utilisateurs.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !