Celles et ceux qui sont abonnés aux pages des actualités américaines tombent régulièrement sur des informations qui se ressemblent : des accidents liés, de près ou de loin, à l’Autopilot de Tesla. Si vous êtes complètement passé à côté des évolutions observées par le marché automobile ces dernières années, il s’agit de l’intelligence artificielle développée par le constructeur américain afin de proposer, à terme, de la conduite autonome.

Aujourd’hui, elle est suffisamment peaufinée pour permettre des assistances autorisant — un peu — de lâcher prise. On navigue clairement dans une zone grise : aujourd’hui, l’Autopilot fournit des aides très avancées, qui peuvent amener les propriétaires à faire… parfois n’importe quoi.

Car il ne faudrait pas négliger la part de responsabilité des humains dans les faillites de l’Autopilot. C’est un souci auquel Tesla est confronté à chaque fois qu’un média s’intéresse à un crash impliquant ses voitures. Au-delà de l’effet loupe (on adore parler de Tesla, puisque c’est un peu le vilain petit canard qui bouscule la hiérarchie établie depuis maintenant plusieurs décennies), il y a cette question à laquelle il est difficile de répondre de manière absolue : à qui la faute, au fond ?

Où en est l’Autopilot aujourd’hui ?

L’Autopilot est un immense pari sur l’avenir. Dans sa volonté de révolutionner le marché automobile, Elon Musk a deux idées majeures derrière la tête : rendre la conduite plus propre (groupe propulseur 100 % électrique) puis, dans un second temps, l’automatiser de A à Z. Le premier objectif est rempli avec brio, quand on se penche sur l’avance de Tesla en matière de performances sur les routes (aussi bien en termes d’accélération que d’autonomie). Aujourd’hui, la multinationale peut regarder ses concurrents dans les yeux, après plusieurs années à enchaîner les gros problèmes.

Le deuxième objectif, à beaucoup plus long terme, est complexe, tant il dépend de nombreux facteurs que ne maîtrise pas Tesla. Il y a la question de la législation, mais aussi des infrastructures. Sur ce point, des récents commentaires ont lancé le débat sur la place que pourrait vraiment occuper la conduite autonome dans l’espace public actuel — et futur. On pense ainsi à la sortie médiatique du patron de Toyota, qui estime que « les véhicules autonomes ne peuvent pas encore être déployés sur des routes normales de façon réaliste », consécutive à une collision entre une navette de son entreprise et un athlète aveugle sur le village paralympique de Tokyo.

Même Elon Musk, pourtant connu pour son optimisme, a rétropédalé sur la conduite autonome. « La conduite autonome généralisée est un problème compliqué, puisqu’il faut composer avec l’intelligence du monde réel. Je ne m’attendais pas à ce que ça soit si dur, mais le challenge est évident en y repensant. Rien n’a plus de degré de liberté que la réalité », soufflait-il en juillet 2021, après des années à promettre des délais trop compliqués à tenir. En 2015, le même Elon Musk annonçait « de la conduite autonome d’ici 3 ans ». Soit en 2018. Soit il y a 3 ans.

Dans un article publié sur TechCrunch le 16 août, l’agence fédérale américaine des États-Unis chargée de la sécurité routière (la NHTSA) a rappelé qu’aucun véhicule commercialisé aujourd’hui n’est capable de conduire seul. Ladite agence a par ailleurs ouvert une enquête sur l’Autopilot, en raison d’une succession de collisions. Elle concerne 765 000 véhicules Tesla (Model S, X, 3 et Y) produits depuis 2014. Par le passé, il est arrivé au National Transport Safety Board (NTSB) de dédouaner l’Autopilot à l’issue d’investigations. Une preuve que le sujet est délicat à traiter, en l’absence de référentiels précis.

L’Autopilot, ou la technologie de pointe qui devrait rester un peu plus en laboratoire

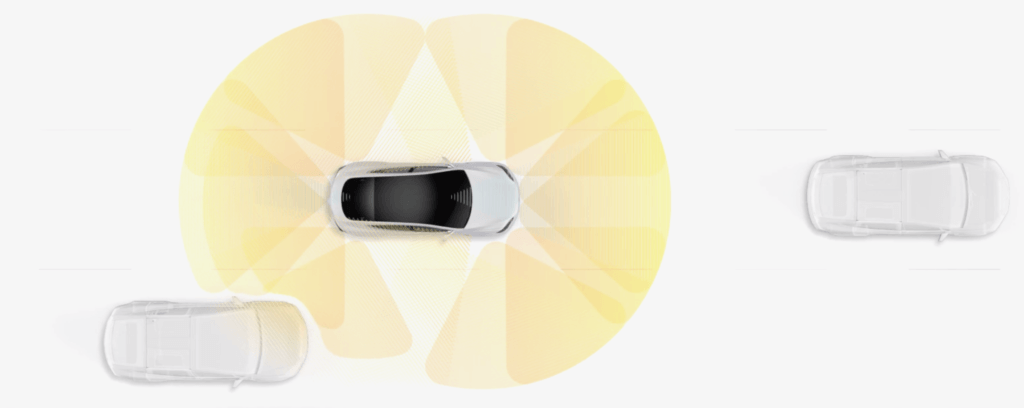

Malgré d’immenses contraintes, Tesla a suffisamment développé l’Autopilot pour garantir des super-aides à la conduite. Aujourd’hui, le pack ‘Autopilot amélioré’, facturé 3 800 €, permet de laisser la voiture gérer le trajet de A à Z sur certaines voies rapides (y compris les changements de voies, qu’on doit quand même valider avec le clignotant). Numerama a pu tester cette fonctionnalité sur un trajet entre Paris et Lille, et nos impressions sont plus que positives. On gagne en confort, tout en ayant un aperçu de ce que sera, peut-être, la conduite de demain (quand on pourra vraiment lâcher le volant).

Pour faire progresser son intelligence artificielle, Tesla doit emmagasiner un grand nombre de données lui permettant d’apprendre et de s’entraîner. Et les ingénieurs ont vite compris le besoin de faire tester un maximum de choses aux propriétaires, qui deviennent alors des cobayes pour satisfaire cette course aux progrès (il n’y a rien de mieux que des retours en provenance du terrain). Le hic : Tesla a tendance à mettre à disposition des technologies un peu trop avancées, qui peuvent s’avérer dangereuses quand elles sont mal utilisées. La route reste un environnement dangereux et ne peut pas devenir un vaste laboratoire pour les constructeurs plus orientés tech.

Ce biais lié au développement technologique exige de Tesla qu’il soit le plus prudent possible. C’est pourquoi le configurateur précise : « Les fonctionnalités actuelles exigent une surveillance active de la part du conducteur et ne rendent pas le véhicule autonome. Certaines fonctionnalités requièrent l’activation des clignotants et ont une portée limitée. L’activation et l’utilisation future de ces fonctionnalités sans surveillance dépendent d’une fiabilité prouvée par des milliards de kilomètres de test pour être significativement supérieure à celle des conducteurs humains. » C’est une manière de se protéger, d’un point de vue médiatique. En revanche, ce message d’alerte n’empêche pas les dérives humaines. En volet supplémentaire, Tesla a commencé à activer depuis peu une surveillance accrue, qui passe par une caméra intérieure chargée d’observer l’attention.

La responsabilité humaine

D’un côté, nous avons donc Tesla qui met régulièrement en avant le gain en sécurité octroyé par l’Autopilot. Elle a commencé à le faire avec des rapports réguliers. Le dernier en date, correspondant à la période du premier trimestre 2021, fournit les données suivantes : un accident tous les 6,75 millions de kilomètres avec l’Autopilot, un accident tous les 3,3 millions de kilomètres sans l’Autopilot et un accident tous les 1,6 million de kilomètres sans aucune aide active. « À titre de comparaison, les données les plus récentes de la NHTSA montrent qu’il y a un crash automobile tous les 779 000 kilomètres aux États-Unis », indique Tesla, qui s’appuie sur ces statistiques pour protéger son intelligence artificielle.

Mais, de l’autre, on peut lire régulièrement que l’Autopilot pourrait être responsable d’accidents — parfois mortels. Où se trouve la responsabilité ? C’est souvent du cas par cas mais certaines situations tendent à prouver que le facteur humain est davantage en cause. Malgré toutes les dispositions prises par Tesla, il ne peut empêcher les casse-cou de pousser la technologie dans ses retranchements ou les petits malins de faire appel à des subterfuges. Il ne peut empêcher les propriétaires les plus malavisés de faire n’importe quoi avec la fonctionnalité Smart Summon (qui permet d’attirer la voiture vers soi depuis un smartphone). Il ne peut empêcher deux amis d’activer l’Autopilot puis de voir si la voiture roule toujours quand on s’installe à l’arrière. Entre de mauvaises mains, l’Autopilot peut effectivement être très dangereux.

Le tort de Tesla, s’il doit y en avoir un, est de développer une technologie prometteuse, mais potentiellement à risque, à disposition de personnes susceptibles d’avoir un comportement dangereux sur les routes. Mais ce serait remettre en cause la nature même de l’industrie automobile. Pourquoi viser uniquement l’Autopilot alors que la vitesse représente déjà un danger en soi ? Après tout, on pourrait tout aussi bien en terminer une bonne fois pour toutes avec les bolides qui dépassent les 150 km/h. Les acteurs du marché considèrent que c’est aux propriétaires de s’auto-gérer, grâce à tout ce qu’ils ont appris au code de la route. S’ils sont capables de ne pas trop appuyer sur l’accélérateur, ils peuvent aussi apprendre à se servir des assistances hyper poussées.

Pour Tesla et, par ricochet, les autres constructeurs, il y a tout de même un gros travail pédagogique à faire. Il permettrait d’éviter les faits divers tragiques, ainsi que la défiance à l’encontre d’une technologie normalement amenée à rendre les routes plus sûres. Aujourd’hui, on navigue un peu trop entre deux eaux, et difficile de désigner un vrai coupable entre un acteur avant-gardiste et des clients qui ne savent pas toujours bien se servir de leur véhicule. À l’arrivée, c’est tout un ensemble de facteurs qui fait émerger des doutes légitimes sur la conduite autonome, articulée autour d’une technologie trop évoluée pour des personnes pas du tout formées. Pour savoir, Il faut apprendre.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !